A menudo sucede que los centros de datos aparentemente ocultos son la columna vertebral de nuestro Internet. Transportan, almacenan y transmiten la información que creamos todos los días.

Cuantos más datos creamos, más vitales se vuelven los centros de datos.

Hoy en día, muchos centros de datos son poco prácticos, ineficientes y obsoletos. Para mantenerlos en buen estado de funcionamiento, los operadores de centros de datos, desde FAMGA hasta centros de colocación, están trabajando para modernizarlos para mantenerse al día con las tendencias de un mundo en constante cambio.

En esta charla, nos sumergimos en muchos aspectos del futuro de los centros de datos y su evolución. A partir de dónde y cómo se crean, qué tipo de energía usan y qué hardware funciona dentro de ellos.

Ubicación El

acceso a las redes de fibra óptica, las tarifas de las fuentes de energía y el medio ambiente juegan un papel importante en la decisión de dónde establecer centros de datos.

Según algunas estimaciones, el mercado global de construcción de centros de datos puede alcanzar hasta $ 57 mil millones para 2025. Esto es todo un desafío, ya que el gigante inmobiliario comercial CBRE ha lanzado una división completa dedicada a los centros

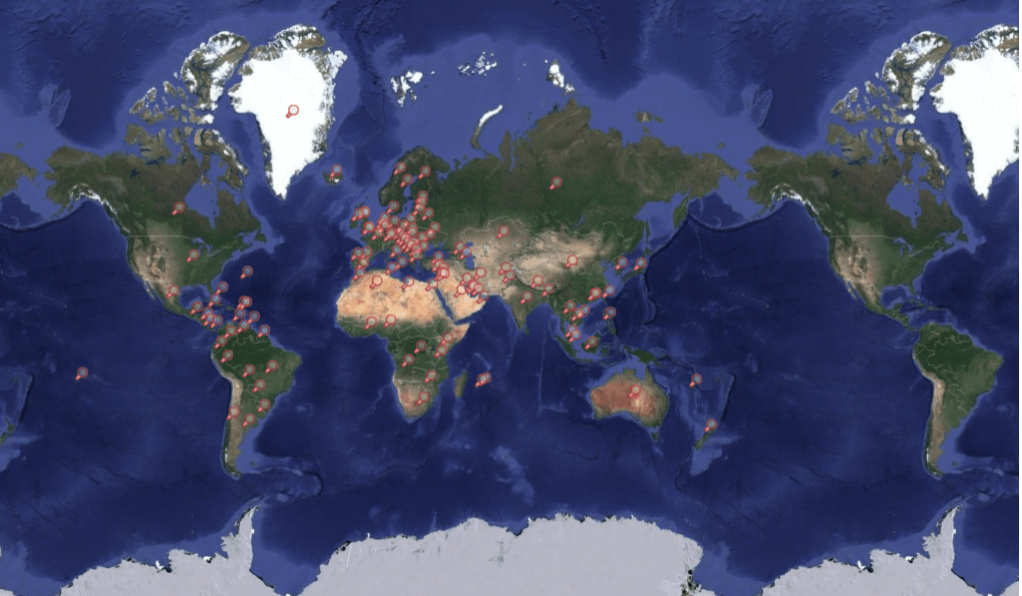

de datos Mapa de centros de datos

Construyendo cerca de fuentes de energía baratas

La ubicación de los centros de datos intensivos en energía cerca de fuentes de energía de bajo costo puede hacer que sean más asequibles para su funcionamiento. A medida que aumentan las emisiones y las grandes empresas tecnológicas utilizan cada vez más la energía sucia para alimentar los centros de datos, las fuentes de energía verde son un factor importante.

Apple y Facebook construyeron centros de datos junto con recursos hidroeléctricos. En el centro de Oregon, Apple adquirió un proyecto hidroeléctrico para proporcionar energía verde a su centro de datos en Prinville. La compañía dijo que los mercados de electricidad desregulados de Oregón son la razón principal por la que construyeron varios centros de datos en el área. La desregulación permite a Apple comprar electricidad directamente de proveedores externos que utilizan fuentes de energía renovables, no solo servicios públicos locales.

En Luleå, Suecia, Facebook ha construido un mega centro de datos junto a una planta hidroeléctrica. En Suecia, los centros de datos comenzaron a aparecer en la región norte, ya que, además de ser frío y no estar sujeto a terremotos, el área tiene muchas fuentes de energía renovables (energía hidroeléctrica y eólica).

Construcción de Facebook en Lulea, Suecia en 2012. Fuente: Facebook

Varios centros de datos importantes ya se han mudado a la región norte, algunos solo lo están mirando.

En diciembre de 2018, Amazon Web Services anunció la apertura de su centro de datos de la Región de Europa de AWS, ubicado a una hora en coche de Estocolmo. En el mismo mes, Microsoft adquirió 130 hectáreas de tierra en dos partes vecinas de Suecia, en Gavle y Sandviken, con el objetivo de construir centros de datos allí.

Además de estar cerca de fuentes de energía limpias y baratas, las empresas de centros de datos también están prestando atención al clima frío. Las ubicaciones cercanas al Círculo Polar Ártico, como el norte de Suecia, podrían permitir a los centros de datos ahorrar en costos de enfriamiento.

La empresa de telecomunicaciones Altice Portugal dice que su centro de datos Covilhã usa aire exterior para enfriar sus servidores en un 99%. Y el antiguo centro de datos de Google en Hamina, Finlandia, utiliza agua de mar del Golfo de Finlandia para enfriar las instalaciones y reducir el consumo de energía.

Verne Global ha abierto un campus en Islandia que se conecta a fuentes geotérmicas e hidroeléctricas locales. Se encuentra en una antigua base de la OTAN y se encuentra entre Europa y América del Norte, los dos mercados de datos más grandes del mundo.

Construcción en economías emergentes

Colocar un centro de datos en un punto de creciente tráfico de Internet reduce la carga y aumenta la tasa de transferencia de datos en la región.

Por ejemplo, en 2018, la empresa china Tencent, propietaria de Fortnite y WeChat, albergó centros de datos en Mumbai. Este paso se ha convertido en una señal de que la región está utilizando activamente Internet y las plataformas de juegos Tencent se están volviendo cada vez más populares.

La construcción de centros de datos en áreas donde Internet es muy utilizado también es un paso comercial estratégico. Si las empresas locales crecen, considerarán trasladar sus operaciones al centro de datos más cercano.

Además, los centros de datos tienen una función de colocación. Esto significa que proporcionan al edificio refrigeración, energía, ancho de banda y seguridad física, y luego alquilan el espacio a los clientes que instalan sus servidores y almacenamiento allí. El servicio de colocación generalmente está dirigido a empresas con pequeñas necesidades, también ayuda a las empresas a ahorrar dinero en infraestructura.

Incentivos fiscales y leyes locales.

Los centros de datos son una nueva fuente importante de ingresos para los productores de electricidad y, por lo tanto, el estado atrae a grandes empresas con diversos beneficios.

A partir de enero de 2017, el gobierno sueco redujo el impuesto en un 97% sobre cualquier electricidad utilizada por los centros de datos. La electricidad en Suecia es relativamente cara y los recortes de impuestos han puesto a Suecia a la par con otros países escandinavos.

En diciembre de 2018, Google acordó una exención del impuesto del 15% al 100% por la venta de un centro de datos en New Albany, Ohio, para un centro de datos por valor de $ 600 millones. La oferta se ofreció con la posibilidad de extensión hasta 2058. En septiembre de 2018, Francia, con la esperanza de atraer talento económico y capital global después del Brexit, anunció planes para reducir los impuestos a la electricidad para los centros de datos.

En algunos casos, la creación de un centro de procesamiento y almacenamiento de datos es una de las formas en que las empresas pueden continuar operando en países con un régimen estricto.

En febrero de 2018, Apple comenzó a almacenar datos en una ubicación central en Guizhou, China para cumplir con las regulaciones locales. En el pasado, las autoridades chinas tenían que usar el sistema legal de los EE. UU. Para acceder a la información de los ciudadanos chinos almacenados en el centro de datos de los EE. UU., Pero ahora el centro de datos local proporciona a las autoridades chinas un acceso más fácil y rápido a la información de los ciudadanos chinos almacenados en la nube de Apple .

Si bien las autoridades chinas anteriormente tuvieron que pasar por el sistema legal de los EE. UU. Para obtener acceso a la información de los ciudadanos chinos almacenados en el centro de datos de los EE. UU., El centro de datos local brinda a las autoridades un acceso más fácil y rápido a la información sobre los ciudadanos chinos almacenados en la nube de Apple.

Conectividad y seguridad de fibra óptica.

Otros dos factores críticos cuando se trata de ubicaciones de centros de datos son la conectividad de fibra y la seguridad sólida.

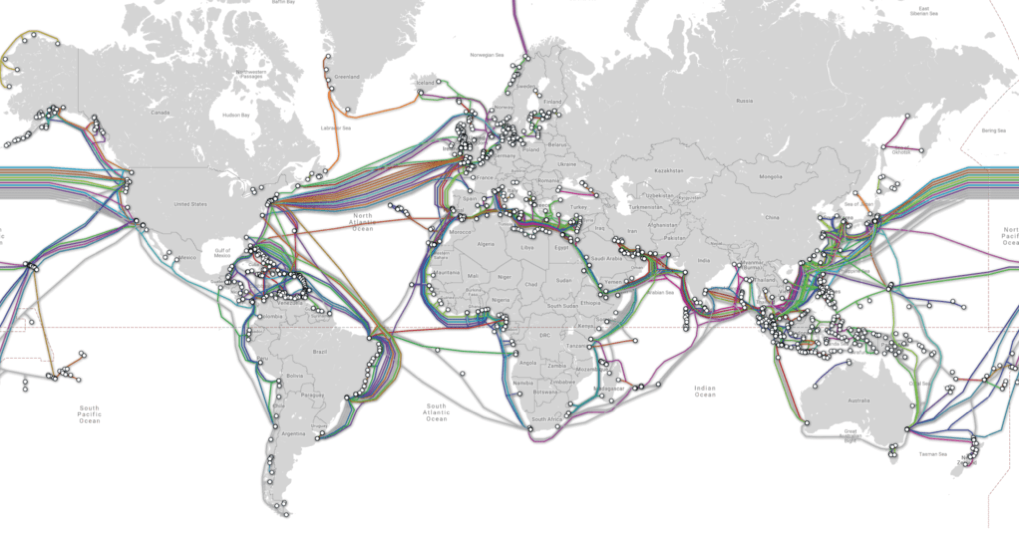

Durante muchos años, las redes de fibra óptica han sido un factor clave en la selección de ubicaciones de centros de datos. Aunque los datos a menudo se transfieren a dispositivos móviles a través de redes inalámbricas o Wi-Fi local.

La mayoría de las veces, los datos viajan hacia y desde el almacenamiento a través de cables de fibra óptica. La fibra óptica conecta los centros de datos con antenas celulares, enrutadores domésticos y otros dispositivos de almacenamiento.

Mapa de cable submarino

Ashburn, Virginia y sus regiones circundantes se han convertido en un importante mercado para centros de datos, gracias en gran parte a la gran red de infraestructura de fibra óptica que la compañía de Internet AOL creó una vez que construyó su sede allí. Mientras que otras compañías como Equinix se mudaron a la región y construyeron sus propios centros de datos, las redes de fibra de la región continúan creciendo, atrayendo cada vez más nuevos centros de datos.

Facebook invirtió casi $ 2B en un centro de datos en Henrico, Virginia, y en enero de 2019, Microsoft recibió una subvención de $ 1.5 millones por sexta vez para expandir su centro de datos en Southside, Virginia.

También están surgiendo nuevas alternativas a las redes de fibra óptica a medida que los grandes técnicos construyen su propia infraestructura de conectividad.

En mayo de 2016, Facebook y Microsoft anunciaron que estaban trabajando juntos para tender un cable submarino entre Virginia Beach, Virginia y Bilbao, España. En 2017, Facebook anunció nuevos planes para construir sus propias 200 millas de red de fibra óptica terrestre en Las Lunas, Nuevo México, para conectar su centro de datos de Nuevo México a otras granjas de servidores. El sistema subterráneo de fibra óptica creará tres rutas únicas en red para el viaje de información a Las Lunas.

Además de la conectividad, la seguridad es otro punto importante. Esto es especialmente importante para los centros de datos que almacenan información confidencial.

Por ejemplo, el gigante financiero noruego DNB, en asociación con el centro de datos Green Mountain, ha creado su propio centro de datos. Green Mountain albergó el centro de datos de DNB en una instalación de alta seguridad, un búnker convertido en la montaña. La compañía afirma que la montaña está completamente protegida de todo tipo de peligros, incluidos ataques terroristas, erupciones volcánicas, tormentas y terremotos.

El centro de datos Swiss Fort Knox se encuentra debajo de los Alpes suizos, con una puerta disfrazada de piedra. Su complejo sistema interno incluye muchos túneles a los que solo se puede acceder con la limpieza adecuada. El centro de datos está protegido por motores diesel de emergencia y un sistema de presión de aire que evita que el gas venenoso ingrese a las instalaciones.

El Fort Knox de Suecia es hiperseguro física y digitalmente. Fuente: Mount 10

Debido al alto grado de seguridad del servidor en algunos centros de datos, hay muchos centros de datos cuyas ubicaciones nunca se han anunciado. La información de ubicación de estos centros se puede utilizar como arma.

En octubre de 2018, WikiLeaks publicó una lista interna de objetos de AWS. Entre la información encontrada se encontraba el hecho de que Amazon era un contendiente para la creación de una nube privada de aproximadamente $ 10 mil millones para el Departamento de Defensa.

WikiLeaks ha tenido dificultades para encontrar el centro de datos adecuado para alojar su información. AWS dejó de alojar WikiLeaks porque la compañía violó los términos del servicio, es decir, publicó documentos para los que no tenía derechos y puso en riesgo a las personas.

Como resultado, WikiLeaks se mudó a muchos centros de datos diferentes. En un momento, incluso hubo rumores de que WikiLeaks estaba considerando colocar su centro de datos en el océano, en el estado no reconocido de Sealand en el Mar del Norte.

Estructura

Si bien podría decirse que la ubicación es el factor más importante para reducir el riesgo de mal funcionamiento del centro de datos, las estructuras del centro de datos también juegan un papel importante para garantizar la confiabilidad y durabilidad.

La construcción adecuada del centro de datos puede hacer que sea resistente a la actividad sísmica, inundaciones y otros tipos de desastres naturales. Además, las estructuras se pueden adaptar para la expansión, reduciendo los costos de energía.

En todos los sectores, desde la atención médica hasta las finanzas y la fabricación, las empresas confían en los centros de datos para respaldar el creciente consumo de datos. En algunos casos, estos centros de datos pueden ser propietarios y estar ubicados en su lugar, mientras que otros pueden compartirse y ubicarse de forma remota.

De cualquier manera, los centros de datos están en el corazón de un mundo tecnológico en crecimiento y continúan experimentando sus propias transformaciones físicas. De acuerdo con la herramienta CB Insights Market Sizing, el mercado global de servicios de centros de datos está valorado en $ 228 mil millones para 2020.

Una de las transformaciones más recientes en la construcción del centro de datos es el tamaño. Algunos centros de datos se han vuelto más pequeños y más extendidos (se llaman centros de datos periféricos). Al mismo tiempo, otros centros de datos son más grandes y más centralizados que nunca, estos son mega centros de datos).

En esta sección, echaremos un vistazo a los centros de borde y mega-datos.

Centros de datos periféricos.

Los pequeños centros de datos distribuidos, llamados centros de datos perimetrales, se crean para proporcionar almacenamiento hiperlocal.

Si bien la computación en la nube ha servido tradicionalmente como un medio confiable y rentable para conectar muchos dispositivos a Internet, el crecimiento continuo de IoT y la computación móvil ha puesto a prueba el ancho de banda de las redes de centros de datos.

Edge computing ahora está surgiendo para ofrecer una solución alternativa. (La computación perimetral es un paradigma de computación distribuida que está al alcance de los dispositivos finales. Este tipo de computación se utiliza para reducir el tiempo de respuesta de la red, así como para hacer un uso más eficiente del ancho de banda de la red).

Esto implica colocar los recursos informáticos más cerca de donde provienen los datos (es decir, motores, generadores u otros elementos. Al hacer esto, reducimos el tiempo que lleva mover datos a ubicaciones informáticas centralizadas, como nubes.

Aunque esta tecnología aún está en su infancia, ya proporciona un método más eficiente de procesamiento de datos para numerosos casos de uso, incluidos vehículos autónomos. Por ejemplo, los vehículos Tesla tienen potentes computadoras a bordo que pueden procesar datos con baja latencia (casi en tiempo real) para los datos recopilados por docenas de sensores periféricos en el automóvil. permite que el automóvil tome decisiones independientes de manera oportuna)

Sin embargo, otras tecnologías avanzadas, como dispositivos y sensores médicos inalámbricos, no tienen la potencia de procesamiento necesaria para procesar grandes flujos de datos complejos directamente.

Como resultado, se están implementando centros de datos modulares más pequeños para proporcionar sistemas de procesamiento y almacenamiento de datos hiperlocales. De acuerdo con la herramienta CB Insights Market Sizing, el mercado informático global alcanzará los $ 34B en 2023.

Estos centros de datos, que suelen ser del tamaño de un contenedor de envío, se encuentran en la base de las torres de celdas o lo más cerca posible de la fuente de datos.

Además del transporte y la atención médica, estos centros de datos modulares se utilizan en industrias como la fabricación, la agricultura, la energía y los servicios públicos. También ayudan a los operadores de redes móviles (MNS) a entregar contenido más rápido a los suscriptores móviles, mientras que muchas compañías de tecnología usan estos sistemas para almacenar (o almacenar en caché) el contenido más cerca de sus usuarios finales.

Vapor IO es una de las compañías que ofrece servicios de colocación y aloja pequeños centros de datos basados en torres de telefonía celular. La compañía tiene una asociación estratégica con Crown Castle, el mayor proveedor de infraestructura inalámbrica en los Estados Unidos.

Otras compañías líderes de centros de datos, como Edgemicro, brindan centros de microdatos que conectan operadores de redes móviles (MNC) con proveedores de contenido (CPS). Los fundadores de EdgeMicro se basan en la experiencia de líderes de organizaciones como Schneider Electric, una de las compañías de energía más grandes de Europa, y CyrusOne, uno de los proveedores de servicios de centros de datos más grandes y exitosos de los Estados Unidos.

Recientemente, la compañía presentó su primera unidad de fabricación y planea vender sus servicios a proveedores de contenido de colocación como Netflix y Amazon, que se beneficiarán de una mayor velocidad y confiabilidad en la entrega de contenido. Estos servicios de colocación son ideales para empresas que buscan poseer, pero no administrar, su infraestructura de datos.

Borde micro

Y las startups no son las únicas en el mercado de centros de datos de borde.

Grandes empresas como Schneider Electric, no solo colaboran con nuevas empresas, sino que también desarrollan sus propios productos para centros de datos. Schneider ofrece varios centros de datos modulares prefabricados diferentes que son ideales para una variedad de industrias que requieren espacio de almacenamiento e informática hiperlocal.

Huawei

Estas soluciones integrales integran sistemas de alimentación, refrigeración, extinción de incendios, iluminación y control en un solo paquete. Están diseñados para una implementación rápida, un rendimiento confiable y monitoreo remoto.

Centros de megadatos

En el otro extremo del espectro hay mega centros de datos, centros de datos con un área de al menos 1 millón de metros cuadrados. pies Estas instalaciones son lo suficientemente grandes como para satisfacer las necesidades de decenas de miles de organizaciones al mismo tiempo, y se benefician enormemente de las economías de escala.

Si bien estos megacentros son costosos de construir, el costo por pie cuadrado es mucho mayor que el costo de un centro de datos promedio.

Uno de los proyectos más grandes es un objeto con un área de 17.4 millones de metros cuadrados. ft. construido por Switch Communications, que proporciona a las empresas alojamiento, refrigeración, alimentación, ancho de banda y seguridad física para sus servidores.

Cambiar

Además de este enorme campus de la Ciudadela en Tahoe Reno, la compañía también tiene un centro de datos con un área de 3.5 millones de metros cuadrados. pies en Las Vegas, un campus de 1.8 millones de metros cuadrados ft en Grand Rapids y 1 millón de sq. pies en Atlanta. El campus de Citadel es el centro de datos de colocación más grande del mundo, según el sitio web de la compañía.

Big Tech también está construyendo activamente mega centros de datos en los EE. UU., Con Facebook, Microsoft y Apple todos los edificios para satisfacer sus crecientes necesidades de almacenamiento.

Por ejemplo, Facebook está construyendo un centro de datos con un área de 2.5 millones de metros cuadrados. ft. en Fort Worth, Texas, para procesar y almacenar datos personales de sus usuarios. Se asumió que el centro de datos ocupará solo 750 mil metros cuadrados. Pies, pero la compañía de redes sociales ha decidido triplicar su tamaño.

Fuente: Facebook

El nuevo centro de datos costará alrededor de $ 1 mil millones y se ubicará en un terreno de 150 acres, lo que permitirá expandirse en el futuro. En mayo de 2017, 440 mil sq. Pies

Una de las inversiones más recientes de Microsoft es un centro de datos en West Des Moines, Iowa, que le costó a la compañía $ 3.5 mil millones. Juntos, este grupo de centros de datos cubre 3.2 millones de pies cuadrados de espacio, con el centro de datos más grande cubriendo 1.7 millones de pies cuadrados. Este centro de datos dedicado, llamado Proyecto Osmium, está ubicado en 200 acres de tierra y se espera que esté terminado para 2022.

En los últimos años, Iowa se ha convertido en un destino popular para los centros de datos debido a sus bajos precios de energía (algunos de los más bajos del país) y su bajo riesgo de desastres.

Apple también está construyendo una pequeña instalación en Iowa: un área de 400 mil pies cuadrados y su costo será de $ 1.3 mil millones.

Fuente: Apple Newsroom

Mientras que algunas instalaciones de Apple se construyeron desde cero para administrar todo el contenido: almacenamiento de aplicaciones, transmisión de música Con servicio, almacenamiento de iCloud, datos de usuario, Apple ha rediseñado una planta de paneles solares de 1.3 m² en Mesa, Arizona, que abrió en agosto de 2018. El nuevo centro de datos funciona con energía 100% verde gracias a una granja solar cercana.

Fuera de los Estados Unidos, las regiones específicas que atrajeron a estos mega centros de datos incluyen el norte de Europa, que era un destino popular para la construcción de gigantes de la tecnología debido a su temperatura fresca y exenciones fiscales.

Hohhot, China, ubicada en Mongolia Interior, también está convenientemente ubicada para mega centros de datos, ya que tiene acceso a energía local barata, temperaturas frescas y talento universitario (con la Universidad de Mongolia Interior).

Si bien los grandes centros de datos se han convertido en un tema popular en toda China, la región de Mongolia Interior se ha convertido en un centro para tales desarrollos. China Telecom (SF 10,7 millones), China Mobile (SF 7,8 millones) y China Unicom (SF 6,4 millones) han establecido megacentros de datos en la región.

Fuente: Los mejores centros de datos del mundo

Innovación del centro de datos

Además de los centros de datos, las nuevas estructuras de centros de datos diseñadas teniendo en cuenta los beneficios ambientales son otra tendencia emergente.

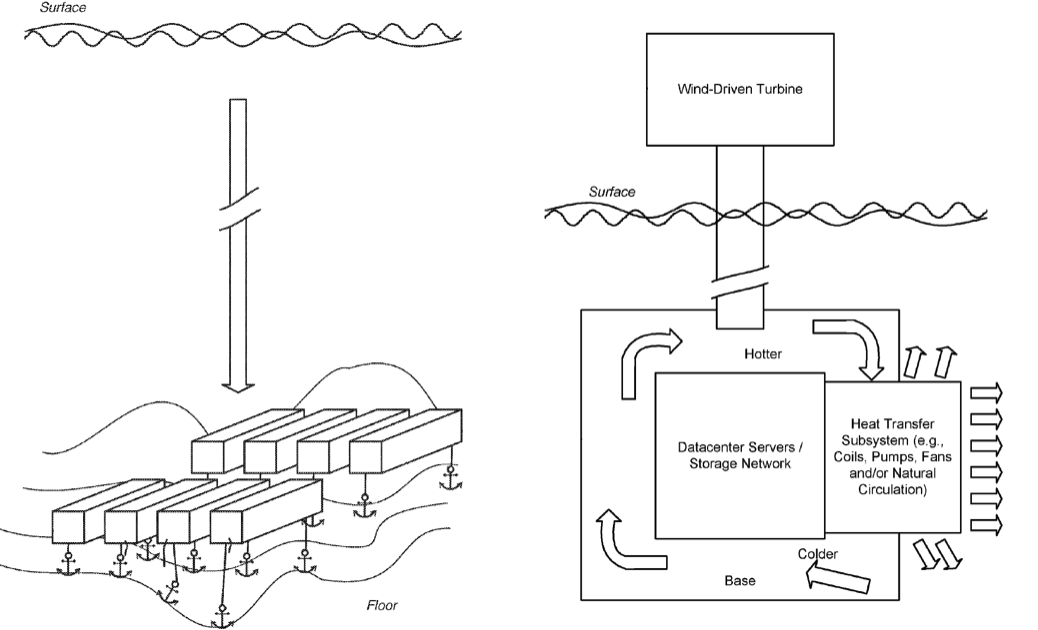

Hoy, muchas organizaciones están experimentando con centros de datos que operan dentro y alrededor del océano. Estas estructuras utilizan su entorno y recursos para enfriar naturalmente los servidores a un costo muy bajo.

Uno de los ejemplos más innovadores del uso del océano de enfriamiento gratuito es el Proyecto Natick de Microsoft. Como se señaló en una solicitud de patente presentada en 2014 y titulada "Centro de datos sumergible", Microsoft sumergió un pequeño centro de datos cilíndrico en la costa de Escocia bajo el agua.

El centro de datos utiliza el 100% de la electricidad renovable producida localmente de fuentes eólicas y solares costeras, así como de mareas y olas. La instalación utiliza el océano para eliminar el calor de la infraestructura.

Fuente: Microsoft

Desde sus primeras etapas, Microsoft ha avanzado mucho en este proyecto, que podría proporcionar luz verde para la expansión del centro de datos oceánicos en el futuro.

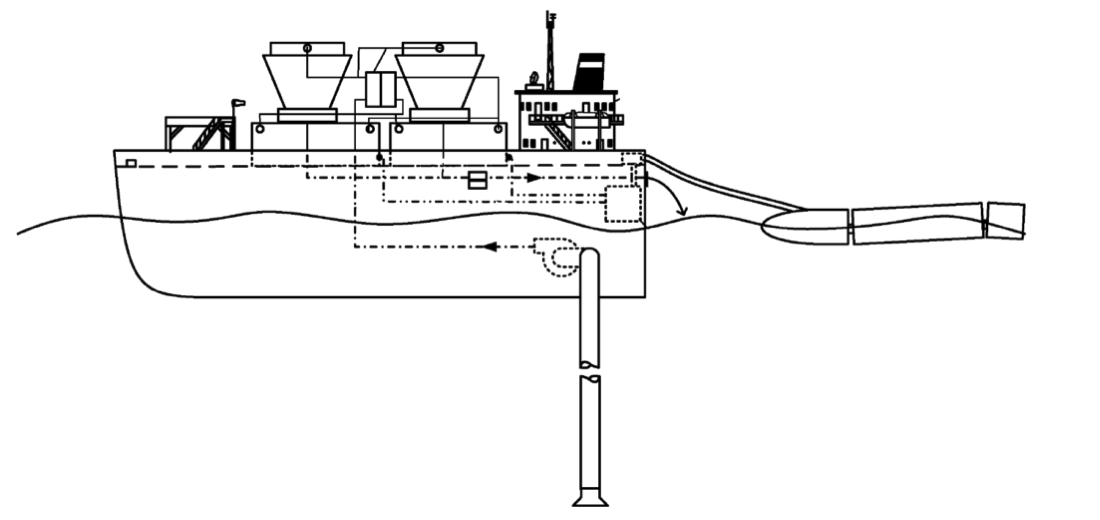

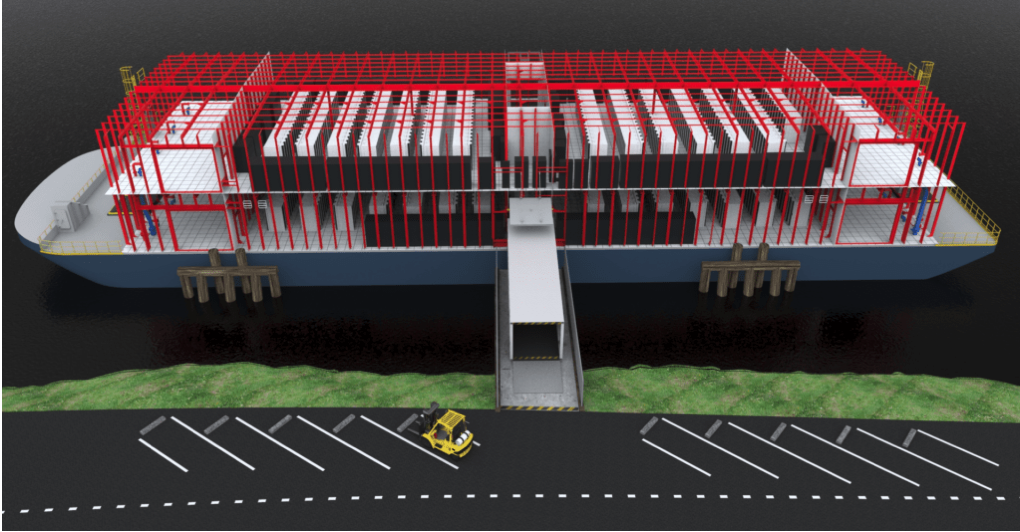

Google también ha experimentado con centros de datos oceánicos. En 2009, la compañía presentó una solicitud de patente para un centro de datos a base de agua, que prevé la creación de centros de datos a bordo de barcazas flotantes.

Similar al diseño de Microsoft, la estructura utilizará el agua circundante para enfriar naturalmente la instalación. Además, la barcaza también puede generar energía a partir de las corrientes oceánicas.

Aunque Google no reveló si se probaron estas estructuras, se cree que la compañía fue responsable de una barcaza flotante en la Bahía de San Francisco en 2013.

El lanzamiento de Nautilus Data Technologies se llevó a cabo con una idea muy similar. En los últimos años, la compañía ha recaudado $ 58 millones para dar vida al concepto de este centro de datos flotante.

Fuente: Jefe de Negocios

La compañía se centra menos en el barco y más en la tecnología necesaria para alimentar y enfriar los centros de datos. Los objetivos principales de Nautilus son: reducir el costo de la informática, reducir el consumo de energía, eliminar el consumo de agua, reducir la contaminación del aire y las emisiones de gases de efecto invernadero.

Eficiencia Energética y Eficiencia de Costos

Los centros de datos representan actualmente el 3% de todo el consumo de electricidad en el mundo, y este porcentaje solo crecerá. Esta electricidad no siempre es "limpia": según las Naciones Unidas (ONU), el sector de la tecnología de la información y la comunicación (TIC), que es alimentado en gran medida por los centros de datos, proporciona la misma cantidad de gases de efecto invernadero que el sector de la aviación con combustible.

Aunque las TIC han sido capaces de frenar el aumento del consumo de electricidad en parte debido al cierre de centros de datos antiguos e ineficientes, esta estrategia solo puede conducir a un aumento en el consumo de Internet y la producción de datos.

En el futuro, hay dos opciones para que los centros de datos reduzcan las emisiones: mejorar la eficiencia energética dentro del centro de datos y garantizar el uso de energía limpia.

Consumo reducido y eficiencia energética mejorada

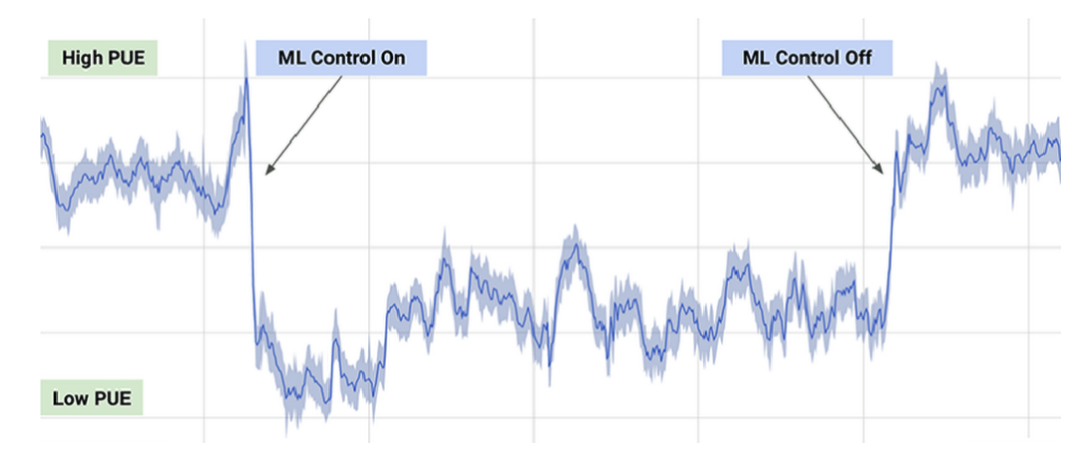

En 2016, DeepMind y Google trabajaron en un sistema de recomendación de IA para ayudar a que los centros de datos de Google sean más eficientes energéticamente. La atención se centró en las mejoras más pequeñas: incluso pequeños cambios fueron suficientes para ayudar a ahorrar energía significativa y reducir las emisiones. Sin embargo, después de que las recomendaciones se pusieron en vigencia, su implementación requirió demasiado esfuerzo por parte del operador.

Los operadores de centros de datos han preguntado si pueden implementarse de manera autónoma. Sin embargo, según Google, ningún sistema de inteligencia artificial está listo para controlar completamente los procesos de enfriamiento y calefacción en el centro de datos.

El sistema de gestión de IA actual de Google está trabajando en acciones específicas, pero solo puede realizarlas en condiciones limitadas, priorizando la seguridad y la confiabilidad. Según la compañía, el nuevo sistema proporciona un promedio de hasta un 30% de ahorro de energía.

Día típico de PUE (eficiencia energética) con ML activado y desactivado.

Fuente: DeepMind

Google también utilizó un sistema de inteligencia artificial para ajustar el rendimiento en un centro de datos del medio oeste mientras observaba un tornado. Si bien el operador humano podría concentrarse en prepararse para la tormenta, el sistema de inteligencia artificial aprovechó y conoció las condiciones de los tornados, como las caídas de presión del aire y los cambios de temperatura y humedad, para ajustar los sistemas de enfriamiento del centro de datos para obtener la máxima eficiencia durante un tornado. En invierno, el sistema de control de IA se adapta al clima para reducir el consumo de energía necesario para enfriar el centro de datos.

Sin embargo, este método no está exento de inconvenientes. Las brechas en la tecnología de inteligencia artificial dificultan la creación de un entorno para que el centro tome decisiones efectivas, y la inteligencia artificial es muy difícil de escalar. Cada centro de datos de Google es único y es difícil implementar una herramienta de inteligencia artificial (IA) para todos a la vez.

Otra forma de aumentar la eficiencia es cambiar el método de enfriamiento de las partes sobrecalentadas del centro de datos, como servidores o ciertos tipos de chips.

Uno de estos métodos es usar líquido en lugar de aire para enfriar las partes. El CEO de Google, Sundar Pichai, dijo que los chips lanzados recientemente por la compañía son tan poderosos que la compañía tuvo que sumergirlos en líquido para enfriarlos al grado correcto.

Algunos centros de datos están experimentando con centros de datos sumergidos bajo el agua para simplificar el enfriamiento y mejorar la eficiencia energética. Esto permite que los centros de datos tengan acceso constante al agua fresca y natural de las profundidades del mar, por lo que el calor del equipo va al océano circundante. Debido a que el centro de datos se puede ubicar frente a cualquier costa, hay una variedad de conexiones de energía verde, como el Microsoft Project Natick de 40 pies alimentado por la red eólica de las Islas Orcadas.

La ventaja que tienen los centros de datos submarinos más pequeños es que pueden ser modulares. Esto simplifica su despliegue en comparación con los nuevos centros en tierra.

Sin embargo, a pesar de estas ventajas, algunos expertos desconfían de los centros de datos bajo el agua, ya que es posible que se produzcan inundaciones. Dado que el proceso de enfriamiento implica la extracción de agua limpia y la liberación de agua caliente en la región circundante, estos centros de datos pueden calentar el mar al afectar la flora y fauna marina local. Y si bien los centros de datos submarinos, como el Proyecto Natick, están diseñados para funcionar sin control humano, si surge algún problema, pueden ser difíciles de solucionar.

En el futuro, los centros de datos también pueden contribuir a la energía limpia y la eficiencia utilizando parte de la electricidad que producen. Varios proyectos ya están explorando la posibilidad de reutilizar el calor. El centro de datos nórdico DigiPlex se ha asociado con el proveedor de calefacción y refrigeración Stockholm Exergi para crear un sistema de recuperación de calor. El concepto de esta solución es recolectar el exceso de calor en el centro de datos y enviarlo al sistema de calefacción de distrito local para calentar potencialmente hasta 10,000 residentes de Estocolmo.

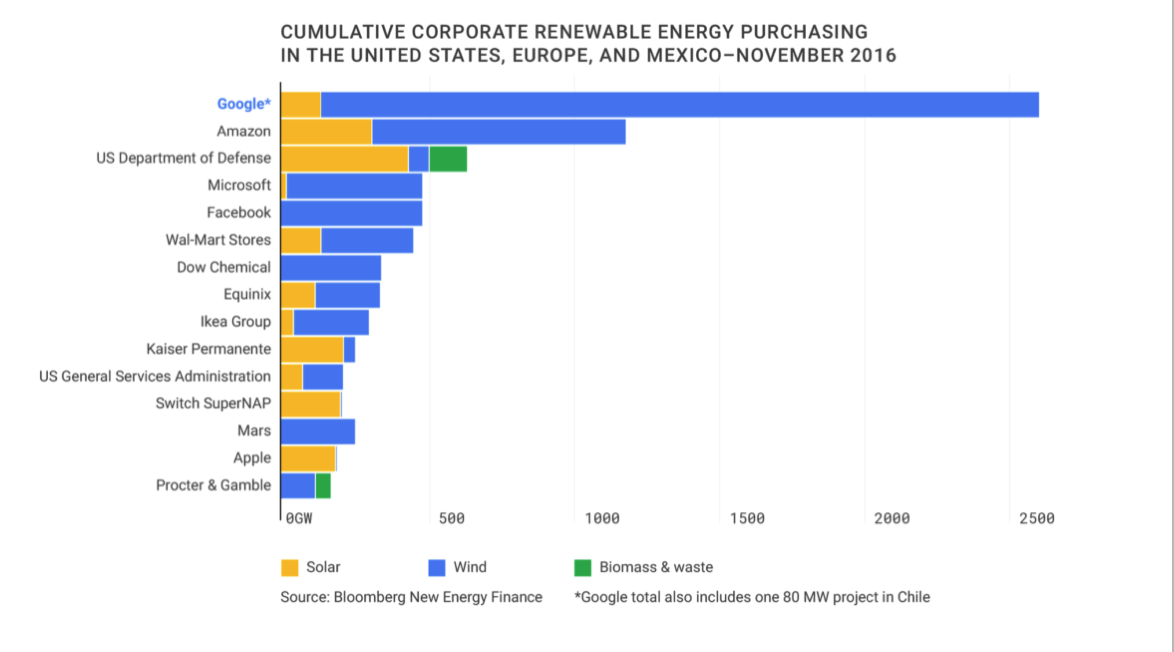

Comprar energía limpia

Según la AIE, la industria de las TIC ha progresado en el campo de la energía limpia y actualmente está cerrando casi la mitad de todos los acuerdos corporativos para la compra de electricidad de fuentes renovables.

A partir de 2016, Google es el mayor comprador de energía renovable corporativa en el planeta.

Fuente: Google Sustainability

En diciembre de 2018, Facebook adquirió 200 MW de energía de una compañía de energía solar. En Singapur, donde la superficie terrestre es limitada, Google ha anunciado planes para comprar 60 MW de energía solar en el techo.

Al mismo tiempo, las grandes empresas como Google y Facebook, que tienen los recursos para comprar grandes cantidades de energía renovable, pueden ser difíciles para las pequeñas empresas que pueden no necesitar grandes cantidades de energía.

Otra opción de energía más costosa es MicroGrid: instalar una fuente de energía independiente dentro del centro de datos.

Un ejemplo de tal estrategia son las celdas de combustible similares a las vendidas recientemente por la compañía pública Bloom Energy. Las células usan hidrógeno como combustible para generar electricidad. Aunque estas fuentes alternativas a menudo se usan como energía de respaldo, el centro de datos puede confiar completamente en este sistema para sobrevivir, aunque es una opción rentable.

Otra forma en que los centros de datos investigan la energía limpia es a través del uso de fuentes de energía renovables (REC), que representan una cierta cantidad de energía limpia y generalmente se utilizan para equilibrar la "energía sucia" que utiliza la empresa. Para cualquier cantidad de energía sucia producida, REC representa la producción de una cantidad equivalente de energía limpia en el mundo. Estas cantidades recuperadas se vuelven a vender al mercado de energías renovables.

Sin embargo, hay ciertos problemas con el modelo REC. Por un lado, REC solo compensa la energía sucia; esto no significa que el centro de datos esté funcionando con energía limpia. Aunque el método REC suele ser más simple que encontrar fuentes disponibles que puedan proporcionar suficiente energía para satisfacer las necesidades del centro de datos. La desventaja es que el método generalmente está fuera del alcance de las pequeñas empresas que no siempre tienen el capital para apostar por las fluctuaciones de un parque solar o eólico.

En el futuro, la tecnología facilitará una estrecha colaboración entre pequeños productores y compradores. Están surgiendo modelos de mercado y carteras de fuentes de energía renovables (similares a las creadas por fondos mutuos) que permiten evaluar y cuantificar las fluctuaciones en las fuentes de energía renovables.

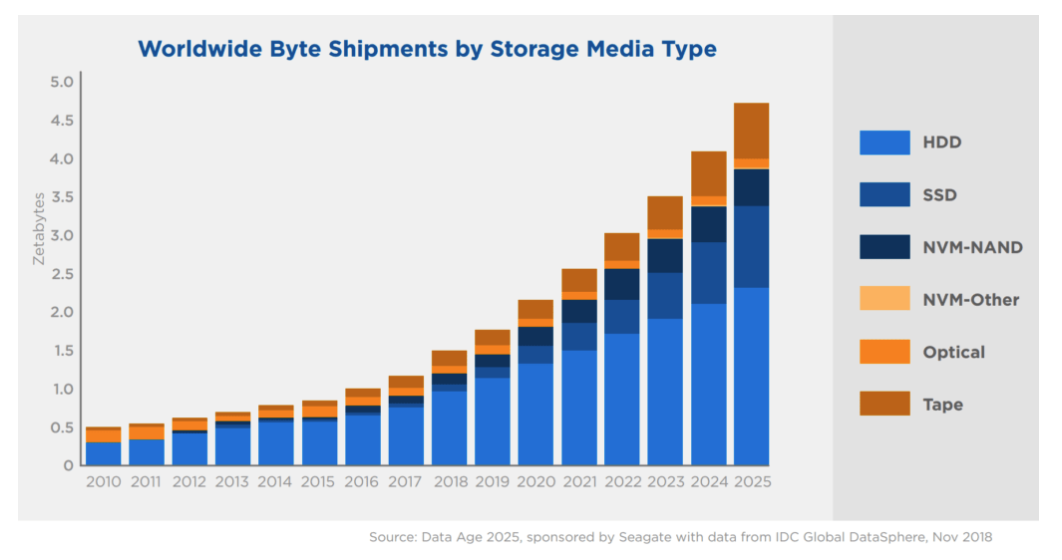

(SSD)

Las SSD, o SSD, son una forma de dispositivo de almacenamiento que admite la lectura y escritura de datos. Estos dispositivos pueden almacenar datos sin energía, esto se llama almacenamiento persistente. Esto difiere de las formas temporales de almacenamiento de datos, como la memoria de acceso aleatorio (RAM), que almacena información solo durante el funcionamiento del dispositivo.

Los SSD compiten con los HDD, otra forma de almacenamiento masivo. La principal diferencia entre SSD y HDD es que los SSD funcionan sin partes móviles. Esto permite que los SSD sean más duraderos y livianos.

Sin embargo, los SSD siguen siendo más caros que los HDD tradicionales, una tendencia que probablemente continuará sin un avance en la producción de unidades de estado sólido.

Fuente: Silicon Power Blog

Y aunque las unidades de estado sólido se han convertido en el estándar para computadoras portátiles, teléfonos inteligentes y otros dispositivos con un perfil delgado, son menos prácticas y, por lo tanto, menos comunes en los grandes centros de datos debido a su mayor precio.

Fuente: Seagate e IDC

Según IDC, para fines de 2025, más del 80% del almacenamiento corporativo permanecerá en forma de discos duros. Pero después de 2025, los SSD pueden convertirse en el medio de almacenamiento de elección para las empresas y sus centros de datos.

Con la adopción generalizada de unidades de estado sólido en dispositivos electrónicos de consumo y dispositivos IoT, una mayor demanda puede conducir a un mayor suministro y, en última instancia, a menores costos.

Almacenamiento en frio

A diferencia de los nuevos SSD, muchas tecnologías antiguas, como los CD-R y las cintas magnéticas, utilizan almacenamiento en frío para mantener los datos lo más bajos posible.

En el almacenamiento en frío, el acceso a los datos lleva mucho más tiempo que en el almacenamiento en caliente (por ejemplo, SSD). En tales sistemas, solo se deben almacenar datos usados con poca frecuencia.

Las nubes "calientes" funcionan en unidades SSD y unidades híbridas, proporcionan el acceso más rápido a la información. El almacenamiento en frío es una solución más económica y más lenta. Cold Clouds almacena información que no es necesaria para la visualización instantánea. Después de la solicitud, los datos se pueden descargar de varios minutos a decenas de horas.

Hablando literalmente, la diferencia de temperatura dentro de los centros de datos es cuanto más rápida es la nube, más calor genera el equipo.

Sin embargo, las empresas tecnológicas más grandes del mundo, como Facebook, Google y Amazon, utilizan el almacenamiento en frío para almacenar incluso los datos de usuario más granulares. Los proveedores de la nube como Amazon, Microsoft y Google también ofrecen estos servicios a los clientes que desean almacenar datos a precios bajos.

Según CB Insights Market Calibration Tool, se espera que el mercado de almacenamiento en frío alcance casi $ 213 mil millones para 2025.

habrastorage.org/webt/cr/cc/t-/crcct-u3vtckequtnd0eazlwkqk.png

Fuente: IBM

Ningún negocio quiere salirse de la curva en la recopilación de datos. La mayoría de las organizaciones argumentan que es mejor recopilar la mayor cantidad de datos posible hoy, incluso si aún no han decidido cómo se utilizarán mañana.

Este tipo de datos no utilizados se llama datos oscuros. Estos son datos que se recopilan, procesan y almacenan, pero generalmente no se utilizan para fines específicos. IBM estima que aproximadamente el 90% de los datos del sensor recopilados de Internet nunca se utilizan.

En el futuro, tal vez, haya formas más efectivas de reducir la cantidad total de datos oscuros recopilados y almacenados. Pero ahora, incluso con el avance de la inteligencia artificial y el aprendizaje automático, las empresas todavía están interesadas en recopilar y almacenar la mayor cantidad de datos posible para poder utilizarlos en el futuro.

Por lo tanto, en el futuro previsible, el mejor almacenamiento en frío permite almacenar datos al menor costo. Esta tendencia continuará a medida que los usuarios generen más datos y las organizaciones los recopilen.

Otras formas de almacenamiento de datos.

Además de las unidades de estado sólido, discos duros, CD y cintas magnéticas, están surgiendo una serie de nuevas tecnologías de almacenamiento que prometen más capacidad por unidad de almacenamiento.

Una de las tecnologías prometedoras es la grabación termomagnética (también grabación magnética térmica) o HAMR. HAMR aumenta drásticamente la cantidad de datos que se pueden almacenar en dispositivos como discos duros al calentar la superficie del disco con un láser de alta precisión durante la grabación. Esto proporciona una grabación de datos más precisa y estable, lo que aumenta la capacidad de almacenamiento.

Se espera que para 2020 esta tecnología permita producir hasta 20 TB de discos duros en una unidad de 3,5 pulgadas y, en el futuro, aumentar anualmente la capacidad en un 30% - 40%. Seagate ya ha creado una unidad de 3,5 TB y 16 TB, que se anunció en diciembre de 2018.

Seagate ha patentado activamente esta tecnología HAMR en la última década. En 2017, la compañía solicitó un número récord de patentes relacionadas con esta tecnología.

(Nota: hay un retraso de 12-18 meses entre la presentación de patentes y su publicación, por lo que 2018 puede ver aún más patentes HAMR).

Un poco de publicidad :)

Gracias por estar con nosotros. ¿Te gustan nuestros artículos? ¿Quieres ver más materiales interesantes? Apóyenos haciendo un pedido o recomendando a sus amigos, VPS en la nube para desarrolladores desde $ 4.99, un análogo único de servidores de nivel básico que inventamos para usted: toda la verdad sobre VPS (KVM) E5-2697 v3 (6 núcleos) 10GB DDR4 480GB SSD 1Gbps desde $ 19 o cómo dividir el servidor? (las opciones están disponibles con RAID1 y RAID10, hasta 24 núcleos y hasta 40GB DDR4).

Dell R730xd 2 veces más barato en el centro de datos Equinix Tier IV en Amsterdam? ¡Solo tenemos 2 x Intel TetraDeca-Core Xeon 2x E5-2697v3 2.6GHz 14C 64GB DDR4 4x960GB SSD 1Gbps 100 TV desde $ 199 en los Países Bajos! Dell R420 - 2x E5-2430 2.2Ghz 6C 128GB DDR3 2x960GB SSD 1Gbps 100TB - ¡Desde $ 99! Leer acerca de . c Dell R730xd 5-2650 v4 9000 ?