Autor: Eugenio Culurciello, título original: La caída de RNN / LSTM

Traducción: Davydov A.N.

Nos encantaron las RNN (redes neuronales recurrentes), las LSTM (memoria a corto y largo plazo) y todas sus variantes. ¡Y ahora es el momento de dejarlos!

En 2014, LSTM y RNN resucitaron. Pero éramos jóvenes e inexpertos. Durante varios años han sido una forma de resolver problemas como el aprendizaje secuencial, la traducción de secuencias (seq2seq). También hicieron posible lograr resultados asombrosos en la comprensión del habla y su traducción a texto. Estas redes han impulsado el aumento de asistentes de voz como Siri, Cortana, Google y Alexa. No olvidemos la traducción automática, que nos permitió traducir documentos a diferentes idiomas. O traducción automática de redes neuronales, que le permite traducir imágenes a texto, texto a imágenes, hacer subtítulos para videos, etc.

Luego, en los años siguientes (2015-16), aparecieron ResNet y Attention. Entonces comenzó a llegar el entendimiento de que LSTM era una técnica inteligente para evitar, no resolver un problema. La atención también mostró que las redes MLP (redes neuronales de perceptrón multicapa) pueden reemplazarse por redes promediadas impulsadas por un vector de contexto. (más sobre esto más adelante).

Solo han pasado 2 años, y hoy podemos decir con certeza:

"¡Golpea con RNN y LSTM, no son tan buenos!"

, , Attention , , . RNN Attention . RNN , , Attention.

?

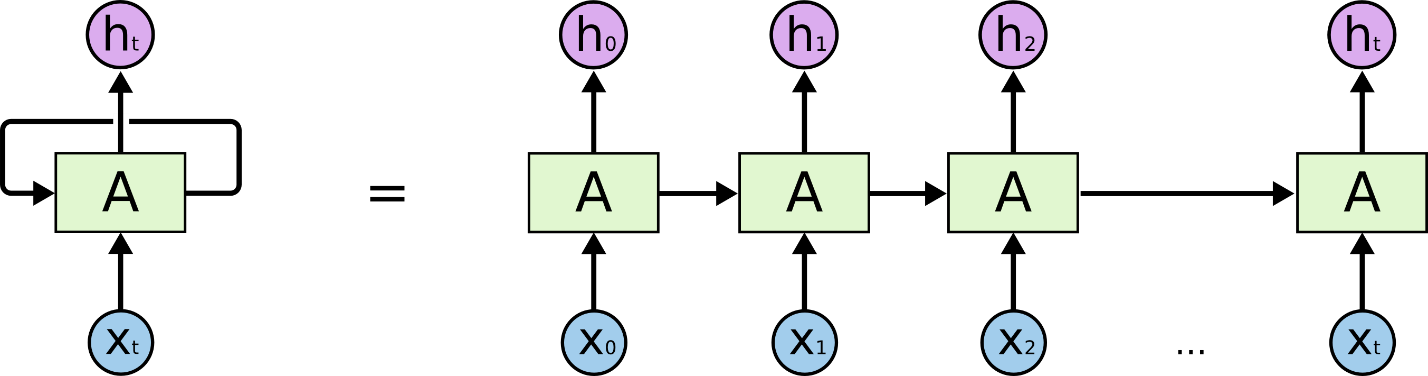

, RNN, LSTM . :

, , . , , 0, .

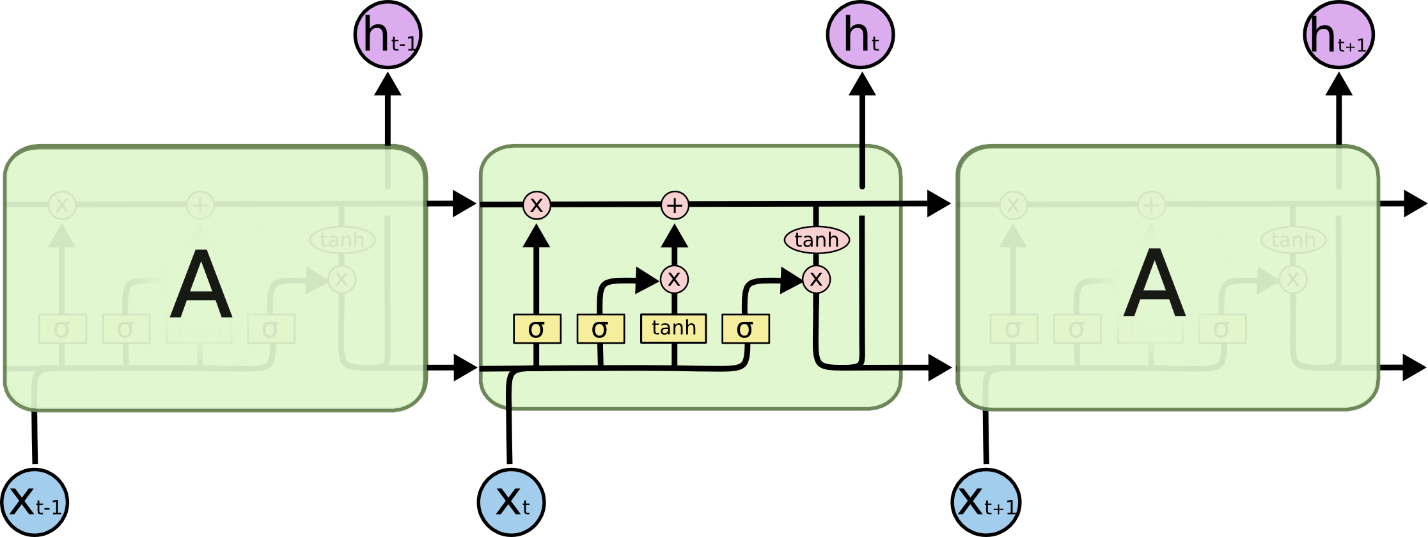

LSTM. , , ResNet. () . LSTM . .

. , , . , LSTM, GRU ! (100), .

RNN , . , ( ), . RNN . , , , Amazon Echo!

?

2D , RNN/LSTM, Attention, Transformer

Transformer 2017 , . , .

: , , « » , « », - ( ) , , . , / .

« », , :

- , Ct

, , . (TCN), 3 .

«» , 100 , 100 «» 100 . 100100 . 10 000 .

, .

, , , : , N (log(N)), N – . , RNN, – . T N (T>>N)

, 3-4 100!

, , «». , , .

? , . , , : , – , . , , . , . , , , .

– RNN . Attention. , - , !

RNN\LSTM: RNN LSTM , , . , LSTM 4 ( MLP) . , , . , ( , . .). RNN / LSTM , . , , FWDNXT.

1: WaveNet. . : .

2: RNN LSTM - ( . ). () , / , ! , - . - , ( ).

3: , CNN RNN. (TCN) « , LSTM, , ».

4: , , . « , , 858 534 22 30, . , »- , «» (Attention), , , (TCN). , RNN, , . , (, 5 ), , , , .

5: , , , . «» . , ! !

6: Attention Transformer, . VGG NLP? , LSTM , . LSTM Transformer ( ), , , « LSTM Transformer - MRPC »