Transformación del centro de datos

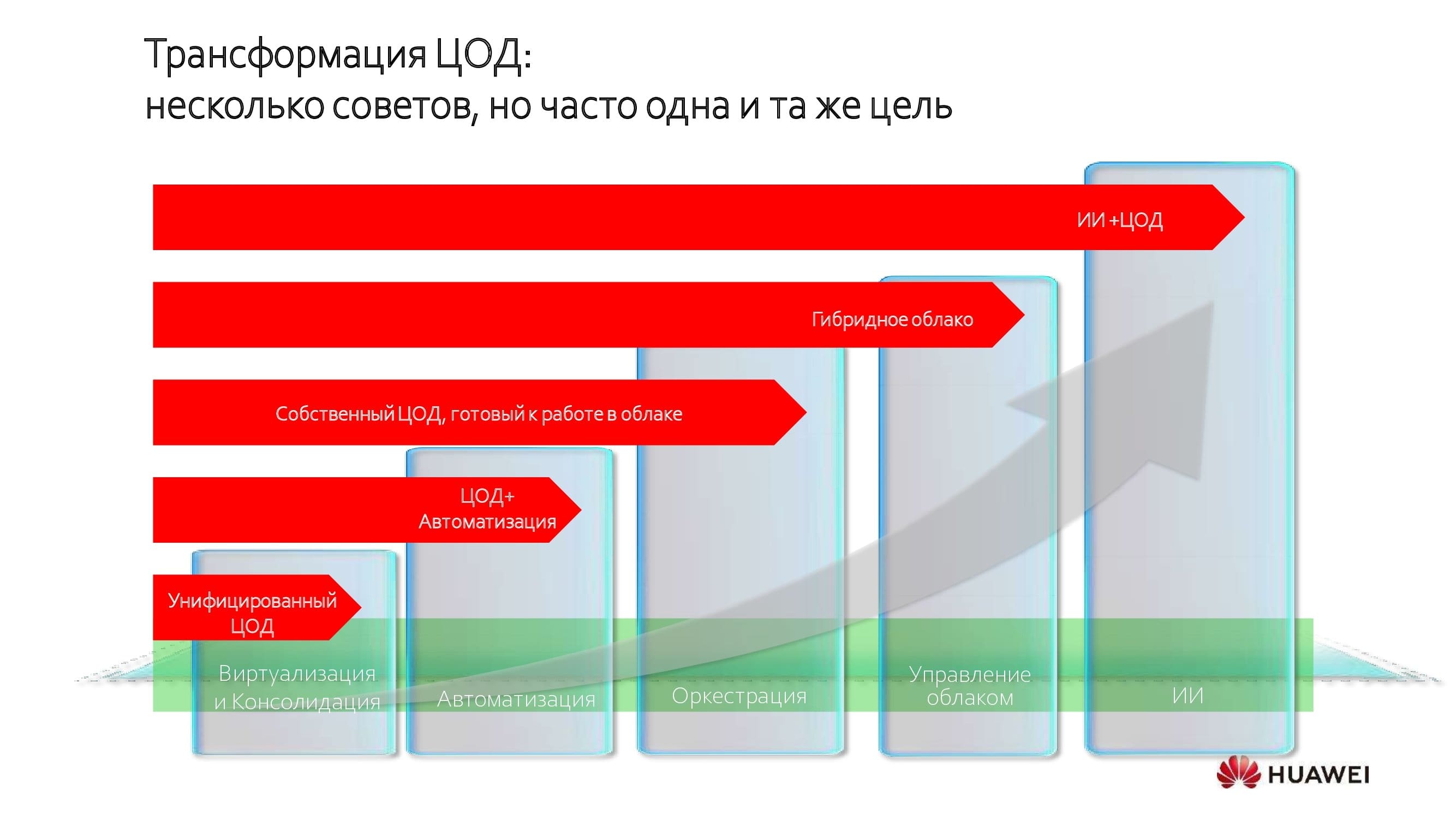

Los centros de datos están cambiando conceptualmente y cambiando drásticamente. La tendencia se generalizó relativamente hace unos diez años, pero, digamos, en el sector bancario, comenzó mucho antes. Independientemente del camino elegido, los objetivos de las transformaciones son más o menos similares: la unificación y consolidación de recursos.

Este es el primer paso, seguido de una mayor mejora de la eficiencia del centro de datos mediante la automatización, la orquestación y la transición al modo de nube híbrida. Y el límite de transformación más lejano que se puede alcanzar hoy es la introducción de sistemas de inteligencia artificial.

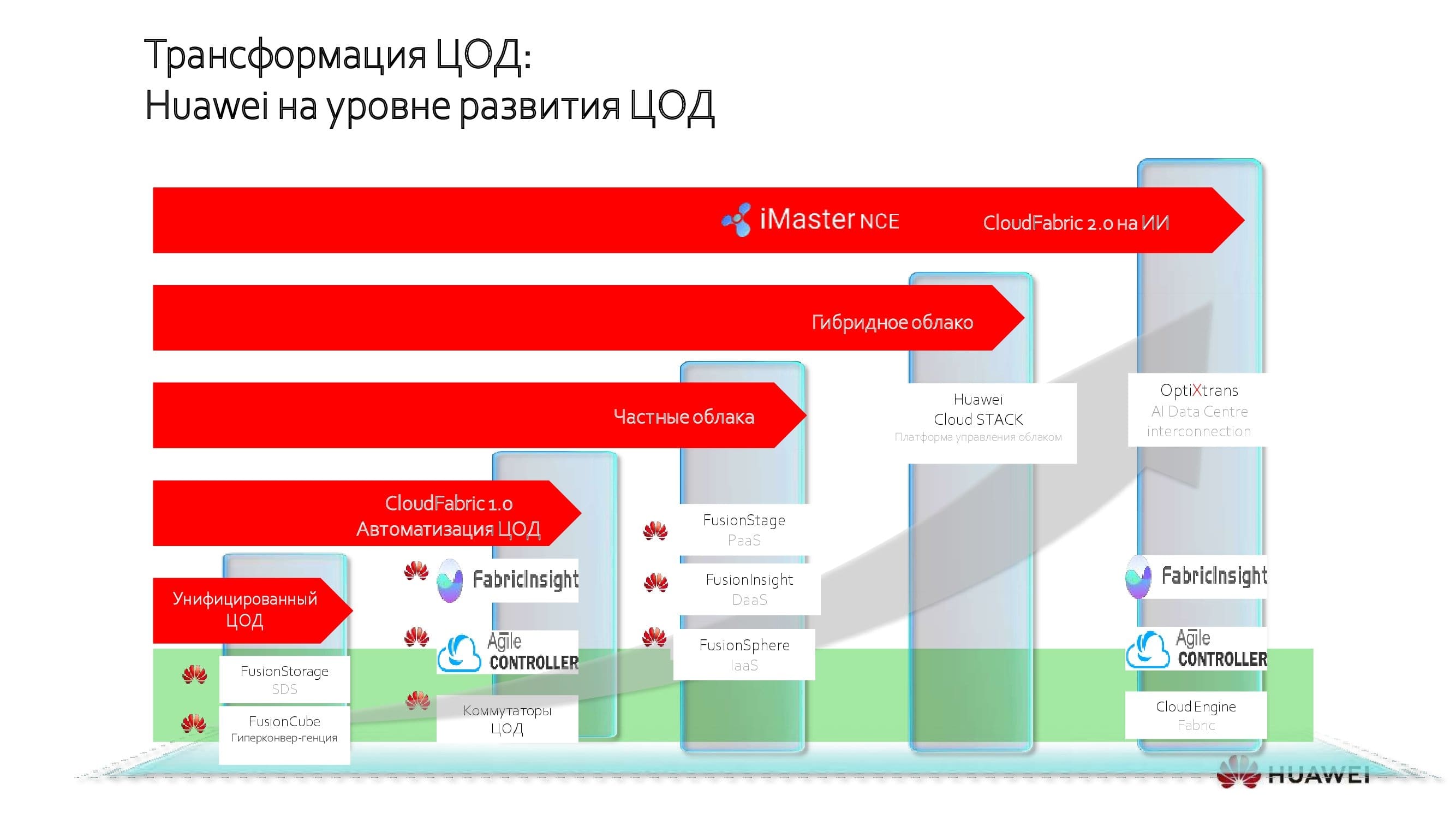

Soluciones de Huawei para cada etapa de transformación

En cada etapa, dependiendo de la "madurez de TI" del cliente, Huawei ofrece sus propias soluciones diseñadas para brindar el mejor resultado de modernización sin gastos innecesarios. Hoy me gustaría hablar con más detalle sobre la “guinda del pastel”: los sistemas de IA en los centros de datos modernos.

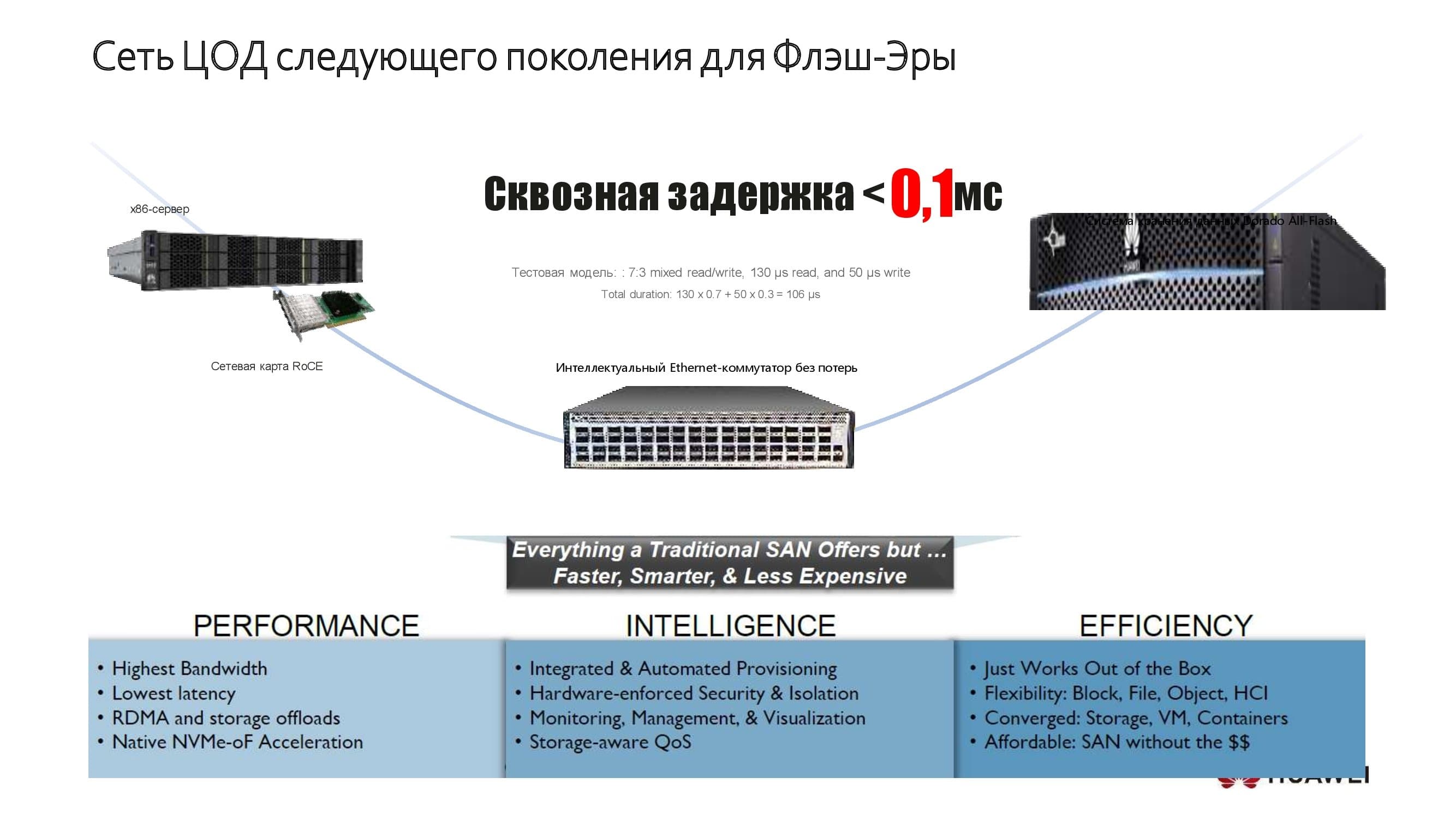

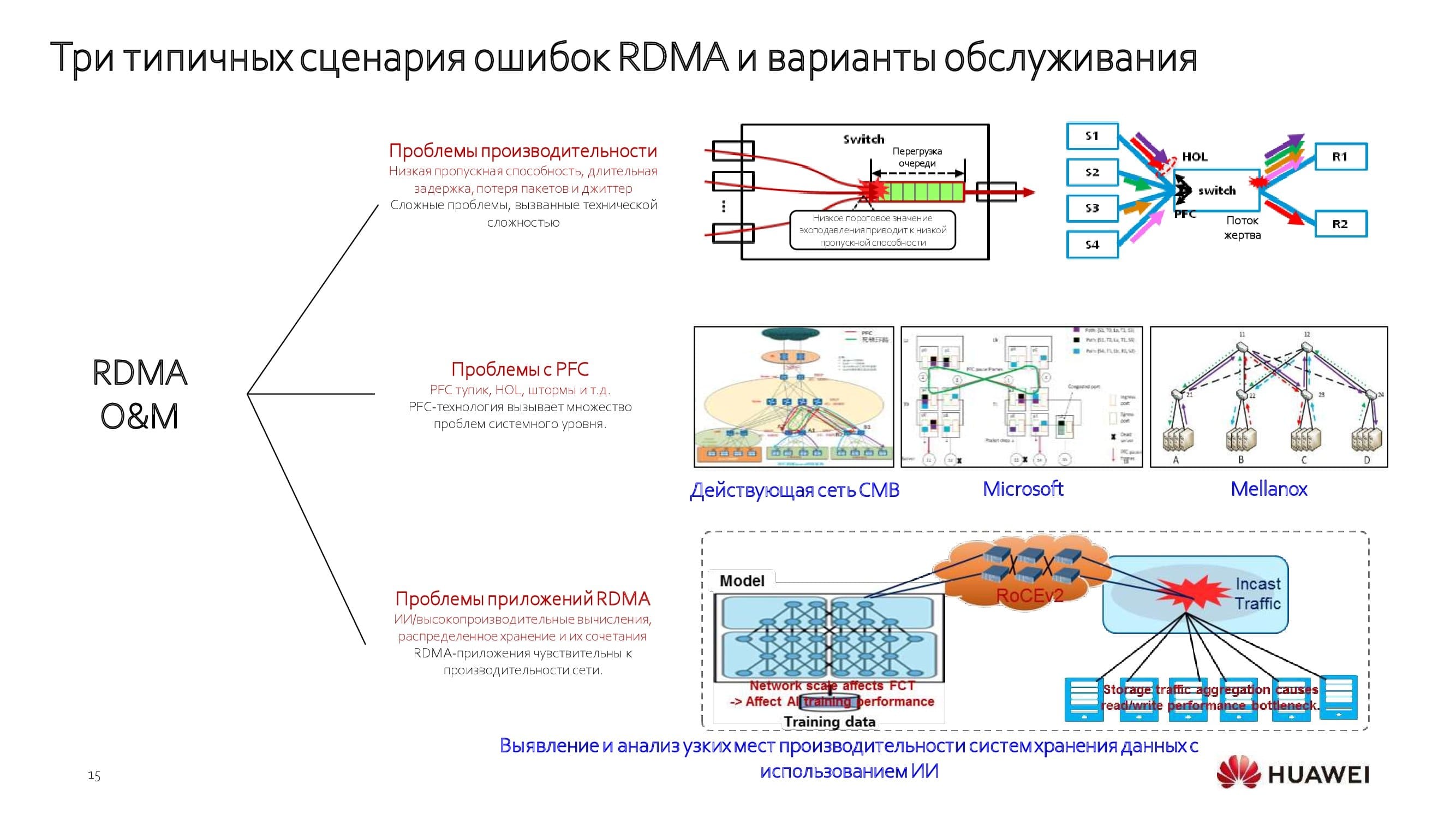

Para hacer una analogía con el cuerpo humano, los conmutadores de la red del centro de datos actúan como el sistema circulatorio, proporcionando conectividad entre varios componentes: nodos informáticos, sistemas de almacenamiento de datos, etc.

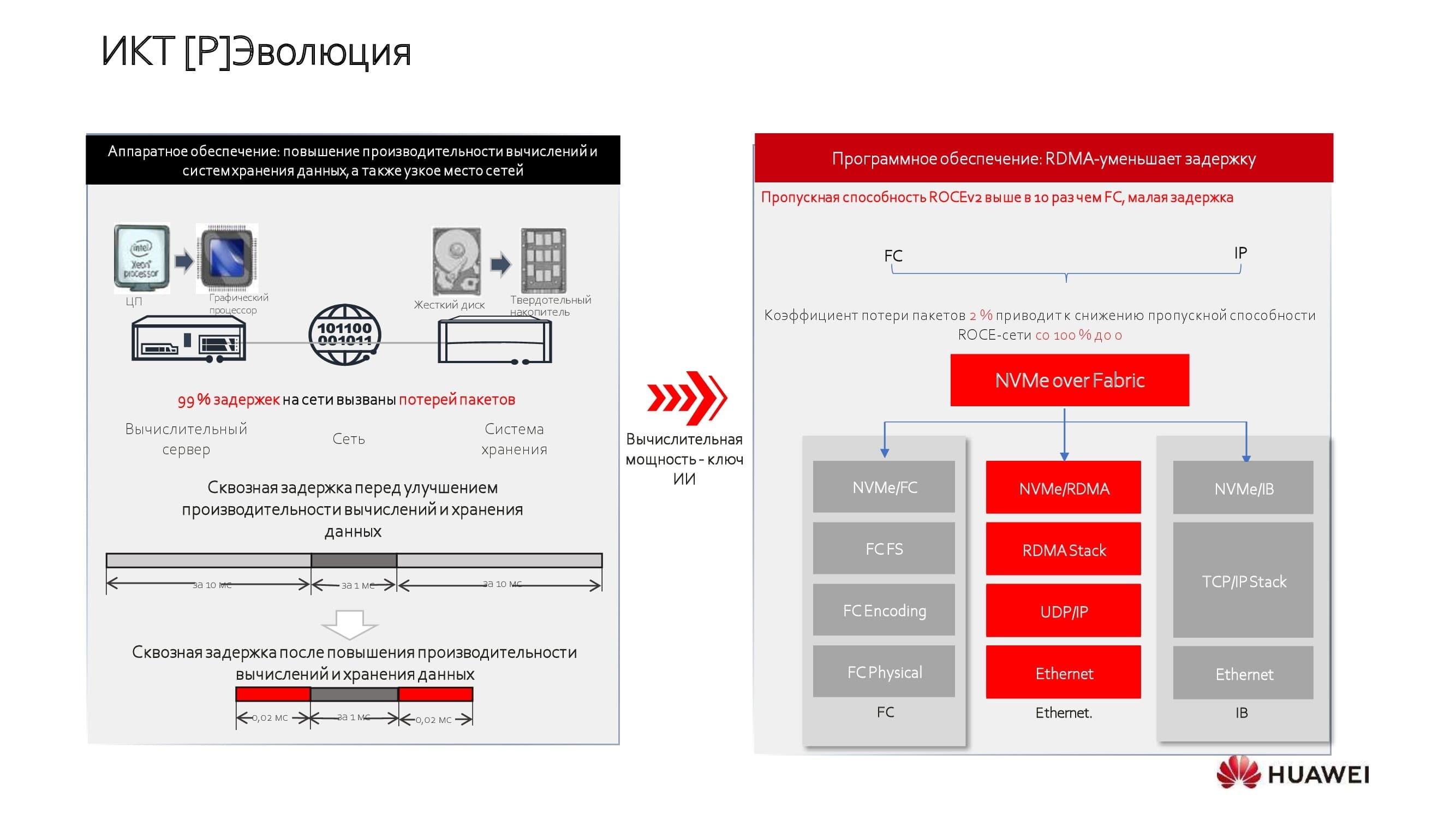

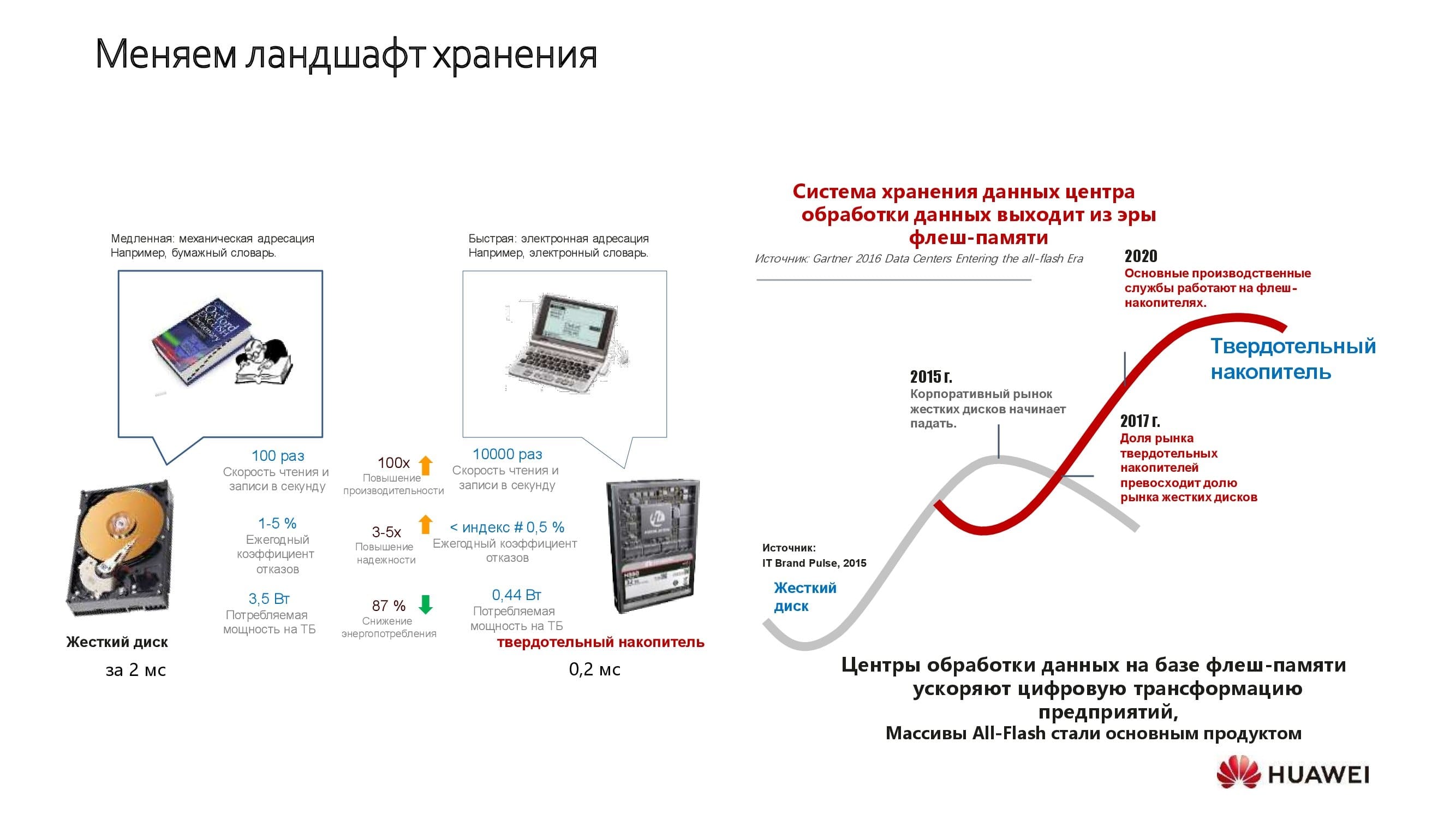

Hace solo unos años, la tecnología de almacenamiento SSD estuvo ampliamente disponible y el rendimiento de la CPU sigue creciendo. Con esto, los nodos de almacenamiento y computación ya no son las principales causas de latencia. Pero la red del centro de datos se ha mantenido durante mucho tiempo en la estructura de los centros de datos como una especie de "hermano pequeño".

Los fabricantes han intentado solucionar el problema de diferentes formas. Alguien eligió tecnologías con licencia InfiniBand (IB) para construir una red . La red resultó ser especializada y capaz de resolver solo tareas de perfil estrecho. Alguien prefirió construir fábricas de red utilizando protocolos de canal de fibra.(FC). Ambos enfoques tenían sus limitaciones: o el ancho de banda de la red resultó ser relativamente modesto o el costo total de la solución, que se agravó aún más por la dependencia de un proveedor.

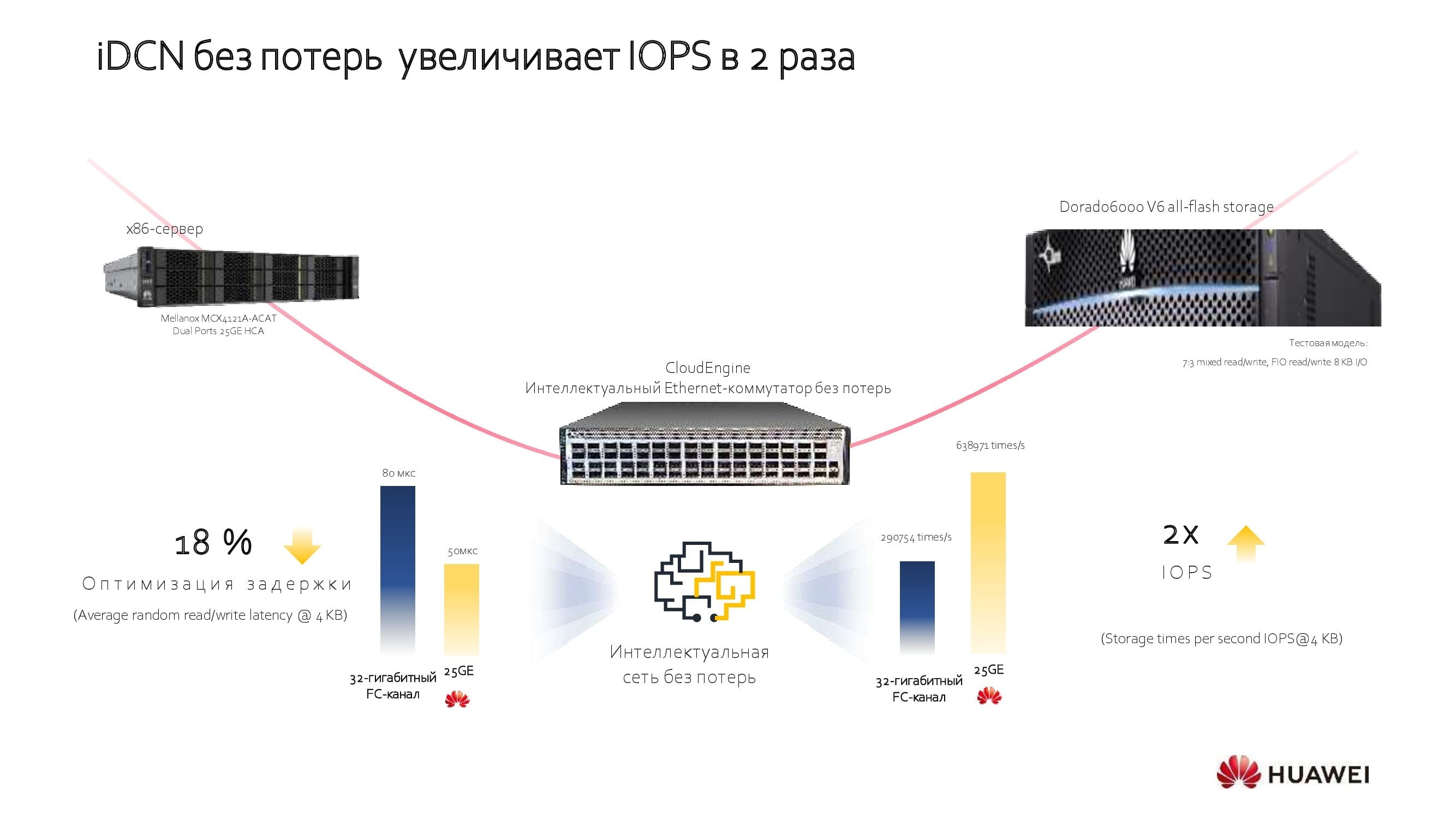

Nuestra empresa pasó por el uso de tecnologías abiertas. Las soluciones de Huawei se basan en la segunda versión de RoCE , cuyas capacidades se han ampliado mediante el uso de algoritmos con licencia adicionales en nuestros conmutadores. Esto nos permitió optimizar seriamente las capacidades de las redes.

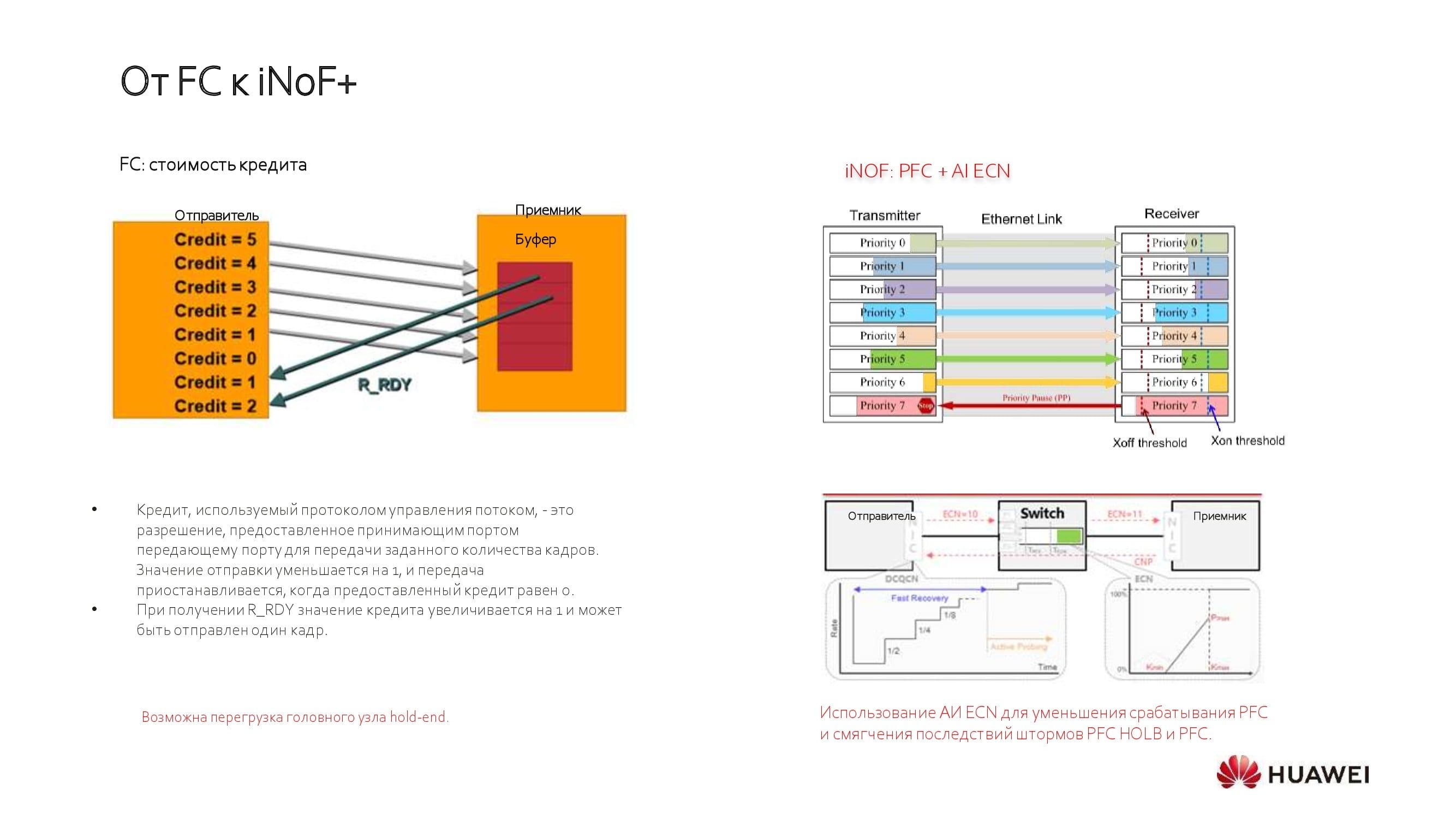

¿Por qué no vemos el futuro detrás de las soluciones FC clásicas? La cuestión es que funcionan según el principio de asignación de crédito estático, que requiere configurar el tejido de la red de acuerdo con las necesidades de sus aplicaciones durante un período de tiempo limitado.

Recientemente, FC ha dado un paso adelante hacia las redes de almacenamiento independientes, pero sigue presentando limitaciones de rendimiento. Ahora la corriente principal: la sexta generación de la tecnología, que permite lograr un rendimiento de 32 Gb / s, se están comenzando a implementar soluciones de 64 Gb / s. Al mismo tiempo, con la ayuda de Ethernet, hoy, utilizando tablas de prioridad, podemos llevar 100, 200 e incluso 400 Gbit / s al servidor.

El valor agregado de la red del centro de datos es de particular importancia en un mundo donde las unidades de estado sólido con interfaces de alta velocidad están ganando más participación en el mercado, desplazando a las unidades de husillo clásicas. Huawei se compromete a permitir que el almacenamiento SSD alcance su máximo potencial.

Red de centro de datos de próxima generación

Un pequeño ejemplo de cómo lo hacemos. En el diagrama se muestra uno de nuestros sistemas de almacenamiento, reconocido como el más rápido del mundo. Aquí se muestran nuestros servidores x86 o basados en ARM, que ofrecen un rendimiento que cumple con las expectativas de clientes extremadamente exigentes. En los centros de datos, basándonos en estas soluciones, logramos lograr una latencia de extremo a extremo de no más de 0,1 ms. El uso de nuevas tecnologías de aplicación nos ayuda a conseguir ese resultado.

Las tecnologías clásicas utilizadas en el almacenamiento estaban limitadas, en particular, por las latencias bastante altas causadas por el bus SAS. El cambio a nuevos protocolos como NVMe mejoró significativamente este parámetro y, al mismo tiempo, la propia red se convirtió en un factor limitante del rendimiento.

Considere, dentro del mismo ejemplo, el uso de redes con algoritmos con licencia adicionales. Optimizan la latencia de un extremo a otro, aumentan drásticamente el rendimiento de la red y aumentan las operaciones de E / S por unidad de tiempo. Este enfoque ayuda a evitar la "doble compra", a veces necesaria para lograr los parámetros de rendimiento requeridos, y el ahorro total (en términos de TCO) al introducir una nueva red alcanza el 18-40%, dependiendo de los modelos de equipos utilizados.

¿Cuáles son estos algoritmos asombrosos?

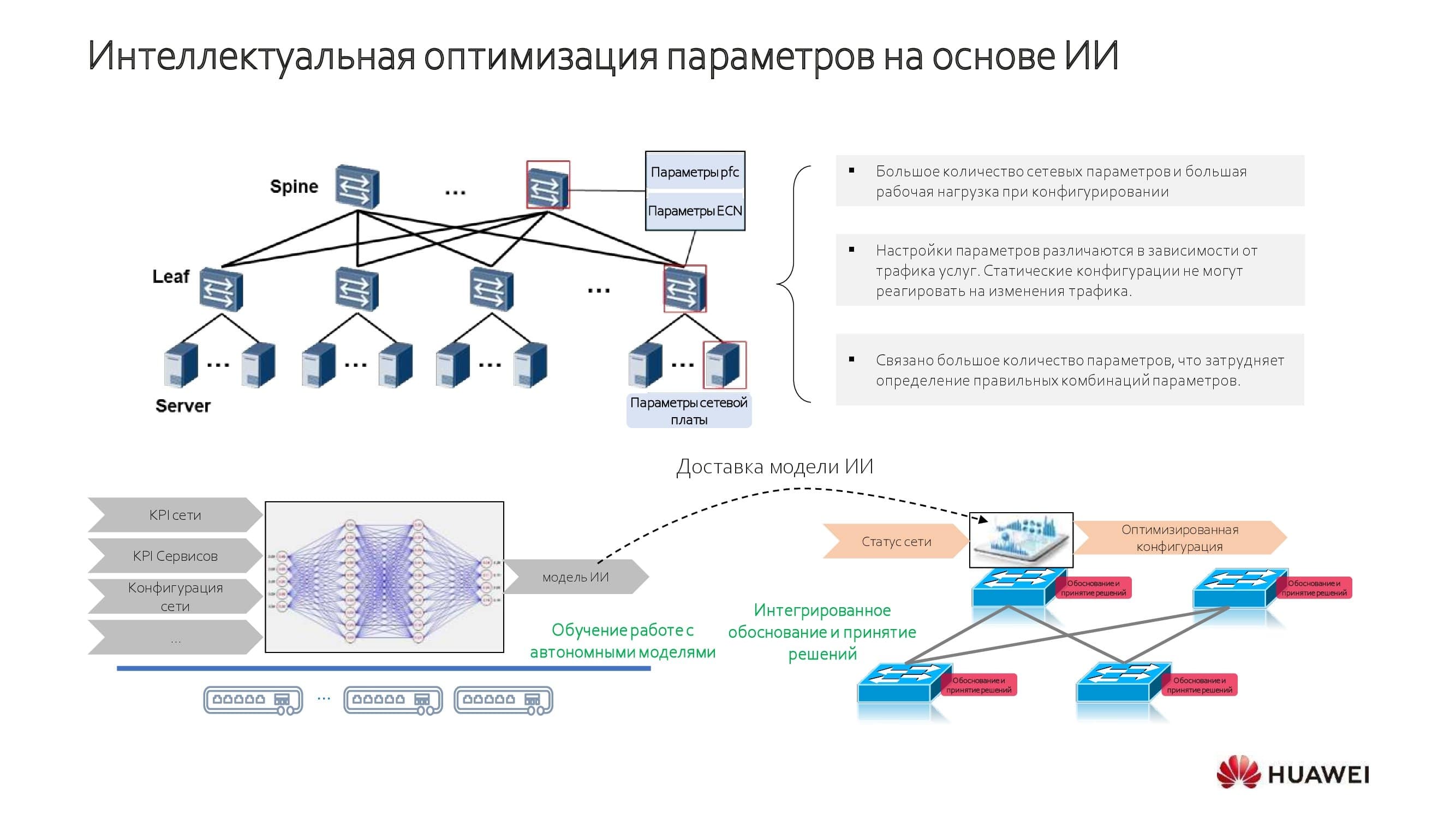

Las tecnologías convencionales trajeron consigo los problemas habituales, ya que trabajaban con umbrales estáticos de la cola. Este umbral significaba que existía una relación básica entre la velocidad y la latencia para todas las aplicaciones. El modo de control manual no permitió el ajuste dinámico de los parámetros de la red.

Usando conjuntos de chips de aprendizaje automático adicionales en los conmutadores, enseñamos a la red a operar en un modo que permite construir redes de centros de datos inteligentes sin pérdida de paquetes (lo llamamos iDCN ).

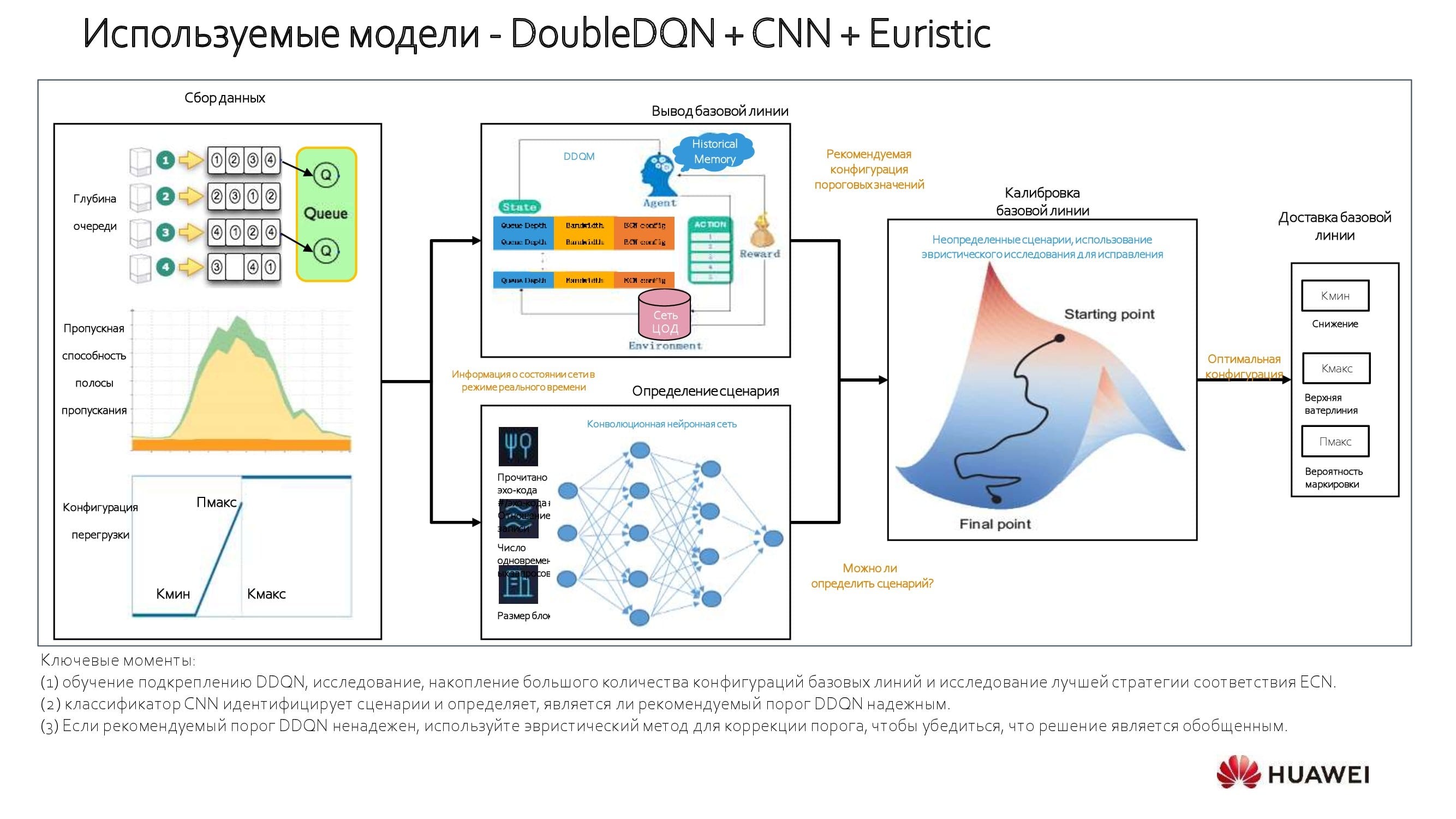

¿Cómo se logra la optimización inteligente? Aquellos que están involucrados en redes neuronales encontrarán fácilmente elementos familiares y mecanismos de entrenamiento / inferencia en el diagrama. Nuestras soluciones combinan modelos integrados con la capacidad de aprender en una red específica.

El sistema de IA acumula una cierta cantidad de conocimiento sobre la red, que luego se aproxima y se utiliza al configurar dinámicamente la red. Los dispositivos basados en nuestras propias soluciones de hardware utilizan un chip AI especial. Los modelos construidos en conjuntos de chips con licencia de fabricantes estadounidenses utilizan un módulo adicional y un bus de software.

Sobre los modelos utilizados. Usamos un enfoque que se basa en un modelo de aprendizaje por refuerzo. El sistema analiza el 100% de los datos que pasan a través del dispositivo de red y selecciona la línea de base. Si, por ejemplo, conoce el ancho de banda y los retrasos que son críticos para una aplicación en particular, no es difícil determinar la línea de base. Con una gran cantidad de aplicaciones, es posible realizar cálculos “medianos” y realizar ajustes en modo automático, aumentando significativamente el rendimiento.

El diagrama muestra el proceso con más detalle. Al comienzo de la optimización de la red, calculamos los valores de umbral, tanto mínimo como máximo. Luego viene la red neuronal convolucional(CNN). Por lo tanto, es posible igualar el ancho de banda y las tasas de latencia para cada aplicación, así como determinar su "peso" total dentro de los servicios de red. Usando este enfoque estratificado, obtenemos algunas ideas realmente interesantes.

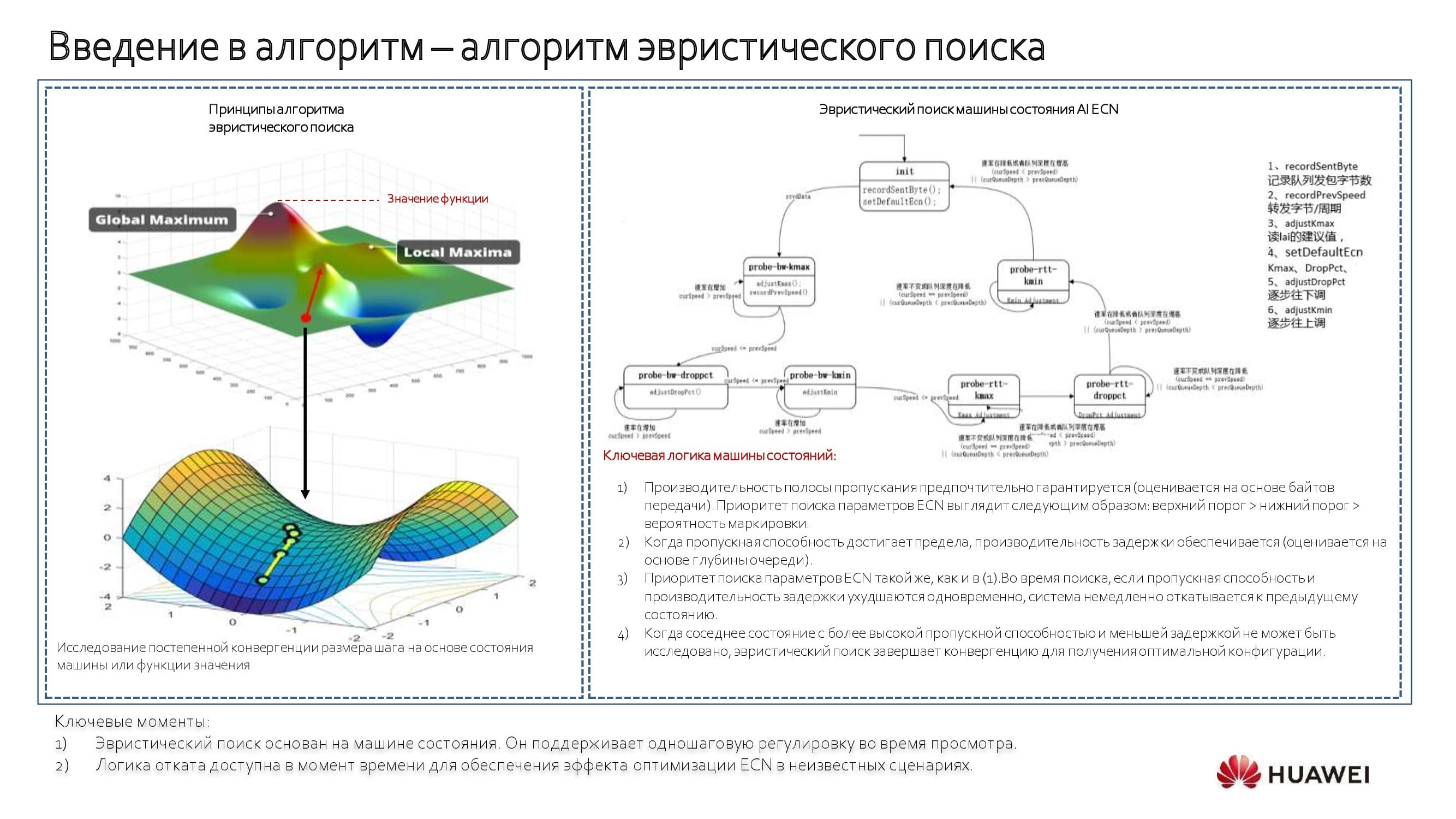

Cuando se desconoce la aplicación, se utiliza un algoritmo de búsqueda heurística junto con una " máquina de estado ". Con su ayuda, comenzamos a movernos en sentido antihorario a lo largo del diagrama de bloques que se muestra arriba, identificando valores de umbral y construyendo un modelo. Es un proceso automático que se puede manipular según sea necesario. Si esto no es necesario, es más fácil confiar en el conmutador y sus servicios.

De la teoría a la práctica

Al aplicar dichos algoritmos y trabajar a nivel de toda la red, y no de sus porciones individuales, resolvemos todos los principales problemas de rendimiento. Ya existen casos interesantes de implementación y uso de tales tecnologías en el sector bancario. Estos mecanismos también tienen demanda en otras industrias, por ejemplo, entre los operadores de telecomunicaciones.

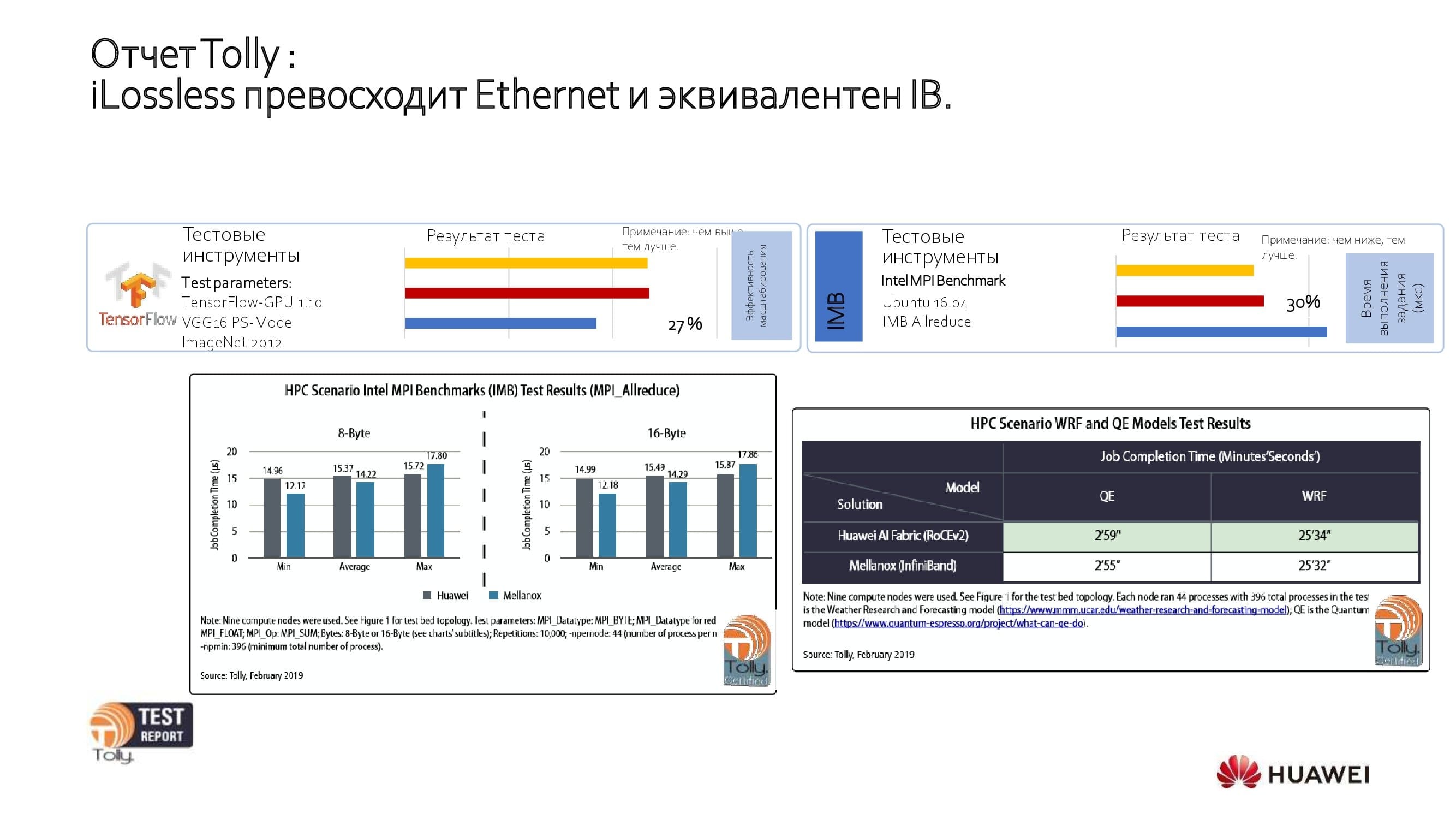

Veamos los resultados de las pruebas abiertas. El laboratorio independiente de Tolly Group ha probado nuestra solución y la ha comparado con las soluciones de Ethernet e IB de otros fabricantes. Las pruebas han demostrado que el rendimiento del producto de Huawei es equivalente al de IB y un 27% mejor que el de otros productos Ethernet importantes.

La red del centro de datos sin pérdidas demuestra la máxima eficiencia en varios escenarios, como:

- Entrenamiento de IA;

- almacenamiento centralizado;

- almacenamiento distribuido;

- Computación GPU de alto rendimiento.

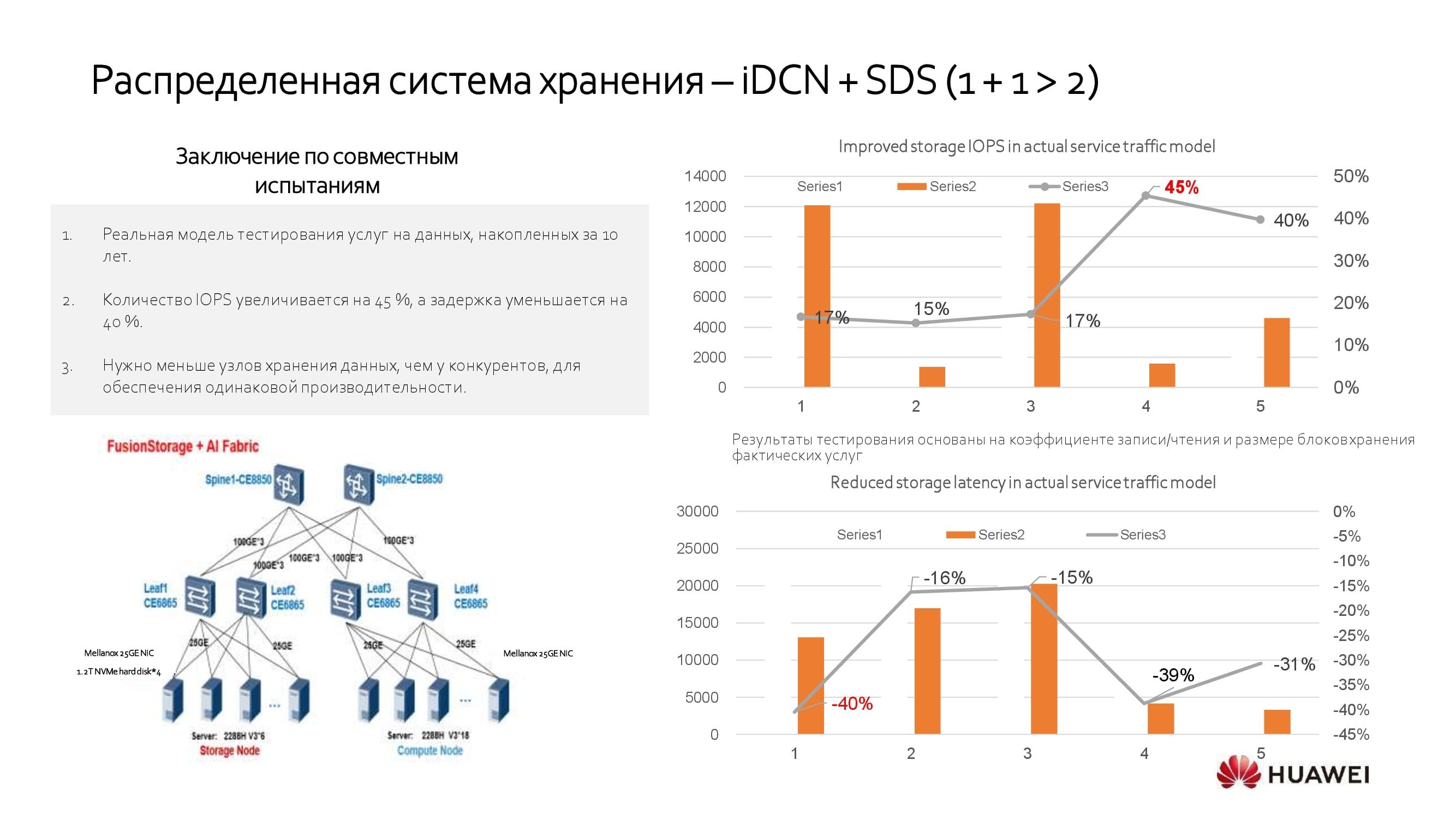

En conclusión, consideraremos uno de los escenarios para usar una red de centro de datos inteligente. Muchos clientes utilizan sistemas de almacenamiento distribuido (SDS). Al integrar sistemas de almacenamiento de software de diferentes fabricantes con nuestra solución, puede lograr un rendimiento un 40% mayor que sin ella. Esto significa que cuando conoce el nivel de rendimiento requerido de su SDS, puede lograrlo utilizando un 40% menos de servidores.

***

Por cierto, no se olvide de nuestros numerosos webinars que se llevan a cabo no solo en el segmento de habla rusa, sino también a nivel mundial. La lista de seminarios web de diciembre está disponible aquí .