Científicos británicos han capacitado a la inteligencia artificial para transformar el lenguaje hablado en video con un intérprete virtual de lenguaje de señas. El algoritmo evalúa de forma independiente la calidad del trabajo. La red neuronal ayudará a las personas con pérdida auditiva parcial o completa a mejorar la percepción del contenido y sentirse más libres en eventos públicos.

Hay decenas de millones de personas sordas y con problemas de audición en el mundo que utilizan el lenguaje de señas como su principal medio de comunicación. Por un lado, en el mundo online, el problema de la comunicación de las personas con discapacidad auditiva se resuelve con la ayuda de subtítulos. Pero, por otro lado, ahora los seminarios web populares, las transmisiones y otros contenidos deben traducirse al lenguaje de señas en tiempo real. Los científicos han estado investigando este problema durante mucho tiempo y buscando una solución.

Los investigadores ahora miran hacia la neurotecnología. En la Universidad de Surrey, los desarrolladores han creado un algoritmo de traducción de lenguaje de señas de nueva generación. La IA convierte el lenguaje hablado en movimientos del esqueleto humano. Luego, al esqueleto se le da una apariencia humana y se crea un metraje realista. Con la ayuda de la tecnología, también puede producir videos basados en texto.

¿Por qué tales dificultades y por qué es importante el movimiento de todo el esqueleto? El lenguaje de señas no se trata solo de señas con las manos, sino que involucra todas las partes del cuerpo e incluso las expresiones faciales. Las tecnologías anteriores a menudo generaban modelos borrosos, lo que conducía a la distorsión de los significados o incluso a la incomprensión del habla del intérprete de lenguaje de señas virtual.

Foto: ru.freepik.com

Cómo funciona la nueva red neuronal

El algoritmo se basa en lo siguiente: la señal de recepción viene en forma de audio, luego se convierte en un modelo esquemático del esqueleto humano, que reproduce el habla con los gestos apropiados. La secuencia de poses se envía luego a la red neuronal convolucional U-Net. La web convierte movimientos y poses en videos realistas.

Algoritmo de un intérprete de lenguaje de señas virtual

Para lograr altos resultados, los científicos entrenaron una red neuronal utilizando videos de intérpretes de lenguaje de señas reales.

Para evaluar el modelo resultante, los desarrolladores realizaron experimentos con voluntarios. Entonces, les pidieron que compararan el nuevo método con otros métodos de transformación de voz utilizados anteriormente. De las 46 personas, 13 hablaban lengua de signos. La comparación se llevó a cabo de acuerdo con cuatro parámetros, para cada uno de los cuales el nuevo algoritmo superó en calidad a las versiones anteriores.

Resultados de un estudio sobre voluntarios

No solo los científicos británicos

Los investigadores han estado trabajando en la traducción de la lengua de signos desde principios de siglo. Uno de los productos más famosos es el traductor virtual animado de IBM . Pero el proyecto no se desarrolló. Varios años después, se reencarnó en Novosibirsk. El programa , inventado por científicos del Novosibirsk Academgorodok, reconoce el habla, analiza el significado y se traduce al lenguaje de signos. Luego, el avatar muestra el texto en la pantalla.

Traductor animado de lenguaje de señas de los desarrolladores de Novosibirsk

En ese momento se creía que el desarrollo llegaría a ser tan popular como Google Translator. Ahora puede probar el programa en la aplicación Adaptis para AppStore y Google Play .

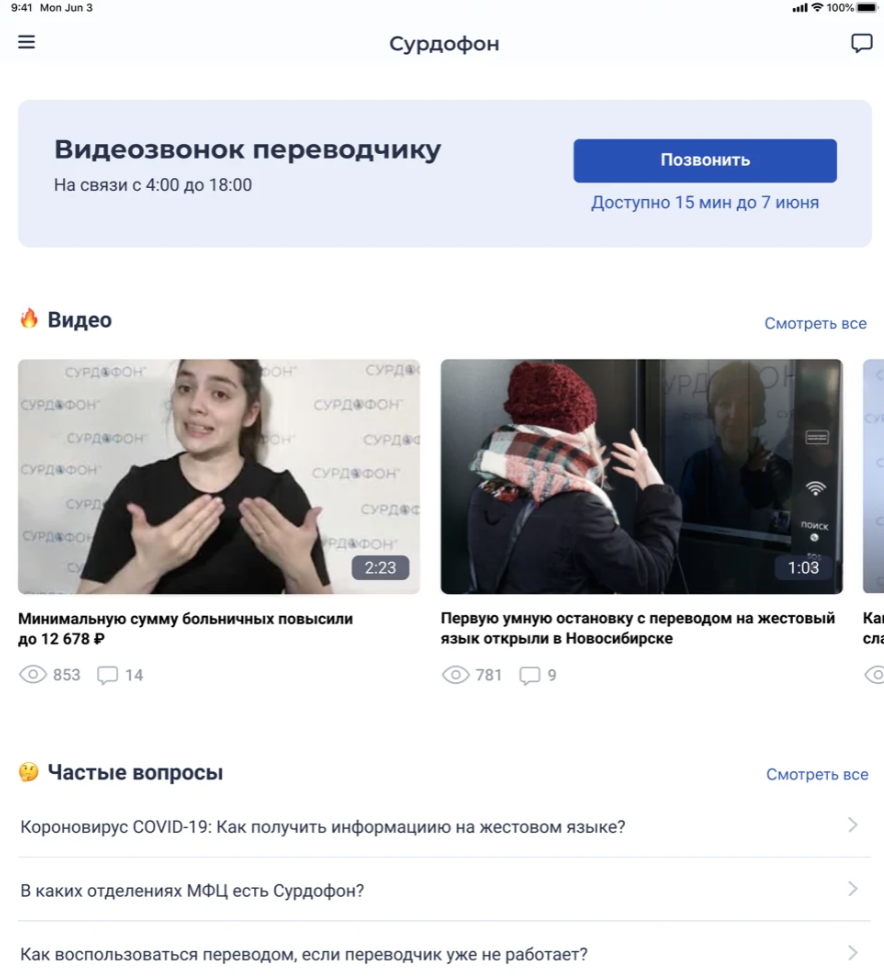

Captura de pantalla de la aplicación Adaptis en la App Store

Hace unos años, científicos belgas imprimieron una mano en 3D controlada por Arduino que también funciona como intérprete de lenguaje de señas. El proyecto se denominó ASLAN. El brazo constaba de 25 partes de PLA separadas. En el futuro, tenían la intención de agregarle otra mano y una cara robótica para transmitir emociones.

La traducción de la lengua de signos a la lengua a la que estamos acostumbrados también presenta grandes dificultades. Científicos rusos del Instituto de Problemas de Gestión. VIRGINIA. El Instituto Trapeznikov de Ciencias de Control de la Academia de Ciencias de Rusia (IPU RAS) comenzó hace unos años el desarrollo de dicha IA. En el futuro, se suponía que ayudaría a traducir los gestos en palabras, frases y letras. Luego, los científicos informaron que podría llevar más de un año crear un algoritmo.

Foto: ru.freepik.com El

programa ruso se basará en un sitio creado por un empleado con discapacidad auditiva del Instituto de Ciencias de Control de la Academia de Ciencias de Rusia. Ha estado desarrollando el sitio web Surdoserver durante varios años. Al mismo tiempo, se informó que los científicos rusos están trabajando en una aplicación móvil "Surdoservice" y una nube para sordos para el intercambio de información por personas con discapacidad auditiva.