En los últimos años, se han logrado avances significativos en el campo del procesamiento del lenguaje natural (NLP) , donde modelos como BERT , ALBERT , ELECTRA y XLNet han logrado una precisión asombrosa en una variedad de tareas. Durante el entrenamiento previo , las representaciones vectoriales se forman sobre la base de un extenso corpus de textos (por ejemplo, Wikipedia ), que se obtienen enmascarando palabras y tratando de predecirlas (el llamado modelado de lenguaje enmascarado). Las representaciones resultantes codifican una gran cantidad de información sobre el lenguaje y la relación entre conceptos, por ejemplo, entre un cirujano y un bisturí. Luego, comienza la segunda etapa del entrenamiento, el ajuste fino, en el que el modelo usa datos afinados para una tarea específica con el fin de aprender a realizar tareas específicas como la clasificación utilizando representaciones generales previamente entrenadas . Dado el uso generalizado de dichos modelos en varios problemas de PNL, es fundamental comprender qué información contienen y cómo las relaciones aprendidas afectan los resultados del modelo en sus aplicaciones para garantizar que cumplen con los Principios de Inteligencia Artificial (IA) .

El artículo “ Midiendo las correlaciones de género en modelos de PNL previamente entrenados ” explora el modelo BERT y su primo ligero ALBERT en busca de relaciones relacionadas con el género, y formula una serie de mejores prácticas para usar modelos de lenguaje previamente entrenados. Los autores presentan resultados experimentales en forma de ponderaciones de modelos públicos y conjuntos de datos exploratorios para demostrar la aplicación de las mejores prácticas y proporcionar una base para una mayor investigación de los parámetros, que está más allá del alcance de este artículo. Además, los autores planean establecer un conjunto de pesos Zari , en el que se reduce el número de correlaciones de género, pero se conserva una alta calidad en los problemas estándar de PNL.

Medición de correlaciones

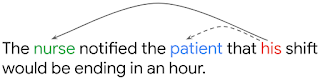

, , , . , . , , his («») nurse ( «»), patient («»).

– OntoNotes (Hovy et al., 2006). F1-, ( Tenney et al. 2019). OntoNotes , WinoGender, , , . ( 1) WinoGender , (.. nurse , ). , , , - , .

BERT ALBERT OntoNotes () WinoGender ( ). WinoGender , , .

, (Large) BERT, ALBERT WinoGender, ( 100%) (accuracy) OntoNotes. , . : , . , .. , , , , .

: NLP- ?

- : , , , . , BERT ALBERT 1% , 26% . : , WinoGender , , , , , , (male nurse).

- : , . , , , , . , , - (dropout regularization), : (dropout rate) BERT ALBERT, . , , , .

- : : , , WinoGender - . , OntoNotes ( BERT'), , - , . (. ).

, NLP-, . , . , , , , . , , , .

- — Kellie Webster

- Traducción - Ekaterina Smirnova

- Edición y maquetación - Sergey Shkarin