Foto de Cristian Cristian en Unsplash

En un futuro cercano, será posible activar el altavoz de voz Amazon Echo o Nest Audio, buscar en Google o Siri en dispositivos Apple sin un saludo como "¡Hola, Google!" Usando inteligencia artificial, científicos de los Estados Unidos han desarrollado un algoritmo gracias al cual los asistentes de voz inteligentes entienden que una persona les está hablando.

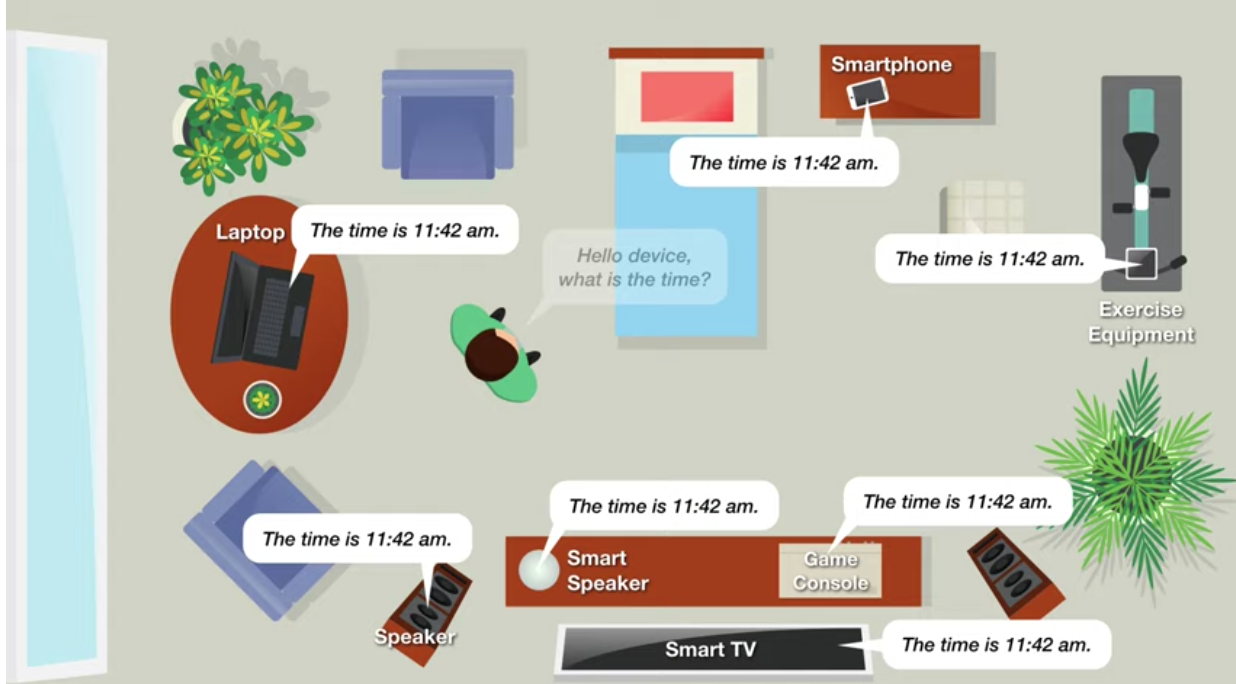

En una conversación normal, las personas designan al destinatario del mensaje simplemente mirándolo. Pero la mayoría de los dispositivos de voz están diseñados para activarse con frases clave que nadie pronuncia en una comunicación real. La comprensión de las señales no verbales por parte de los asistentes de voz haría que la comunicación fuera más fácil e intuitiva. Especialmente si hay varios dispositivos de este tipo en la casa.

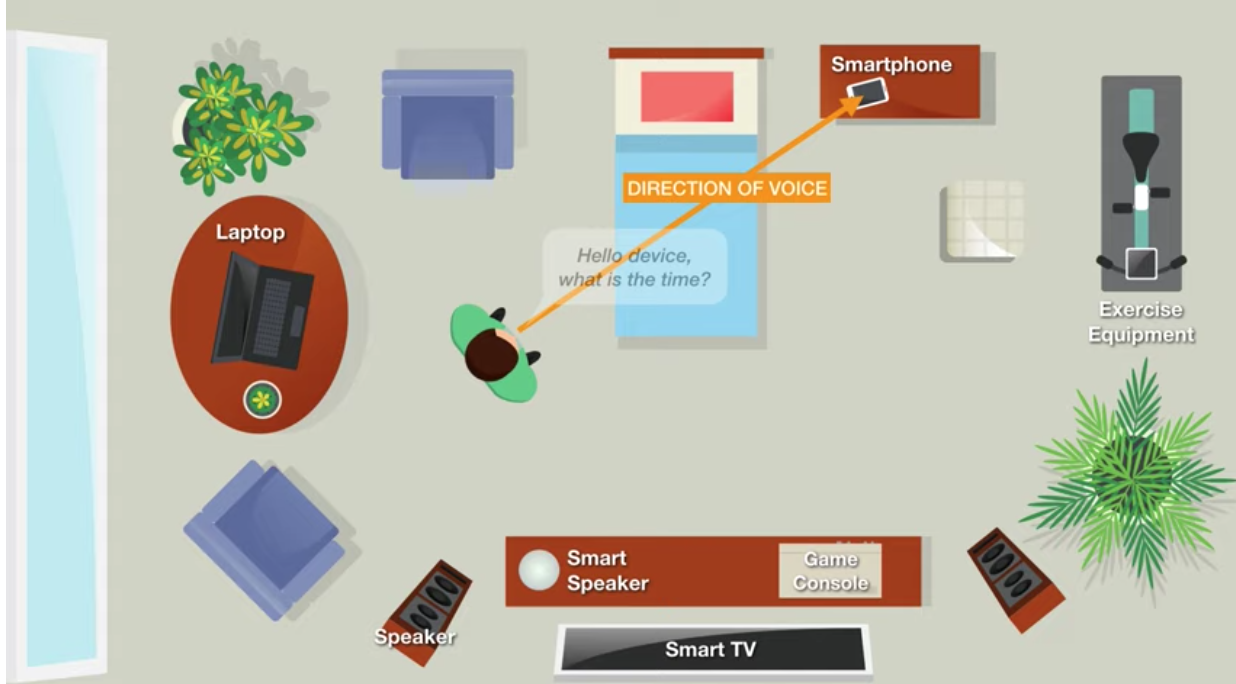

Los científicos de la Universidad Carnegie Mellon señalan que el algoritmo desarrollado determina la dirección de la voz (DoV) utilizando un micrófono.

DoV es diferente a detectar la dirección de llegada (DoA).

Según los investigadores, el uso de DoV hace posible los comandos dirigidos, que se asemeja al contacto visual con los interlocutores al iniciar una conversación. Sin embargo, las cámaras de los dispositivos no están involucradas. Por lo tanto, existe una interacción natural con diferentes tipos de dispositivos sin confusión.

Entre otras cosas, la tecnología reducirá la cantidad de activaciones accidentales de los asistentes de voz que están en espera todo el tiempo.

La nueva tecnología de audio se basa en las características de la propagación del sonido del habla. Si la voz se dirige al micrófono, entonces está dominada por las frecuencias bajas y altas. Si la voz se refleja, es decir, inicialmente dirigida a otro dispositivo, habrá una disminución notable en las frecuencias altas en comparación con las bajas.

El algoritmo también analizapropagación del sonido en los primeros 10 milisegundos. Aquí son posibles dos escenarios: El

usuario se gira hacia el micrófono. La señal que llega primero al micrófono será clara en comparación con otras posibles señales reflejadas desde otros dispositivos de la casa.

El usuario se aparta del micrófono. Todas las vibraciones sonoras se duplicarán y distorsionarán.

El algoritmo mide la forma de la señal, calcula el pico de su intensidad, lo compara con el valor medio y determina si la voz se dirigió hacia el micrófono o no.

Al medir la propagación de la voz, los científicos pudieron determinar, con una precisión del 93,1%, si un altavoz está frente a un micrófono en particular o no. Señalaron que este es el mejor resultado hasta la fecha y un paso importante hacia la implementación de la solución en los dispositivos existentes. Al intentar determinar uno de los ocho ángulos en los que una persona mira el dispositivo, se logró una precisión del 65,4%. Esto todavía no es suficiente para una aplicación, cuya esencia es la interacción activa con los usuarios.

Para recopilar información, los ingenieros utilizaron Python, las señales se procesaron según el algoritmo clasificador Extra-Trees.

Los datos y el algoritmo recopilados durante el desarrollo están abiertos a GitHub . Se pueden utilizar al crear su propio asistente de voz.