La revolución de la inteligencia artificial moderna comenzó con un discreto concurso de investigación. Esto sucedió en 2012, el tercer año de la competencia ImageNet. El desafío para los equipos era construir una solución que reconociera mil imágenes, desde animales y personas hasta paisajes.

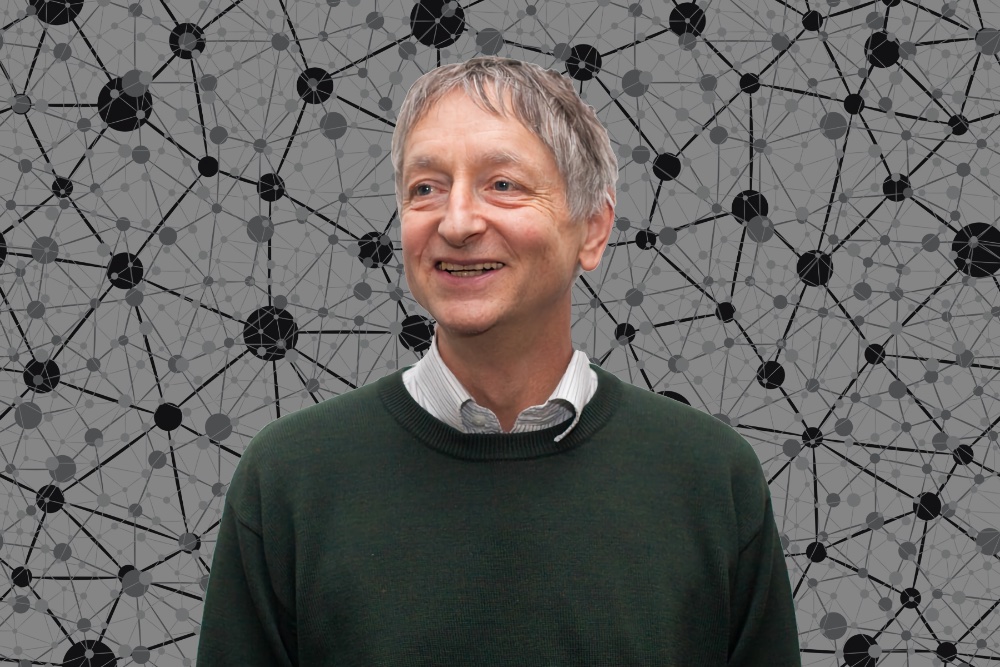

En los dos primeros años, los mejores equipos no lograron más del 75% de precisión. En el tercer año, un equipo de investigadores, un profesor y sus estudiantes, rompió repentinamente ese techo. Ganaron la competencia por un asombroso 10,8%. El profesor se llamaba Geoffrey Hinton y su método era el aprendizaje profundo.

Hinton ha trabajado con el aprendizaje profundo desde la década de 1980, pero la eficiencia se ha visto limitada por la falta de datos y poder computacional. Su fe inquebrantable en el método finalmente pagó enormes dividendos. En el cuarto año de la competencia, casi todos los equipos aplicaron el aprendizaje profundo, logrando ganancias milagrosas en precisión. Pronto, el aprendizaje profundo comenzó a aplicarse en diversas industrias, y no solo en tareas de reconocimiento de imágenes.

El año pasado, Hinton, junto con los pioneros de la inteligencia artificial Jan Lecun y Joshua Bengio, recibieron el Premio Turing por Contribuciones Fundamentales en este campo de la ciencia.

Crees que el aprendizaje profundo será suficiente para replicar toda la inteligencia humana. ¿Qué te da tanta confianza?

Creo que el aprendizaje profundo puede hacer todo, pero creo que debe haber bastantes avances conceptuales. Por ejemplo, en 2017, Ashish Vaswani y sus colegas introdujeron transformadores que generan vectores realmente buenos que representan el significado de las palabras. Fue un gran avance conceptual. Ahora se utiliza en casi todos los mejores procesos de lenguaje natural. Necesitaremos muchos de estos avances.

Y si logramos tales avances, ¿acercaremos la inteligencia artificial a la inteligencia humana mediante el aprendizaje profundo?

Si. Especialmente los avances relacionados con cómo se obtienen grandes vectores de actividad neuronal para implementar cosas como el pensamiento. Pero también necesitamos una escala enorme. El cerebro humano tiene alrededor de cien billones de parámetros o sinapsis. El modelo realmente grande que ahora llamamos GPT-3 con 175 mil millones de parámetros. Esto es mil veces más pequeño que el cerebro. GPT-3 ahora puede generar texto bastante creíble, pero aún es pequeño en comparación con el cerebro.

Cuando habla de escala, ¿se refiere a grandes redes neuronales, datos o ambos?

Ambos. Existe un desajuste entre lo que sucede en la informática y lo que sucede en los humanos. Las personas tienen una gran cantidad de parámetros en comparación con la cantidad de datos que reciben. Las redes neuronales funcionan sorprendentemente bien con muchos menos datos y más parámetros, pero los humanos son incluso mejores.

Muchos especialistas en IA creen que la cordura de la IA es una habilidad que debe perseguirse más. ¿Estás de acuerdo?

Estoy de acuerdo en que esta es una de las cosas más importantes. También creo que el control del movimiento es muy importante y las redes de aprendizaje profundo se están volviendo buenas en la actualidad. En particular, un trabajo reciente de Google ha demostrado que es posible combinar la motricidad fina y el habla de tal manera que el sistema puede abrir un cajón del escritorio, eliminar un bloque y contar en lenguaje natural lo que ha hecho.

Para cosas como GPT-3, que genera grandes textos, está claro que tiene que entender mucho para generar texto, pero no está realmente claro cuánto entiende. Pero cuando algo abre un cajón, saca un bloque y dice: "Acabo de abrir un cajón y saqué un bloque", es difícil decir que no entiende lo que está haciendo.

Los especialistas en IA siempre han considerado al cerebro humano como una fuente inagotable de inspiración, y los diferentes enfoques de la IA se han derivado de diferentes teorías de la ciencia cognitiva. ¿Crees que el cerebro realmente está construyendo una idea del mundo para comprenderlo o es solo una forma útil de pensar?

En ciencia cognitiva, ha habido un debate durante mucho tiempo entre las dos escuelas de pensamiento. El líder de la primera escuela, Stephen Kosslin, creía que cuando el cerebro opera con imágenes visuales, estamos hablando de píxeles y sus movimientos. La segunda escuela estaba más en línea con la IA tradicional. Sus seguidores dijeron: “No, no, esto es una tontería. Estas son descripciones estructurales jerárquicas. La mente tiene una cierta estructura simbólica, nosotros controlamos esta misma estructura ".

Creo que ambas escuelas cometieron el mismo error. Kosslin pensó que estábamos manipulando píxeles porque las imágenes externas están formadas por píxeles y los píxeles son la representación que entendemos. La segunda escuela pensó que debido a que manipulamos la representación simbólica y representamos las cosas a través de símbolos, es la representación simbólica lo que entendemos. Creo que estos errores son equivalentes. Dentro del cerebro hay grandes vectores de actividad neuronal.

Hay personas que todavía creen que la representación simbólica es un enfoque de la IA.

Muy bien. Tengo buenos amigos, como Héctor Levesque, que realmente cree en el enfoque simbólico y ha hecho un gran trabajo en este sentido. No estoy de acuerdo con él, pero el enfoque simbólico es algo perfectamente razonable de intentar. Sin embargo, creo que al final nos damos cuenta de que los símbolos solo existen en el mundo exterior y realizamos operaciones internas en grandes vectores.

¿Qué visión de la IA considera más opuesta en relación con los demás?

Bueno, mi problema es que tenía estos puntos de vista opuestos y, después de cinco años, se generalizaron. La mayoría de mis puntos de vista opuestos de la década de 1980 ahora son ampliamente aceptados. Ahora es bastante difícil encontrar personas que no estén de acuerdo con ellos. Así que sí, mis puntos de vista opuestos se vieron socavados de alguna manera.

Quién sabe, tal vez sus puntos de vista y métodos de trabajo con IA también sean clandestinos, y en unos años se convertirán en el estándar de la industria. Lo principal es no detenerse en tu progreso. Y estaremos encantados de ayudarte con esto presentando un código de promoción especial HABR , que agregará un 10% al descuento en el banner.

- Curso avanzado "Machine Learning Pro + Deep Learning"

- Curso "Matemáticas y aprendizaje automático para la ciencia de datos"

- Curso de aprendizaje automático

- Formación profesional en ciencia de datos

- Data Analyst

- - Data Analytics