La IA aprende a generar imágenes a partir de firmas y comienza a comprender mejor nuestro mundo

De todos los modelos de inteligencia artificial, fue el GPT-3 de OpenAI el que más capturó la imaginación del público. Ella, sin mucha pauta, puede escupir poemas, cuentos y canciones, haciéndote pensar que son obra de una persona. Pero la elocuencia es solo un truco y no debe confundirse con la inteligencia real.

Sin embargo, los investigadores creen que las mismas técnicas que se utilizaron para crear GPT-3 esconden el secreto para crear una IA más avanzada . GPT-3 se entrenó con una gran cantidad de información de texto. ¿Y si se entrenaran las mismas técnicas simultáneamente en texto e imágenes?

Un nuevo estudio llamado AI2 del Instituto Paul Allen de Inteligencia Artificial ha llevado esta idea al siguiente nivel. Los investigadores han creado un modelo visual-lingüístico especial. Trabaja con texto e imágenes y puede generar estas últimas a partir de firmas. Las imágenes se ven inquietantes y extrañas, en absoluto como las falsificaciones hiperrealistas creadas por las redes generativas adversarias (GAN). Pero pueden mostrar una nueva dirección para una inteligencia más práctica y quizás hacer que los robots sean más inteligentes.

Llenar el vacío

El GPT-3 pertenece a un grupo de modelos conocidos como "transformadores". Primero ganaron popularidad gracias al éxito de BERT, el algoritmo de Google. Antes de BERT, los modelos de lenguaje eran bastante malos. Sus habilidades predictivas fueron suficientes para autocompletar, pero no para componer oraciones largas, donde se observan reglas gramaticales y sentido común.

BERT cambió la situación al introducir una nueva técnica llamada enmascaramiento ( nota : el nombre original es enmascaramiento). Implica que diferentes palabras se esconden en la oración, y el modelo debe llenar el vacío. Ejemplos:

- La mujer fue a ___ a practicar.

- Compraron ___ pan para hacer sándwiches.

La idea es que si fuerza al modelo a hacer estos ejercicios, a menudo un millón de veces, comenzará a descubrir patrones en cómo las palabras se ensamblan en oraciones y las oraciones en párrafos. Como resultado, el algoritmo genera e interpreta mejor el texto, acercándose más a la comprensión del significado del idioma. (Google ahora está usando BERT para ofrecer resultados de búsqueda más relevantes). Después de que el enmascaramiento demostró ser extremadamente efectivo, los investigadores intentaron aplicarlo a modelos de lenguaje visual ocultando palabras en firmas. De este modo:

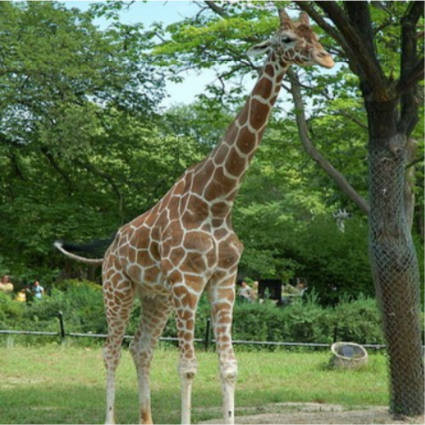

____ está en el suelo junto a un árbol. Fuente: AI2

Esta vez, el modelo podría mirar las palabras circundantes y el contenido de la imagen para llenar el vacío. Después de un millón de repeticiones, aprendió a detectar no solo los patrones de las palabras, sino también la conexión de las palabras con los elementos de cada imagen.

Como resultado, los modelos pueden vincular las relaciones textuales con ejemplos visuales de cómo los bebés hacen conexiones entre las palabras aprendidas y las cosas que ven. Las modelos pueden tomar la foto de abajo y poner una leyenda significativa, como "Mujeres jugando hockey sobre césped". O podrían responder una pregunta como "¿De qué color es la pelota?" Asociando la palabra "pelota" con un objeto circular en una fotografía.

Un modelo de lenguaje visual puede hacer una leyenda significativa para esta fotografía: "Mujeres jugando hockey sobre césped". Fuente: JOHN TORCASIO / UNSPLASH

Mejor ver la foto una vez

Los investigadores querían saber si estos modelos desarrollan una comprensión conceptual del mundo visual. Un niño que ha aprendido una palabra para un objeto no solo puede nombrarlo, sino también dibujar el objeto de acuerdo con la pista, incluso si el objeto en sí está ausente. Entonces, el equipo del proyecto AI2 sugirió que los modelos hicieran lo mismo: generar imágenes a partir de leyendas. Todos los modelos produjeron basura de píxeles sin sentido.

¿Es un pajaro? ¿Esto es un avión? No, esto es un galimatías generado por inteligencia artificial. Fuente: AI2

Tiene sentido: convertir texto en una imagen es más difícil que hacer lo contrario. "La firma no define todo en la imagen", dice Ani Kembhavi, líder del equipo de visión por computadora de AI2. Por lo tanto, el modelo debe basarse en una gran cantidad de conocimiento sobre nuestro mundo para agregar detalles faltantes.

Por ejemplo, si se le pide a una modelo que dibuje una "jirafa caminando por una carretera", entonces debe concluir que la carretera será gris en lugar de rosa brillante y pasará junto a un campo en lugar del mar. Aunque toda esta información no es explícita.

Entonces, Kembhavi y sus colegas Jemin Cho, Jiasen Lu y Hannane Hajishirzi decidieron ver si podían enseñarle al modelo todo este conocimiento visual oculto modificando el enfoque del enmascaramiento. En lugar de entrenar el algoritmo para predecir simplemente las palabras "enmascaradas" en los subtítulos de las fotos correspondientes, también lo entrenaron para predecir los píxeles "enmascarados" en las fotos basándose en los subtítulos correspondientes.

Las imágenes finales creadas por el modelo no son del todo realistas. Pero no importa. Contienen los conceptos visuales correctos de alto nivel. La IA se comporta como un niño que dibuja un tablero para representar a una persona. (Puede probar el modelo usted mismo aquí ).

Imágenes de muestra generadas por el modelo AI2 a partir de subtítulos. Fuente: AI2

La capacidad de los modelos de lenguaje visual para generar tales imágenes representa un importante paso adelante en la investigación de la inteligencia artificial. Esto sugiere que el modelo es realmente capaz de un cierto nivel de abstracción, una habilidad fundamental para comprender el mundo.

A largo plazo, la habilidad puede tener importantes implicaciones para la robótica. Cuanto mejor comprenda el robot el entorno y utilice el lenguaje para comunicarse, más complejas serán las tareas que podrá realizar. A corto plazo, señala Hajishirzi, la visualización ayudará a los investigadores a comprender mejor qué está aprendiendo exactamente el modelo, que ahora funciona como una caja negra.

En el futuro, el equipo planea experimentar más, mejorar la calidad de la generación de imágenes y expandir el vocabulario y visual del modelo: para incluir más temas, objetos y adjetivos.

“La creación de las imágenes fue realmente la pieza que faltaba en el rompecabezas”, dice Lu. "Al agregarlo, podemos enseñar el modelo para comprender mejor nuestro mundo".