50 años de historia de las tarjetas de video (1970-2020): una historia completa de las tarjetas de video y sus progenitores

Parte 1

Gráficos de computadora. Al escuchar estas palabras, presentamos impresionantes efectos especiales de grandes éxitos de taquilla, hermosos modelos de personajes de juegos AAA y todo lo que tiene que ver con la belleza visual de la tecnología moderna. Pero la infografía, como cualquier aspecto tecnológico, se viene desarrollando desde hace más de una década, habiendo superado el camino desde la visualización de varios personajes en una pantalla monocromática hasta paisajes y héroes asombrosos, cada año cada vez más difíciles de distinguir de la realidad. Hoy comenzaremos una historia sobre cómo comenzó la historia de los gráficos por computadora, recordemos cómo apareció el término "tarjeta de video" y la abreviatura de GPU, y qué límites técnicos han superado los líderes del mercado año tras año en un esfuerzo por conquistar una nueva audiencia.

Prólogo de la época. El nacimiento de las computadoras (décadas de 1940 y 1950)

La era de la tecnología informática, muchos la asocian con el comienzo de la era de las computadoras personales a principios de los 80, pero de hecho, las primeras computadoras aparecieron mucho antes. El primer desarrollo de tales máquinas comenzó incluso antes de la Segunda Guerra Mundial, y ya en 1947 se lanzaron prototipos, que se asemejan vagamente a las futuras PC. El primer dispositivo de este tipo fue el IBM 610, una computadora experimental desarrollada por John Lenz del Laboratorio Watson de la Universidad de Columbia. Fue el primero en la historia en recibir el orgulloso nombre de "Computadora Personal Automática" (PAC), aunque fue un poco exagerado: la máquina costó $ 55 mil y solo se hicieron 150 copias.

Los primeros sistemas visuales impresionantes aparecieron en los mismos años. Ya en 1951, IBM, con la participación de General Electric y varios contratistas militares, desarrolló un simulador de vuelo para las necesidades del ejército. Utilizaba tecnología de virtualización 3D: el piloto, que estaba detrás del simulador, veía la proyección de la cabina y podía actuar como lo haría a los mandos de un avión real. Más tarde, el prototipo gráfico fue utilizado por Evans & Sutherland, que creó un simulador piloto CT5 completo, basado en una serie de computadoras DEC PDP-11. Piensa: todavía estamos en los 50 y ya teníamos gráficos tridimensionales.

1971-1972. Magnavox Odyssey y PONG

El auge de la tecnología de semiconductores y la fabricación de microcircuitos ha cambiado por completo el equilibrio de poder en el mercado, antes propiedad de voluminosos ordenadores analógicos que ocupaban pasillos enteros. Alejándose de los tubos de vacío y las tarjetas perforadas, la industria ha entrado en la era del entretenimiento familiar, presentando al mundo occidental los "sistemas de videojuegos domésticos", las bisabuelas de las consolas modernas.

Un pionero en el entretenimiento de los videojuegos fue un dispositivo llamado Odyssey Magnavox, el primer sistema de juego lanzado oficialmente. La Odyssey tenía controladores extravagantes para los estándares modernos, y todo el sistema gráfico mostraba solo una línea y dos puntos en la pantalla del televisor, que eran controlados por los jugadores. Los creadores del dispositivo abordaron el tema con imaginación, y la consola vino con superposiciones de colores especiales en la pantalla que podrían "pintar" los mundos de juego de varios proyectos que vienen con Odyssey. Se lanzaron un total de 28 juegos para el dispositivo, entre los que se encontraba un ping-pong aparentemente simple, que inspiró a los entusiastas de la joven compañía Atari a lanzar una máquina tragamonedas llamada Pong con un juego idéntico. Fue Pong el que se convirtió en el comienzo de la magia de las máquinas tragamonedas, que, por cierto, cautivaron por completo tanto a Japón como al mundo occidental a principios de los 80.

A pesar de su obvia simplicidad, el Magnavox Odyssey usó cartuchos reales, aunque de muchas maneras solo por efecto. No tenían chips de memoria: los cartuchos servían como un conjunto de puentes, transformando mágicamente una disposición de una línea con puntos en otra, cambiando así el juego. El decodificador primitivo estaba lejos de ser un chip de video en toda regla, pero la popularidad de Magnavox Odyssey mostró un claro interés del público, y muchas empresas comenzaron a desarrollar sus propios dispositivos, sintiendo el potencial de ganancias.

1976-1977. Fairchild Channel F y Atari 2600

No pasó mucho tiempo para esperar la primera batalla seria para el mercado de los juegos recién nacidos. En 1975, la Magnavox Odyssey, que envejecía rápidamente, desapareció de los estantes, y en su lugar dos dispositivos lucharon por el título de la mejor consola de nueva generación: Channel F de Fairchild y Atari VCS de la misma compañía que le dio al mundo Pong.

A pesar de que el desarrollo de las consolas se llevó a cabo casi simultáneamente, Atari no tuvo tiempo, y Fairchild fue el primero en lanzar su dispositivo llamado Fairchild Video Entertainment System (VES).

La consola Fairchild llegó a los estantes de las tiendas en noviembre de 1976 y es un tesoro de fortalezas técnicas. En lugar de controladores Odyssey indistintos, aparecieron los convenientes, los cartuchos falsos fueron reemplazados por cartuchos reales (dentro de los cuales había chips ROM con datos del juego) y se instaló un altavoz dentro de la consola que reproducía sonidos y música de un juego en ejecución. El archivo adjunto pudo dibujar una imagen utilizando una paleta de 8 colores (en modo de línea o color en blanco y negro) con una resolución de 102x54 píxeles. Por separado, cabe señalar que el procesador Fairchild F8 instalado en el sistema VES fue desarrollado por Robert Noyce, quien en 1968 fundó una pequeña pero prometedora empresa Intel.

Atari estaba al borde de la desesperación: el proyecto Stella, la base de la futura consola, estaba muy atrás en términos de desarrollo y el mercado, como saben, no esperará. Muchas cosas que parecían innovadoras con el lanzamiento de Fairchild VES estaban a punto de convertirse en una parte integral de todas las consolas futuras. Al darse cuenta de que todo está en juego, el fundador de Atari, Nolan Bushnell, firma un acuerdo con Warner Communications, vendiendo su creación por 28 millones de dólares, con la condición de que la consola Atari llegue al mercado lo antes posible.

Warner no defraudó y el trabajo en la consola empezó a hervir con renovado vigor. Para simplificar la lógica y reducir el costo de producción, el famoso ingeniero Jay Miner participó en el desarrollo, quien reelaboró los chips TIA (Adaptador de interfaz de televisión) de salida de video y procesamiento de audio en un solo elemento, que fue el toque final antes de que la consola estuviera lista. Para molestar a Fairchild, los comercializadores de Atari nombraron la consola VCS (Video Computer System), lo que obligó al competidor a cambiar el nombre del Canal F.

Pero esto no ayudó a Channel F a competir con éxito con el nuevo producto, aunque en la etapa del lanzamiento de la consola en 1977 solo estaban listos 9 juegos, los desarrolladores se dieron cuenta rápidamente del inicio de una nueva era tecnológica y comenzaron a usar el poder de la consola al máximo. El Atari VSC (que más tarde se convertiría en el Atari 2600) fue el primer decodificador basado en un chip complejo, no solo procesando video y audio, sino también comandos recibidos desde el joystick. Las modestas ventas, que inicialmente avergonzaron a Warner, dieron paso a un éxito fenomenal después de la decisión de licenciar la sala de juegos Space Invaders por parte de la compañía japonesa Taito. Los cartuchos, inicialmente limitados a 4 KB de memoria, eventualmente crecieron a 32 KB, y la cantidad de juegos se contaba por cientos.

El secreto del éxito de Atari radica en la lógica más simplificada del dispositivo, la capacidad de los desarrolladores para programar juegos de manera flexible utilizando 2600 recursos (por ejemplo, para poder cambiar el color del sprite mientras dibuja), así como el atractivo externo y los controladores convenientes llamados joysticks (del joystick literal , el palo de la felicidad) ... Entonces, si no sabía de dónde vino este término, puede agradecer a los desarrolladores de Atari por ello. Además de la imagen principal de todos los juegos retro: un extraterrestre divertido de Space Invaders.

Después de que el éxito del Atari 2600 fue más allá de todos los valores predichos, Fairchild abandonó el mercado de los videojuegos y decidió que la dirección pronto desaparecería. Lo más probable es que la empresa aún se arrepienta de esa decisión.

1981-1986. La era de la PC de IBM.

A pesar de que ya en 1979 Apple introdujo el Apple II, que cambió para siempre la imagen de la computadora accesible, el concepto de "computadora personal" apareció un poco más tarde y pertenecía a una empresa completamente diferente. La monumental IBM, con décadas de engorrosos mainframes (ruido de bobina y luces parpadeantes) detrás, de repente se hizo a un lado y creó un mercado que nunca antes había existido.

En 1981, salió a la venta el legendario IBM PC, precedido por una de las mejores campañas publicitarias de la historia del marketing. “Nadie ha sido despedido por comprar IBM”, decía el mismo lema que quedará para siempre en la historia de la publicidad.

Sin embargo, no fueron solo los eslóganes y los llamativos anuncios publicitarios los que dieron nombre a la computadora personal de IBM. Fue para él que, por primera vez en la historia, se desarrolló un sistema de gráficos complejo a partir de dos adaptadores de video: un Adaptador de pantalla monocromática (MDA) y un Adaptador de gráficos en color (CGA).

MDA fue diseñado para escribir con soporte para 80 columnas y 25 líneas en la pantalla para caracteres ASCII a una resolución de 720 × 350 píxeles. El adaptador usaba memoria de video 4K y mostraba texto verde en una pantalla negra. En este modo, era fácil y conveniente trabajar con equipos, documentos y otras tareas diarias del sector empresarial.

El CGA, por otro lado, podría considerarse un gran avance en términos de capacidades gráficas. El adaptador admitía una paleta de 4 bits con una resolución de 640x200 píxeles, tenía 16 Kb de memoria y formó la base del estándar de gráficos por computadora para la línea en expansión activa de computadoras IBM PC.

Sin embargo, existían serios inconvenientes al usar dos adaptadores de salida de video diferentes. Una gran cantidad de posibles problemas técnicos, el alto costo de los dispositivos y una serie de otras restricciones empujaron a los entusiastas a trabajar en una solución universal: un adaptador de gráficos que puede funcionar en dos modos simultáneamente. El primer producto de este tipo en el mercado fue la tarjeta gráfica Hercules (HGC), desarrollada por la empresa homónima Hercules en 1984.

Tarjeta gráfica Hercules (HGC)

Según la leyenda, el fundador de Hércules, Van Suwannukul, desarrolló un sistema específicamente para trabajar en su tesis doctoral en su idioma nativo tailandés. El adaptador estándar de IBM MDA no representaba correctamente la fuente tailandesa, lo que llevó al desarrollador a comenzar a construir HGC en 1982.

La compatibilidad con 720x348 píxeles tanto para texto como para gráficos, así como la capacidad de trabajar en los modos MDA y CGA, aseguraron una larga vida para el adaptador Hercules. El legado de la compañía en forma de estándares de salida de video universales HGC y HGC + fue utilizado por los desarrolladores de computadoras compatibles con IBM y más tarde por otros sistemas hasta finales de los 90. Sin embargo, el mundo no se detuvo y el rápido desarrollo de la industria de la computación (así como su parte gráfica) atrajo a muchos otros entusiastas, entre ellos cuatro migrantes de Hong Kong, Hwo Yuan Ho, Lee Lau, Francis Lau. (Francis Lau) y Benny Lau (Benny Lau), quienes fundaron Array Technology Inc, una empresa que todo el mundo reconocerá como ATI Technologies Inc.

1986-1991. El primer boom en el mercado de las tarjetas gráficas. Éxitos tempranos de ATI

Después del lanzamiento de IBM PC, IBM no permaneció a la vanguardia de la tecnología informática por mucho tiempo. Ya en 1984, Steve Jobs presentó el primer Macintosh con una interfaz gráfica impresionante, y para muchos resultó obvio que la tecnología gráfica estaba a punto de dar un salto adelante. Pero a pesar de perder el liderazgo de la industria, IBM se distingue de Apple y otros competidores en su visión. La filosofía de IBM de estándares abiertos abrió la puerta a cualquier dispositivo compatible, lo que atrajo a numerosas empresas emergentes de su tiempo al campo.

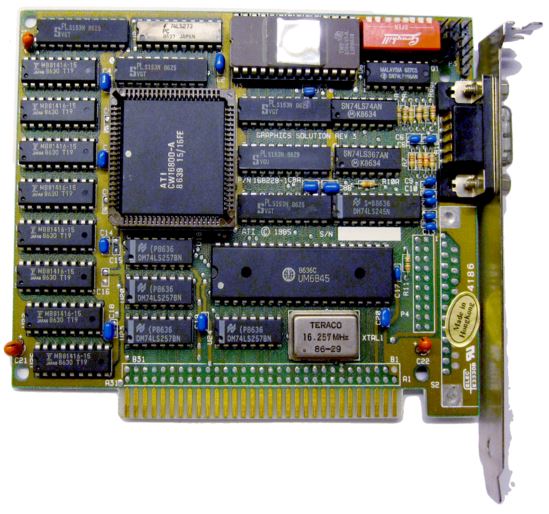

Entre ellos se encontraba la joven empresa ATI Technologies. En 1986, los especialistas de Hong Kong presentaron su primer producto comercial, la tarjeta de emulación de color OEM.

Tarjeta de emulación de color

Ampliando las capacidades de los controladores monocromáticos estándar, los ingenieros de ATI proporcionaron tres colores de fuente en una pantalla negra: verde, ámbar y blanco. El adaptador tenía 16 KB de memoria y resultó ser parte de las computadoras Commodore. En su primer año de ventas, el producto aportó a ATI más de $ 10 millones.

Por supuesto, este fue solo el primer paso para ATI: después de la solución gráfica ampliada con 64 KB de memoria de video y la capacidad de trabajar en tres modos (MDA, CGA, EGA), la línea ATI Wonder ingresó al mercado, con la apariencia de que los estándares anteriores podrían escribirse en arcaísmos. ...

¿Suena demasiado atrevido? Juzgue usted mismo: los adaptadores de la serie Wonder recibieron un búfer de 256 KB de memoria de video (¡4 veces más!), Y en lugar de una paleta de cuatro colores, se mostraron 16 colores en la pantalla con una resolución de 640x350. Al mismo tiempo, no hubo restricciones al trabajar con varios formatos de salida: ATI Wonder emuló con éxito cualquiera de los primeros modos (MDA, CGA, EGA) y, a partir de la segunda serie, recibió soporte para el último estándar Extend EGA.

ATi Wonder

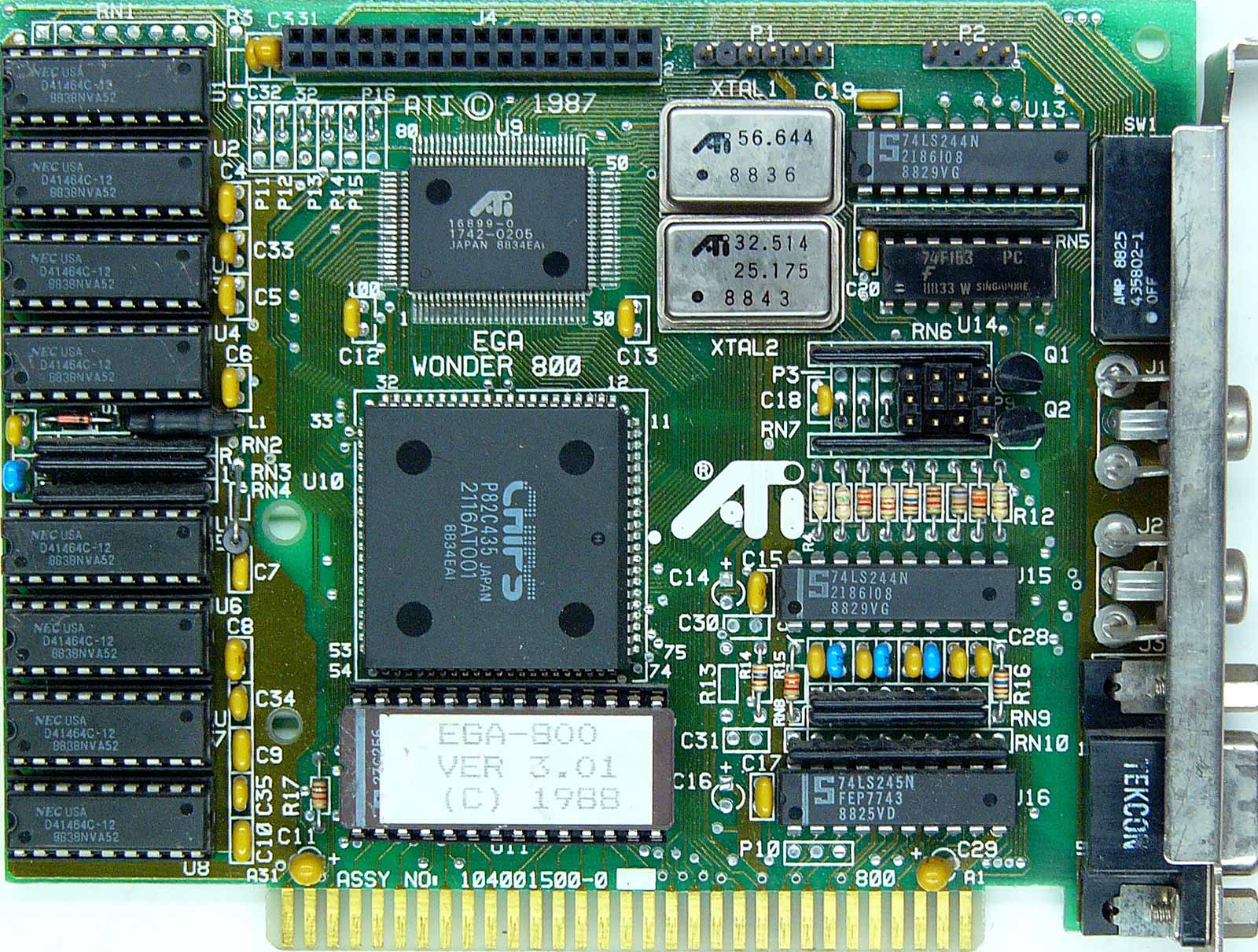

La culminación del desarrollo de la línea en 1987 fue el famoso ATI EGA Wonder 800, que mostraba una paleta de 16 colores ya en formato VGA en una resolución increíblemente alta de 800x600. El adaptador se vendió en el formato VGA Improved Performance Card (VIP) más asequible con soporte de salida VGA limitado.

El primer apogeo del mercado de las tarjetas de video. Innovaciones ATI, el inicio de la competición

El éxito significativo de ATI en el desarrollo de adaptadores gráficos comerciales atrajo la atención de muchas otras empresas: de 1986 a 1987, marcas como Trident, SiS, Tamarack, Realtek, Oak Technology, LSI (G-2 Inc), Hualon, Cornerstone Imaging y Windbond. Además de las caras nuevas, los representantes actuales de Silicon Valley también se interesaron en ingresar al mercado de gráficos, como compañías como AMD, Western Digital / Paradise Systems, Intergraph, Cirrus Logic, Texas Instruments, Gemini y Genoa, cada uno de ellos presentó de alguna manera el primer producto gráfico en el mismo período de tiempo.

En 1987, ATI ingresó al mercado OEM como proveedor con la serie de productos Graphics Solution Plus. Esta línea fue diseñada para funcionar con el bus de 8 bits de las computadoras IBM PC / XT basadas en la plataforma Intel 8086/8088. Los adaptadores GSP también admitían los formatos de salida MDA, CGA y EGA, pero con el cambio original entre ellos en la propia placa. El dispositivo fue bien recibido en el mercado, e incluso un modelo similar de Paradise Systems con 256 KB de memoria de video (GSP tenía solo 64 KB) no impidió que Ati agregara un nuevo producto exitoso a su cartera.

Durante los próximos años, la empresa canadiense ATI Technologies Inc. se mantuvo en la cima de la innovación gráfica, superando constantemente a la competencia. La entonces conocida línea de adaptadores Wonder fue la primera en el mercado en cambiar al color de 16 bits; recibió soporte para EVGA (en los adaptadores Wonder 480 y Wonder 800+) y SVGA (en Wonder 16). En 1989, ATI redujo los precios de la línea Wonder 16 y agregó un conector VESA para poder conectar dos adaptadores entre sí; podemos decir que estas fueron las primeras fantasías sobre paquetes de varios dispositivos que aparecerán en el mercado mucho más tarde.

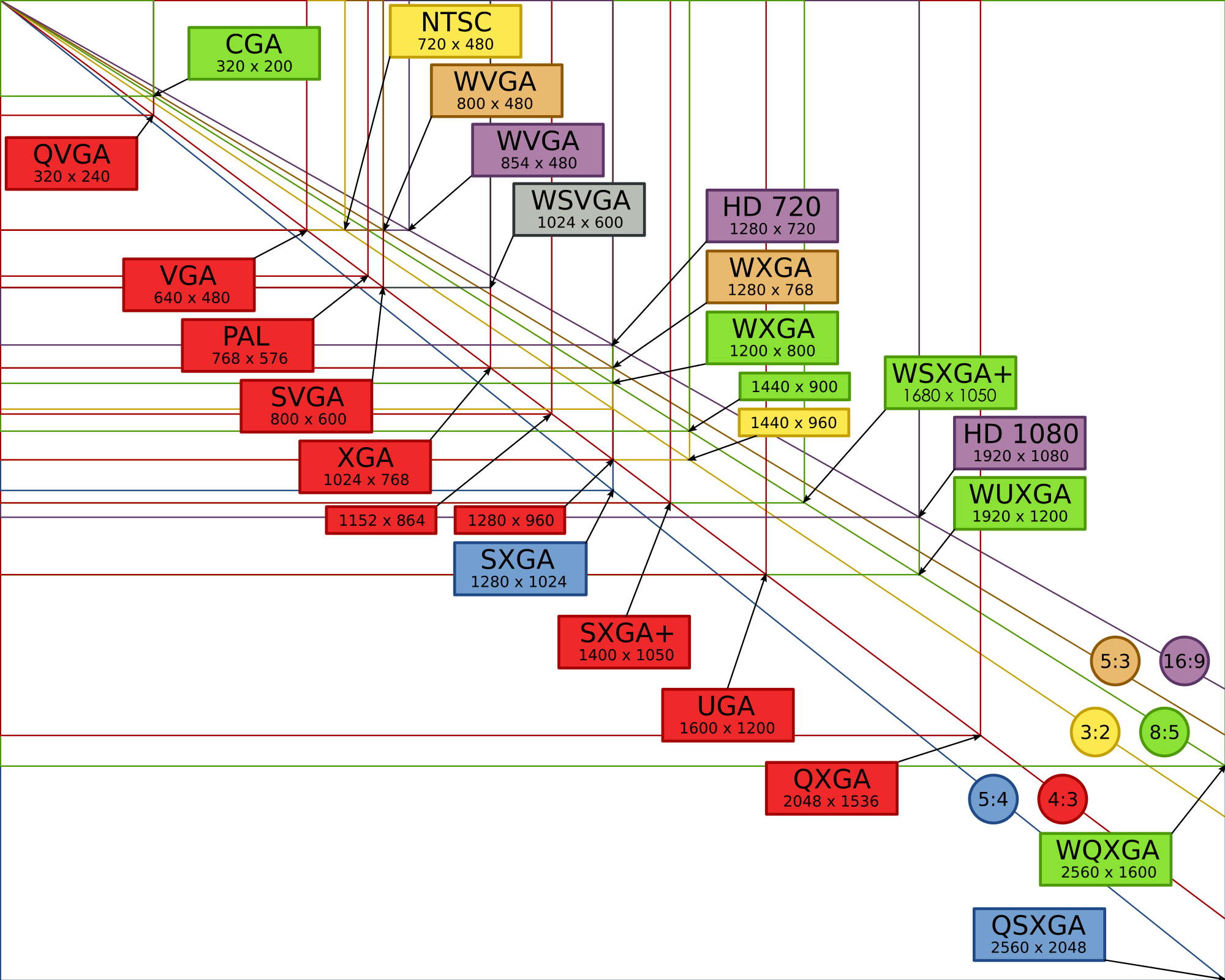

Debido a la proliferación de un mercado con innumerables formatos y fabricantes, se requirió una organización dedicada para regularlos y desarrollar estándares clave para los actores del mercado. En 1988, VESA (Video Electronics Standard Association) fue fundada gracias a los esfuerzos de seis fabricantes clave, que se hicieron cargo de la centralización de estándares y formatos de resolución, así como de la paleta de colores de los adaptadores gráficos. El primer formato fue SVGA (800x600 píxeles), que ya se usaba en las tarjetas Ati Wonder 800. Luego hubo más, y algunas (incluidas HGC y HGC +) se usaron durante décadas.

El liderazgo tecnológico de ATi continuó a principios de la década de 1990. En 1991, Wonder XL salió a la venta, el primer adaptador de gráficos con soporte para 32 mil colores y soporte para resolución de 800x600 a una frecuencia de actualización de 60 Hz. Esto se logró gracias al uso del convertidor Sierra RAMDAC. Además, Wonder XL se convirtió en el primer adaptador con 1 MB de memoria de video integrada.

En mayo del mismo año, ATI presentó Mach8, el primer producto de una nueva línea de Mach para manejar operaciones 2D simples como dibujo de líneas, relleno de color y mapas de bits. Mach8 estaba disponible para su compra como un chip (para la integración posterior, por ejemplo, en sistemas comerciales con formato OEM) y como una placa completa. Ahora, a muchos les resultará extraño lanzar un adaptador separado para tales cosas, pero hace 30 años, muchos cálculos especiales todavía estaban sobre los hombros del procesador central, mientras que los adaptadores de gráficos estaban pensados para una gama limitada de tareas.

Sin embargo, esta forma de cosas no duró mucho - tras la interesante VGA Stereo F / X, simbiosis de un adaptador gráfico y una tarjeta Sound Blaster para emular un códec en formato mono sobre la marcha, el líder de la industria presentó un producto para trabajar con gráficos 2D y 3D - VGA Wonder GT. Al combinar las capacidades de Mach8 y Wonder Ati fueron los primeros en resolver el problema de la necesidad de un adaptador adicional para trabajar con diferentes tipos de tareas. El lanzamiento del popular sistema operativo Windows 3.0, que por primera vez se centró en una amplia gama de tareas al trabajar con gráficos 2D, contribuyó al éxito significativo de los nuevos productos. Wonder GT tenía una demanda entre los integradores de sistemas, lo que tuvo un efecto beneficioso en las ganancias de la empresa: en 1991, la facturación de ATI superó los $ 100 millones. El futuro prometía ser brillante, pero la competencia en el mercado nunca se debilitó: nuevos desafíos aguardaban a los líderes.

1992-1995. Desarrollo OpenGL. El segundo boom en el mercado de las tarjetas gráficas. Nuevas fronteras en 2D y 3D

En enero de 1992, Silicon Graphics Inc. introdujo la primera interfaz de programación OpenGL 1.0 multiplataforma, compatible con gráficos 2D y 3D.

El futuro estándar abierto se basa en la biblioteca patentada IRIS GL (Biblioteca gráfica del sistema de imágenes de trama integrado, biblioteca del sistema integrado para procesar gráficos de trama). Al darse cuenta de que muchas empresas introducirán pronto sus bibliotecas de este tipo en el mercado, SGI decidió hacer de OpenGL un estándar abierto, compatible con cualquier plataforma del mercado. La popularidad de este enfoque fue difícil de sobrestimar: todo el mercado llamó la atención sobre OpenGL.

Inicialmente, Silicon Graphics tenía como objetivo el mercado profesional de UNIX, planificando tareas específicas para una futura biblioteca abierta, pero gracias a su disponibilidad para desarrolladores y entusiastas, OpenGL rápidamente tomó un lugar en el emergente mercado de juegos 3D.

Sin embargo, no todos los principales actores del mercado acogieron con satisfacción este enfoque de SGI. Casi al mismo tiempo, Microsoft estaba desarrollando su propia biblioteca de software Direct3D y no tenía prisa por integrar el soporte OpenGL en el sistema operativo Windows.

Direct3D fue criticado abiertamente por el famoso autor de Doom John Carmack, quien personalmente portó Quake a OpenGL para Windows, enfatizando las ventajas del código simple y comprensible de una biblioteca abierta en el contexto de una versión compleja y "basura" de Microsoft.

John Carmack

Pero la posición de Microsoft se mantuvo sin cambios, y después del lanzamiento de Windows 95, la compañía se negó a licenciar el controlador OpenGL MCD, gracias a lo cual el usuario podía decidir de forma independiente a través de qué biblioteca lanzar una aplicación o un nuevo juego. SGI encontró una laguna al lanzar un controlador de controlador de cliente instalable (ICD), que, además de la rasterización OpenGL, recibió soporte para procesar efectos de iluminación.

El explosivo crecimiento de la popularidad de OpenGL llevó a que la solución de SGI se hiciera popular en el segmento de las estaciones de trabajo, lo que obligó a Microsoft a dedicar todos los recursos posibles para crear su biblioteca propietaria en el menor tiempo posible. La base para la futura API la proporcionó el estudio RenderMorphics, adquirido en febrero de 1995, cuya biblioteca de software Reality Lab formó los principios básicos de Direct3D.

El renacimiento del mercado de las tarjetas de video. La ola de fusiones y adquisiciones

Pero volvamos un poco al pasado. En 1993, el mercado de las tarjetas de video experimentó un renacimiento y muchas empresas nuevas y prometedoras llamaron la atención del público. Uno de ellos fue NVidia, fundada por Jensen Huang, Curtis Prahm y Chris Malakhovsky en enero de 1993. Huang, que había trabajado como ingeniero de software en LSI, había tenido durante mucho tiempo la idea de iniciar una empresa de tarjetas gráficas, y sus colegas de Sun Microsystems acababan de trabajar en la arquitectura de gráficos GX. Al unir fuerzas y recaudar $ 40,000, los tres entusiastas lanzaron una empresa que estaba destinada a desempeñar un papel clave en la industria.

Jensen huang

Sin embargo, en esos años, nadie se atrevió a mirar hacia el futuro: el mercado estaba cambiando rápidamente, aparecían nuevas API y tecnologías patentadas casi todos los meses, y era obvio que no todos sobrevivirían en el turbulento ciclo de la competencia. Muchas de las empresas que entraron en la carrera de armas gráficas a finales de la década de 1980 se vieron obligadas a declararse en quiebra, incluidas Tamerack, Gemini Technology, Genoa Systems y Hualon, mientras que Headland Technology fue adquirida por SPEA y Acer, Motorola y Acumos pasaron a ser propiedad. Cirrus Logic.

Como habrás adivinado, ATI se destacó en este grupo de fusiones y adquisiciones. Los canadienses continuaron trabajando duro y produciendo productos innovadores sin importar qué, incluso si se volviera mucho más difícil.

En noviembre de 1993, ATI presentó la tarjeta de captura de video VideoIt. que se basó en el chip decodificador 68890, capaz de grabar una señal de video en una resolución de 320x240 a 15 cuadros por segundo o 160x120 a 30 cuadros por segundo. Gracias a la integración del chip Intel i750Pd VCP, el propietario de la novedad pudo realizar la compresión-descompresión de la señal de video en tiempo real, lo que resultó especialmente útil cuando se trabaja con grandes cantidades de datos. VideoIt! A los primeros del mercado se les enseñó a utilizar el bus central para comunicarse con el acelerador de gráficos, y no se necesitaron cables ni conectores como antes.

Problemas de ATI y éxitos de S3 Graphics

Para ATI, 1994 fue una prueba real: debido a una competencia seria, la compañía sufrió una pérdida de $ 4.7 millones. La principal causa de problemas para los desarrolladores canadienses fue el éxito de S3 Graphics. El acelerador de gráficos S3 Vision 968 y el adaptador Trio64 han asegurado una docena de importantes contratos OEM para la empresa estadounidense con líderes del mercado como Dell, HP y Compaq. ¿Cuál fue el motivo de tanta popularidad? Un nivel de unificación sin precedentes: el chip gráfico Trio64 ensambló un convertidor de digital a analógico (DAC), un sintetizador de frecuencia y un controlador de gráficos bajo una sola cubierta. New from S3 usó un framebuffer agrupado y superposición de video de hardware compatible (implementado mediante la asignación de una parte de la memoria de video durante el renderizado).La gran cantidad de ventajas y la ausencia de deficiencias obvias del chip Trio64 y su compañero Trio32 de 32 bits han llevado a la aparición de muchas opciones para versiones asociadas de placas basadas en ellos. Diamond, ELSA, Sparkle, STB, Orchid, Hercules y Number Nine ofrecieron sus soluciones. Las variaciones iban desde adaptadores básicos basados en VirGe por $ 169, hasta el ultrapotente Diamond Stealth64 con 4 MB de memoria de video por $ 569.

En marzo de 1995, ATI regresó al gran juego con un montón de innovaciones con la introducción de Mach64, el primer acelerador de gráficos de 64 bits en el mercado y el primero en ejecutarse en sistemas PC y Mac. Junto con el popular Trio 958, Mach64 proporcionó capacidades de video aceleradas por hardware. Mach64 abrió el camino para que ATI ingresara al mercado profesional: las primeras soluciones de los canadienses en este sector fueron los aceleradores 3D Pro Turbo y 3DProTurbo + PC2TV. Se ofrecieron nuevos artículos a un precio de $ 899 por hasta 4 MB de memoria de video.

Otro importante recién llegado al mercado de los aceleradores de gráficos es la nueva tecnología 3Dlabs. La dirección prioritaria para la joven empresa fue el lanzamiento de aceleradores de gráficos de alta gama para el mercado profesional: Fujitsu Sapphire2SX con 4 MB de memoria de video se ofreció a un precio de $ 1600, y ELSA Gloria 8 con 8 MB de memoria a bordo costó la increíble cantidad de $ 2600 para esos años. 3Dlabs intentó ingresar al mercado de gráficos para juegos masivos con la Gaming Glint 300SX, pero el alto precio y solo 1 MB de memoria de video no le dieron popularidad al adaptador.

Otras empresas también presentaron sus productos al mercado de consumo. Trident, un proveedor OEM de soluciones gráficas 2D, ha presentado el chip 9280, que tiene todos los beneficios del Trio64 a un precio asequible de $ 170 a $ 200. Al mismo tiempo, salieron a la venta el Power Player 9130 de Weitek y el ProMotion 6410 de Alliance Semiconductor, lo que proporcionó una excelente fluidez durante la reproducción de video.

NV1: debut de NVidia y áreas problemáticas

En mayo de 1995, NVIDIA se unió a los recién llegados, presentando su primer acelerador de gráficos con el nombre simbólico NV1. El producto fue el primero en el mercado comercial en combinar las capacidades de renderizado 3D, aceleración de video por hardware y una interfaz gráfica. El éxito comercial restringido no molestó a la joven empresa de ninguna manera: Jen-Hsun Huang y sus colegas eran muy conscientes de que sería muy difícil “disparar” en un mercado donde se presentan nuevas soluciones todos los meses. Pero las ganancias de la venta de NV1 fueron suficientes para mantener a flote la empresa y proporcionar incentivos para seguir trabajando.

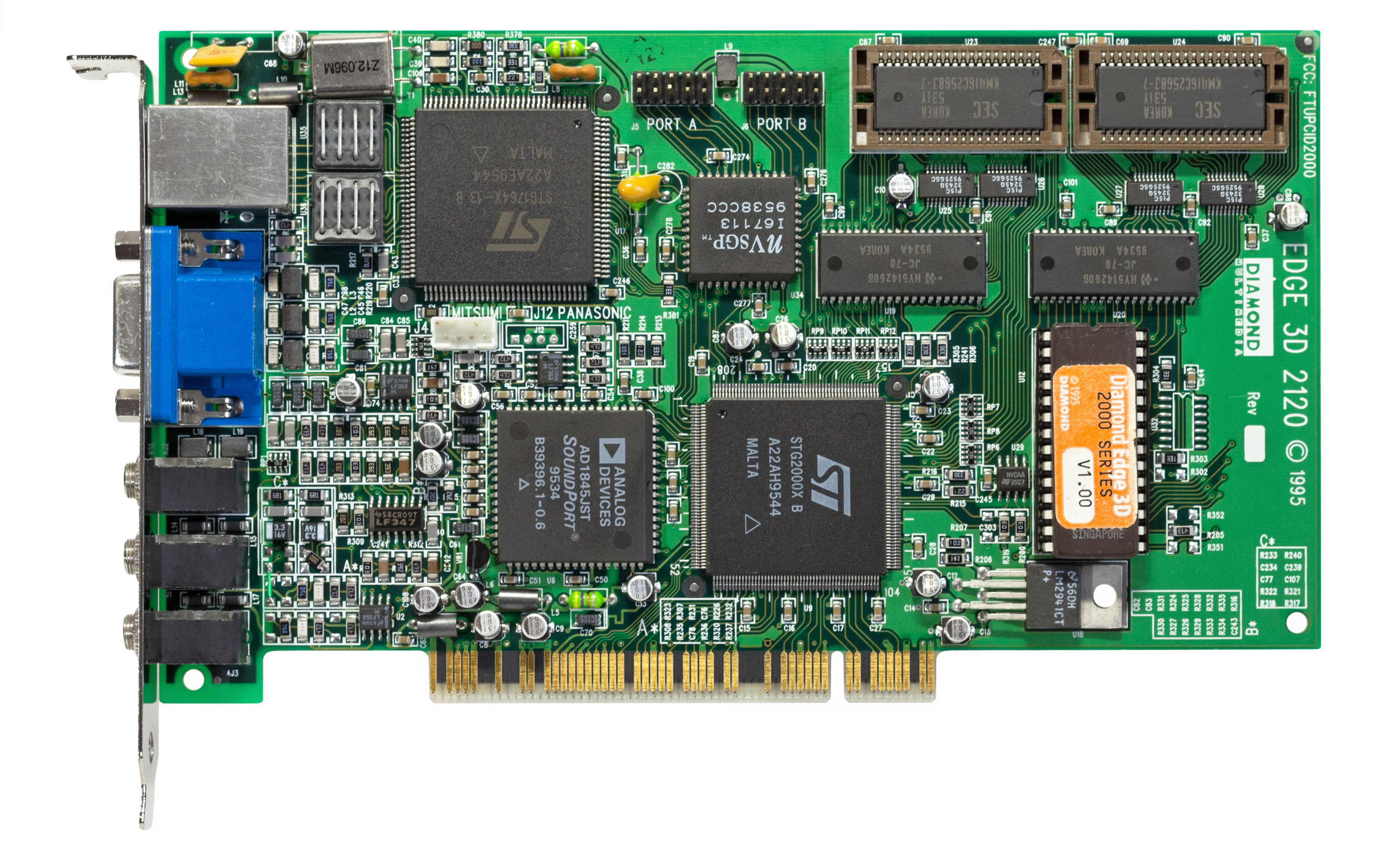

Diamante EDGE 3D 2120 (NV1)

ST Microelectronics estaba a cargo de la producción de chips basados en la tecnología de proceso de 500 nm, pero desafortunadamente para Nvidia, solo unos meses después de la introducción de soluciones asociadas basadas en NV1 (por ejemplo, Diamond Edge 3D), Microsoft presentó la primera versión de la tan esperada API de gráficos DirectX 1.0. "¡Finalmente!" - exclamaron jugadores de todo el mundo, pero los fabricantes de aceleradores de gráficos no compartían ese entusiasmo.

La característica principal de DirectX son los polígonos triangulares. Mucha gente cree erróneamente que los famosos triángulos siempre han existido, pero de hecho esto es una ilusión. Los ingenieros de Nvidia incluyeron el mapeo de texturas cuadráticas en su primer producto (en lugar de triángulos-polígonos había cuadrados), por lo que las aplicaciones y los primeros juegos con soporte DirectX causaron muchos problemas de compatibilidad para los propietarios de NV1. Para resolver el problema, Nvidia incluyó un controlador en el controlador para convertir texturas cuadradas en triangulares, pero el rendimiento en este formato dejaba mucho que desear.

La mayoría de los juegos con soporte de mapeo de texturas cuadráticas fueron portados desde la consola Sega Saturn. Nvidia consideró estos proyectos tan importantes que colocaron dos puertos de la nueva consola en el modelo NV1 de 4 MB, conectados a la tarjeta mediante conectores de cinta. Cuando salió a la venta (septiembre de 1995), el primer producto de Nvidia costó a los clientes 450 dólares.

Cuando se lanzó la API de Microsoft, la mayoría de los fabricantes de aceleradores de gráficos dependían en gran medida de las soluciones patentadas de otras empresas; cuando los desarrolladores de la empresa de Bill Gates estaban empezando a trabajar en su propia biblioteca de gráficos, ya había muchas API en el mercado, como S3d (S3), Matrox Simple Interface, Creative Biblioteca de gráficos, interfaz C (ATI) y SGL (PowerVR), y más tarde incluyó NVLIB (Nvidia), RRedline (Rendition) y el famoso Glide. Esta diversidad complicó enormemente la vida de los desarrolladores del nuevo hardware, ya que las API eran incompatibles entre sí y los diferentes juegos admitían diferentes bibliotecas. El lanzamiento de DirectX puso fin a todas las soluciones de terceros, porque el uso de otras API patentadas en juegos para Windows simplemente no tenía sentido.

Pero no podemos decir que el nuevo producto de Microsoft careciera de fallas graves. Después de que se presentó DirectX SDK, muchos fabricantes de aceleradores de gráficos han perdido la capacidad de controlar los recursos de hardware de las tarjetas de video al reproducir video digital. Numerosos problemas de controladores en el Windows 95 recientemente lanzado enojaron a los usuarios acostumbrados al funcionamiento estable de Windows 3.1. Con el tiempo, todos los problemas se resolvieron, pero la principal batalla por el mercado estaba por delante: ATI, que se había tomado un descanso, se estaba preparando para conquistar el universo de los juegos tridimensionales con una nueva línea de 3D Rage.

ATI Rage - 3D Rage

La demostración del nuevo acelerador de gráficos tuvo lugar en la exposición de Los Ángeles E3 1995. Los ingenieros de ATI han combinado las ventajas del chip Mach 64 (y sus sobresalientes capacidades de gráficos 2D) con un nuevo chip de procesamiento 3D, aprovechando al máximo los diseños anteriores. El primer acelerador 3D ATI 3D Rage (también conocido como Mach 64 GT) entró en el mercado en noviembre de 1995.

ATI 3D Rage

Como en el caso de Nvidia, los ingenieros tuvieron que enfrentarse a muchos problemas: las últimas revisiones de DirectX 1.0 causaron numerosos problemas asociados con la falta de un búfer profundo. La tarjeta tenía solo 2 MB de RAM EDO, por lo que las aplicaciones y juegos 3D se lanzaron con una resolución de no más de 640x480 a color de 16 bits o 400x300 a color de 32 bits, mientras que en el modo 2D la resolución de la pantalla era mucho mayor, hasta 1280x1024. Los intentos de ejecutar el juego en color de 32 bits a 640x480 generalmente producían artefactos de color en la pantalla, y el rendimiento de juego de 3D Rage no fue sobresaliente. La única ventaja indiscutible de la novedad fue la capacidad de reproducir archivos de video en formato MPEG en modo de pantalla completa.

ATI trabajó en errores y rediseñó el chip con el lanzamiento de Rage II en septiembre de 1996. Después de corregir las fallas de hardware y agregar soporte para el códec MPEG2, los ingenieros, por alguna razón, no pensaron en la necesidad de aumentar el tamaño de la memoria: los primeros modelos aún tenían 2 MB de memoria de video ridícula a bordo, lo que inevitablemente afectaba el rendimiento al procesar geometría y perspectiva. El defecto se corrigió en revisiones posteriores del adaptador; por ejemplo, en Rage II + DVD y 3D Xpression +, el búfer de memoria aumentó a 8 MB.

Pero la guerra por el mercado 3D recién comenzaba, ya que tres nuevas compañías estaban preparando sus productos para los últimos juegos: Rendition, VideoLogic y 3dfx Interactive. Fue este último quien logró presentar un chip gráfico en el menor tiempo posible, superando significativamente a todos los competidores y comenzando una nueva era en gráficos 3D -Gráficos 3Dfx Voodoo .

1996-1999. La era de 3Dfx. La mejor puesta en marcha de gráficos de la historia. La última etapa de gran competencia por el mercado

La increíble historia de 3Dfx se ha convertido en la personificación de un libro de texto de una startup que simboliza tanto un éxito increíble como ganancias vertiginosas, así como la incompetencia de un liderazgo seguro de sí mismo y, como resultado, el colapso y el olvido. Pero el final triste y la amarga experiencia no pueden negar lo obvio: 3Dfx creó por sí solo una revolución gráfica, sorprendiendo a numerosos competidores y estableciendo una nueva barra de rendimiento extraordinariamente alta. Ni antes ni después de este increíble período en la historia del desarrollo de las tarjetas de video, hemos visto nada ni remotamente similar al loco auge de 3Dfx en la segunda mitad de los noventa.

3Dfx Voodoo Graphics fue un adaptador de gráficos destinado exclusivamente a trabajar con gráficos 3D. Se asumió que el comprador de la novedad utilizará otra placa para trabajar con cargas bidimensionales, conectándola a Voodoo a través de un segundo conector VGA.

Este enfoque no confundió a muchos entusiastas, y la solución innovadora atrajo de inmediato a muchos fabricantes asociados que lanzaron sus propias variantes de Voodoo.

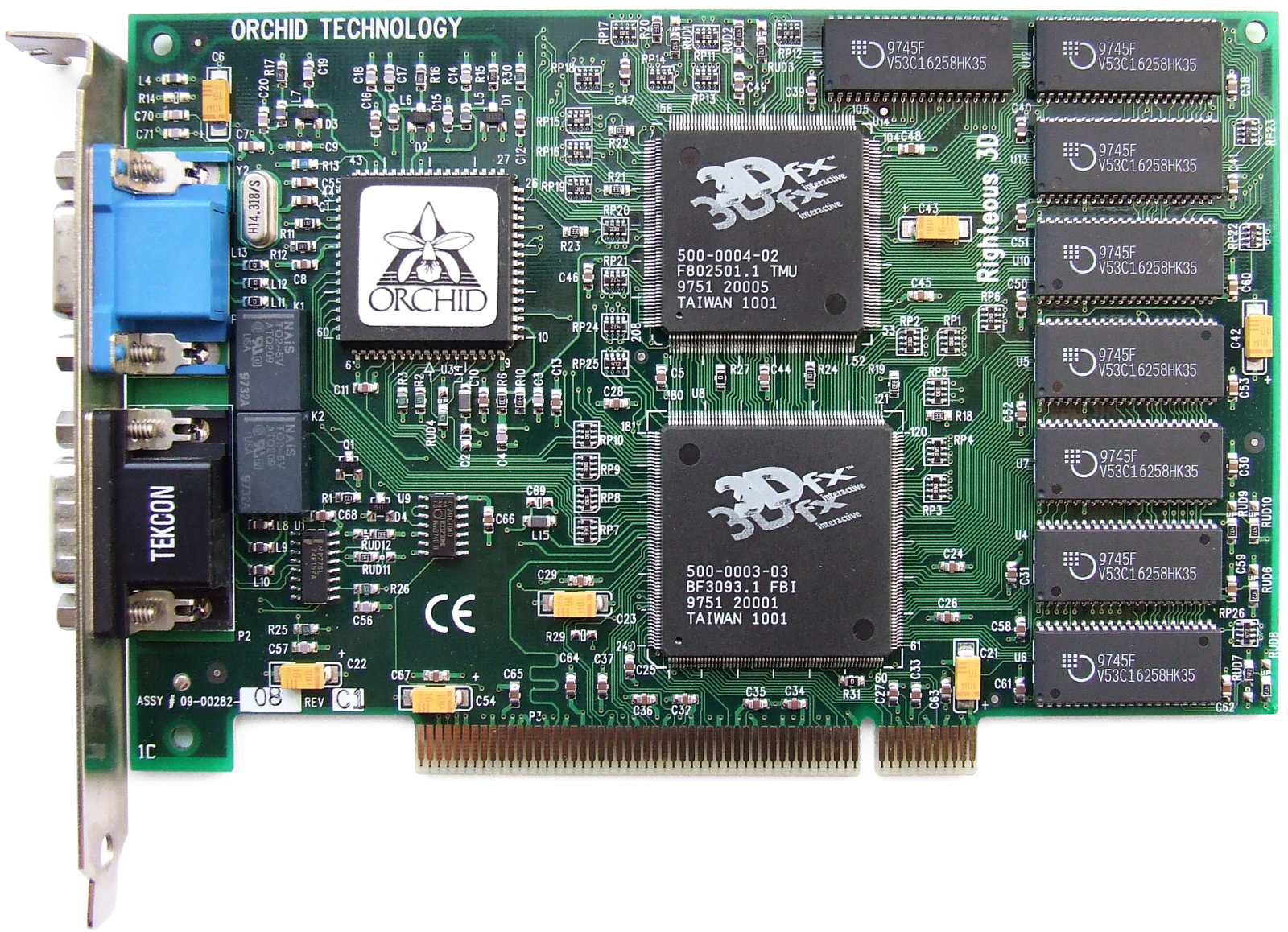

Una de las cartas interesantes basadas en el primer chip 3Dfx fue Orchid Righteous 3D de Orchid Technologies. La marca registrada del adaptador de $ 299 eran relés mecánicos que emiten clics característicos al iniciar aplicaciones o juegos 3D.

Orquídea Justo 3D

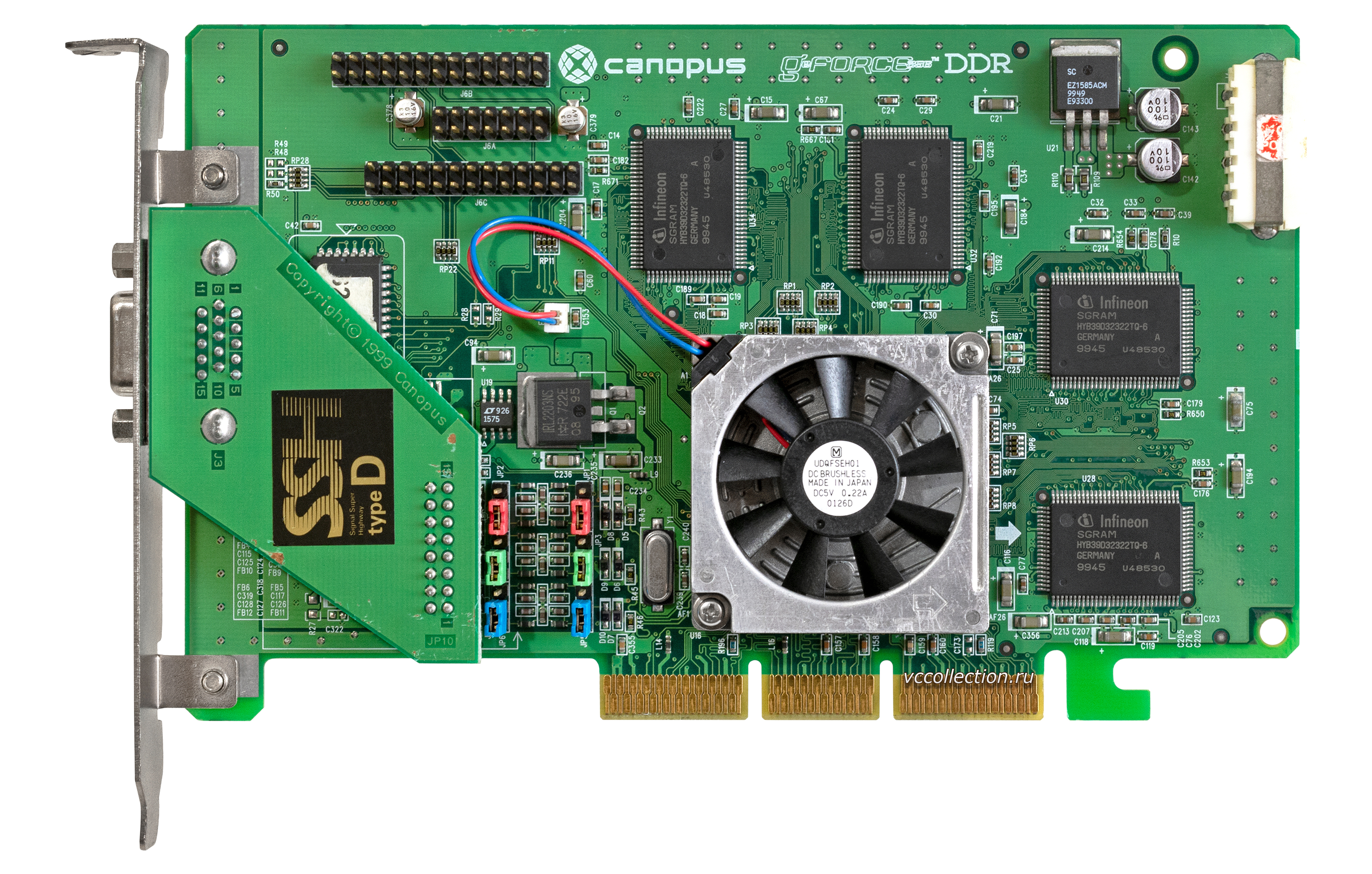

En revisiones posteriores, estos relés fueron reemplazados por componentes de estado sólido y se perdió el antiguo encanto. Junto a Orchid, Diamond Multimedia (Monster 3D), Colormaster (Voodoo Mania), Canopus (Pure3D y Quantum3D), Miro (Hiscore), Skywell (Magic3D), y el más pretencioso de una serie de títulos, 2theMAX Fantasy FX Power 3D, también presentaron sus versiones de la última aceleradora. ... ¡Anteriormente, no dudaron en nombrar tarjetas de video!

Las razones de este entusiasmo en torno al nuevo producto eran obvias: con todas las posibles deficiencias, Voodoo Graphics tenía un rendimiento increíble y su apariencia dejó obsoletos de inmediato muchos otros modelos, especialmente aquellos que solo podían funcionar con gráficos 2D. A pesar de que en 1996 más de la mitad del mercado de aceleradores 3D pertenecía a S3, 3Dfx estaba ganando rápidamente millones de seguidores y, a finales de 1997, la empresa poseía el 85% del mercado. Fue un éxito fenomenal.

Competidores 3Dfx. Rendición y VideoLogic

Los rotundos éxitos del recién llegado de ayer no han eliminado del juego a los competidores que mencionamos anteriormente: VideoLogic y Rendition. VideoLogic creó la tecnología Tiled Deferred Rendering (TBRD), que eliminó la necesidad de almacenar un fotograma antes de Z-buffering. En la etapa final de renderizado, se limpiaron los píxeles ocultos y el procesamiento de la geometría comenzó solo después de que se aplicaron las texturas, las sombras y la iluminación. La tecnología TBRD se basó en el principio de dividir un marco en celdas rectangulares, en las que los polígonos se representaban de forma independiente entre sí. En este caso, se eliminaron los polígonos ubicados fuera del área visible del marco, y el renderizado del resto comenzó solo después de calcular el número total de píxeles. Este enfoque permitió ahorrar una gran cantidad de recursos informáticos en la etapa de renderizado de cuadros,mejorando significativamente el rendimiento general.

La compañía ha lanzado al mercado tres generaciones de chips gráficos de NEC y ST Micro. La primera generación fue un producto exclusivo en computadoras Compaq Presario llamado Midas 3 (Midas 1 y 2 eran prototipos usados en máquinas recreativas). Las versiones posteriores PSX1 y PSX2 se centraron en el mercado OEM.

Los chips de segunda generación formaron la base de Sega Dreamcast, la plataforma japonesa que jugó un papel en el triste destino de 3Dfx. Al mismo tiempo, VideoLogic no tuvo tiempo de ingresar al mercado de consumo de tarjetas gráficas; en el momento del estreno, su modelo Neon 250 se había vuelto obsoleto, perdiendo todas las soluciones de presupuesto, y esto no es sorprendente, porque la novedad llegó a los estantes solo en 1999.

Rendition también se destacó en la innovación gráfica y creó el primer chip gráfico, el Vérité 1000, capaz de manejar no solo gráficos 2D sino también 3D simultáneamente gracias al núcleo del procesador RISC y al uso de canalizaciones de píxeles. El procesador era responsable del procesamiento de polígonos y el mecanismo de las tuberías de renderizado.

Microsoft estaba interesado en este enfoque para crear y procesar imágenes: la compañía usó Vérité 1000 durante el desarrollo de DirectX, pero el acelerador tenía sus propios defectos arquitectónicos. Por ejemplo, solo funcionaba en placas base compatibles con la tecnología de acceso directo a memoria (DMA); los datos se transfirieron a través de él a través del bus PCI. Debido a su bajo costo y una serie de ventajas de software, incluyendo anti-aliasing y aceleración de hardware en Quake de id Software, la tarjeta fue popular hasta el lanzamiento de Voodoo Graphics. El nuevo producto de 3Dfx resultó ser más de 2 veces más productivo y la tecnología DMA perdió rápidamente su popularidad entre los desarrolladores de juegos, enviando al otrora prometedor V1000 al basurero de la historia.

ATI - Race for Voodoo con Rage II y Rage Pro

Mientras tanto, ATI no dejaba de trabajar en nuevas revisiones de Rage. Tras el Rage II en marzo de 1997, se presentó el Rage Pro, la primera tarjeta de video AGP del ATI 3D Engineering Group, formado el día anterior.

Rage Pro con 4 MB de memoria de vídeo a bordo prácticamente igualaba en rendimiento al legendario Voodoo, y la versión en el bus AGP con 8 MB de memoria de vídeo incluso superó al famoso competidor en varios juegos. En la versión Pro de la tarjeta, los ingenieros de ATI han mejorado la corrección de perspectiva y el procesamiento de texturas, así como también han agregado soporte para anti-aliasing de hardware y filtrado trilineal gracias al aumento de caché de 4 KB. Para reducir la dependencia del rendimiento del adaptador del procesador central de la computadora, se soldó un chip separado en la placa para procesar operaciones de punto flotante. Los fanáticos de la multimedia moderna apreciaron la compatibilidad con la aceleración de hardware al reproducir videos desde medios DVD.

La entrada de Rage Pro permitió a ATI mejorar sus finanzas y aumentar su beneficio neto a 47,7 millones de dólares en una facturación total de más de 600 millones de dólares. La mayor parte del éxito financiero del producto provino de contratos OEM, la implementación del chip gráfico en las placas base y el lanzamiento de una variante móvil. La tarjeta, que a menudo se vendía en las variantes Xpert @ Work y Xpert @ Play, tenía muchas configuraciones de 2 a 16 MB de memoria de video para diferentes necesidades y segmentos de mercado.

Una ventaja estratégica importante para el personal de ATI fue la adquisición de Tseng Labs por $ 3 millones, que trabajó en tecnologías para integrar chips RAMDAC en tarjetas gráficas. La empresa estaba desarrollando su propio adaptador de gráficos, pero se enfrentó a problemas técnicos que llevaron a una contraoferta de los líderes del mercado canadiense. Junto con la propiedad intelectual, 40 ingenieros de primer nivel fueron transferidos al personal de ATI e inmediatamente comenzaron a trabajar.

Nuevos competidores. Permedia y RIVA 128

Los profesionales de 3DLabs nunca perdieron la esperanza de captar los intereses de los jugadores. Para ello, se lanzó una serie de productos Permedia, fabricados utilizando la tecnología de proceso Texas Instruments 350 nm. El Permedia original tuvo un rendimiento relativamente bajo, que se corrigió en Permedia NT. La nueva tarjeta tenía un chip Delta separado para procesar polígonos y un algoritmo anti-aliasing, pero al mismo tiempo era caro: hasta $ 600. Cuando la línea Permedia 2 actualizada estuvo lista a fines de 1997, ya no podía competir con los productos de juegos: 3DLabs cambió el marketing y presentó nuevos elementos como tarjetas profesionales para trabajar con aplicaciones 2D y soporte 3D limitado.

Solo un mes después de los últimos estrenos de 3DLabs y ATI, Nvidia está de regreso en el mercado con su RIVA 128, una billetera de jugador altamente competitiva. El precio asequible y el excelente rendimiento de Direct3D aseguraron el reconocimiento universal y el éxito comercial del nuevo producto, lo que permitió a la empresa concluir un contrato con TSMC para la producción de chips para el RIVA 128ZX actualizado. A fines de 1997, dos tarjetas de video exitosas llevaron a Jensen Huang el 24% del mercado, casi todo lo que el todopoderoso 3Dfx no tuvo tiempo de aplastar.

Irónicamente, los caminos entre Nvidia y el líder del mercado ya comenzaron a cruzarse cuando Sega, preparándose para el desarrollo de la nueva consola Dreamcast, firmó varios contratos preliminares con fabricantes de soluciones gráficas. Entre ellos estaban Nvidia (con el diseño del chip NV2) y 3Dfx (con el prototipo Blackbelt). La gerencia de 3Dfx confiaba plenamente en recibir el contrato, pero, para su sorpresa, fue rechazado: los japoneses optaron por no arriesgarse y recurrieron a NEC para el desarrollo, que anteriormente había demostrado ser una colaboración con Nintendo. Representantes de 3Dfx entablaron una demanda contra Sega, acusando a la empresa de intentar malversar desarrollos de propiedad en el transcurso del trabajo en el prototipo - un largo litigio terminó en 1998 con el pago de una indemnización por un monto de $ 10,5 millones a favor de la empresa estadounidense.

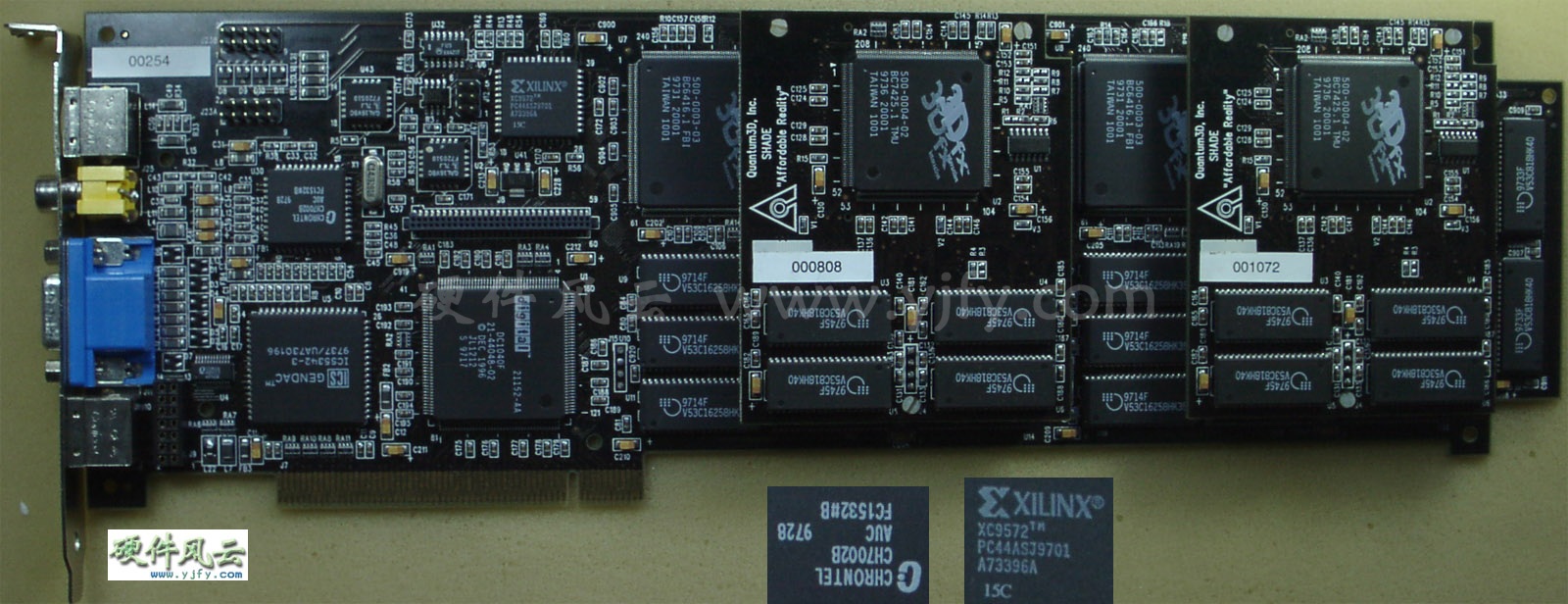

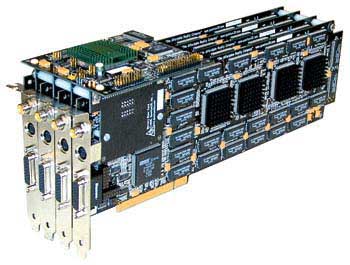

Quantum3D y el primer uso de SLI

Mientras tanto, continuaron, 3Dfx logró adquirir una empresa subsidiaria. Ella fue Quantum3D, que recibió varios contratos lucrativos para el desarrollo de soluciones gráficas profesionales del más alto nivel de SGI y Gemini Technology. Los futuros productos se basaron en el desarrollo innovador de la tecnología 3Dfx - SLI (Scan-Line Interleave) .

La tecnología asumió la posibilidad de usar dos chips gráficos (cada uno con su propio controlador de memoria y búfer) dentro de una placa o conectar dos placas separadas mediante un cable plano especial. Las tarjetas conectadas de manera similar (en el formato de una placa de doble chip o dos separadas) dividieron el procesamiento de imágenes a la mitad. La tecnología SLI brindaba la capacidad de aumentar la resolución de la pantalla de 800x600 a 1024x768 píxeles, pero este lujo no era barato: la Obsidian Pro 100DB-4440 (dos tarjetas emparejadas con chips Amethyst) se ofrecía a un precio de $ 2500, mientras que la placa de doble chip 100SB-4440 / 4440V le habría costado al comprador a $ 1895.

Obsidian Pro 100DB-4440

Las soluciones especializadas, sin embargo, no distrajeron de ninguna manera a los líderes del mercado del desarrollo de nuevas tarjetas de la serie Voodoo.

3Dfx Voodoo Rush. Prisa, presupuesto y frustración

En el verano de 1997, 3Dfx se hizo público y trató de aprovechar el éxito abrumador de Voodoo lanzando Voodoo Rush, una tarjeta que funciona con gráficos 2D y 3D simultáneamente y que ya no requiere un segundo adaptador. Inicialmente, se suponía que estaba basado en el nuevo chip Rampage, pero debido a problemas técnicos, su lanzamiento se retrasó y Rush se basó en una versión simplificada del Voodoo original. Para acomodar los dos tipos de cargas de trabajo de gráficos, la placa contenía dos chips: el SST-1 era responsable de procesar juegos 3D utilizando la API Glide, mientras que el chip más mediocre de Alliance o Macronix era responsable de otras aplicaciones y juegos 2D y 3D. Debido a la desincronización, los chips funcionaron en diferentes frecuencias (50 y 72 MHz), provocando artefactos aleatorios en la pantalla y confusión entre los propietarios.

Fiebre del vudú

Además, Voodoo Rush tenía un búfer de memoria de video común, que ambos chips usaban simultáneamente. La resolución máxima de pantalla sufría esto: era solo la mitad de 1024x768 (512x384 píxeles) y las bajas frecuencias de RAMDAC no permitían proporcionar los 60 Hz deseados en la actualización de la pantalla.

Rendición V2100 y V2200. Saliendo del mercado

En medio de grandes problemas con 3Dfx, Rendition ha hecho otro intento de sorprender gratamente al mercado masivo con Rendition V2100 y V2200. Las novedades entraron al mercado poco después del estreno de Voodoo Rush, pero, para decepción de los entusiastas, no pudieron competir ni siquiera con el Voodoo simplificado. Las tarjetas gráficas no reclamadas obligaron a Rendition a ser la primera de muchas en abandonar el mercado de tarjetas gráficas.

Como resultado, muchos de los proyectos de la compañía permanecieron en la etapa de prototipo, uno de ellos fue una versión modificada del V2100 / V2200 con un procesador geométrico Fujitsu FXG-1 (en un formato de doble chip). Sin embargo, también hubo una variante de un solo chip con FXG-1, que pasó a la historia como el producto con el nombre más exquisito de la historia: Hercules Thrilled Conspiracy. Junto con otros desarrollos (por ejemplo, los chips V3300 y 4400E), la empresa se vendió a Micron por 93 millones de dólares en septiembre de 1998.

Economía agresiva. Batalla por el segmento de presupuesto

El constante crecimiento de la productividad y la aparición de nuevas ventajas técnicas hicieron que a los fabricantes de segundo nivel les resultara extremadamente difícil competir con las soluciones de ATI, Nvidia y 3Dfx, que ocupaban no solo el nicho de entusiastas y profesionales, sino también el segmento "popular" del mercado de adaptadores por debajo de los 200 dólares.

Matrox presentó su tarjeta gráfica Mistique a un delicioso precio de $ 120 a $ 150, pero debido a la falta de compatibilidad con OpenGL, el nuevo producto cayó inmediatamente en la categoría de los desvalidos. S3 comenzó a vender la nueva línea ViRGE, con la presencia de la más amplia gama de modelos: la versión móvil del adaptador con administración dinámica de energía (ViGRE / MX) y una versión especial del ViRGE principal con soporte para salida de TV, conector S-Video y reproducción de DVD (ViRGE / GX2). Dos adaptadores principales diseñados para luchar por el mercado económico (modelos ViRGE, VIRGE DX y ViRGE GX) cuestan desde $ 120 para el más joven hasta $ 200 para el más viejo en el momento del lanzamiento.

Es difícil de imaginar, pero la categoría de ultra presupuesto también fue un lugar de feroz competencia. Laguna3D de CirrusLogic, los modelos 9750/9850 de Trident y SiS 6326 compitieron por las carteras de usuarios dispuestos a pagar no más de $ 99 por un acelerador de gráficos. Todas estas tarjetas eran compromisos con un mínimo de características.

Después del lanzamiento de Laguna3D, CirrusLogic abandonó el mercado: gráficos 3D de baja calidad, rendimiento mediocre (e inconsistente), así como competidores mucho más interesantes (el mismo ViRGE, que cuesta un poco más) no dejaron a los veteranos de la industria la oportunidad de sobrevivir. Las únicas fuentes de ingresos para CirrusLogic fueron la venta de tarjetas gráficas antediluvianas de 16 bits por 50 dólares, interesante solo para los clientes más económicos.

Trident también vio potencial en el segmento de mercado "por debajo del promedio": en mayo de 1997, se lanzó el 3D Image 9750, y un poco más tarde, el 9850 salió con soporte para un bus AGP de doble canal. Después de solucionar muchos de los problemas del bus PCI del 9750, el 9850 sufrió un manejo de textura mediocre y recibió pocos elogios.

Entre las tarjetas vendidas por casi nada, la más exitosa fue la SiS 6326, presentada en junio de 1997 por menos de $ 50. Con una buena calidad de imagen y un rendimiento relativamente alto, el 6326 vendió más de 8 millones de unidades en 1998. Pero a finales de los 90, el mundo de los entusiastas se vio sacudido por una startup llena de promesas serias: BitBoys.

BitBoys: chicos atrevidos en un fabuloso mundo 3D

BitBoys se anunció en junio de 1997 con el anuncio del intrigante proyecto Pyramid3D. El revolucionario chip gráfico fue desarrollado conjuntamente por la propia startup con Silicon VLSI Solutions Oy y TriTech. Desafortunadamente para los entusiastas, aparte de las palabras en voz alta en las presentaciones de Pyramid3D, nunca apareció en ninguna parte, y la compañía TriTech fue condenada por apropiarse de la patente de otra persona para un chip de audio, razón por la cual más tarde quebró y cerró.

Pero BitBoys no dejó de funcionar y anunció un segundo proyecto llamado Glaze3D. En SIGGRAPH99 se mostró al público un realismo increíble, el mejor rendimiento de su clase y una gran cantidad de las últimas tecnologías. El prototipo funcional del adaptador de gráficos utilizó RAMBUS y 9 MB de memoria de video DRAM de Infineon.

Por desgracia, al igual que la primera vez, los problemas de hardware y las transferencias llevaron al hecho de que la revolución esperada no se repitió.

Captura de pantalla promocional diseñada para enfatizar el realismo que se suponía que debían lograr las tarjetas Glaze3D

Mucho más tarde, el proyecto pasó a llamarse Axe nuevamente, y los juegos con soporte DirectX 8.1 fueron elegidos como campo de competencia; el prototipo incluso logró obtener el nombre oficial Avalanche3D y prometió "hacer estallar" el mercado en 2001, pero no Ocurrió. En la última etapa de desarrollo, Axe cambió a Hammer, al que se le prometió soporte para DirectX 9.0. La historia de la construcción a largo plazo más pretenciosa en la historia de los gráficos terminó con la quiebra de Infineon, tras lo cual BitBoys abandonó el "proyecto soñado" y pasó al segmento de gráficos móviles. Ahora volvamos al acogedor 1998.

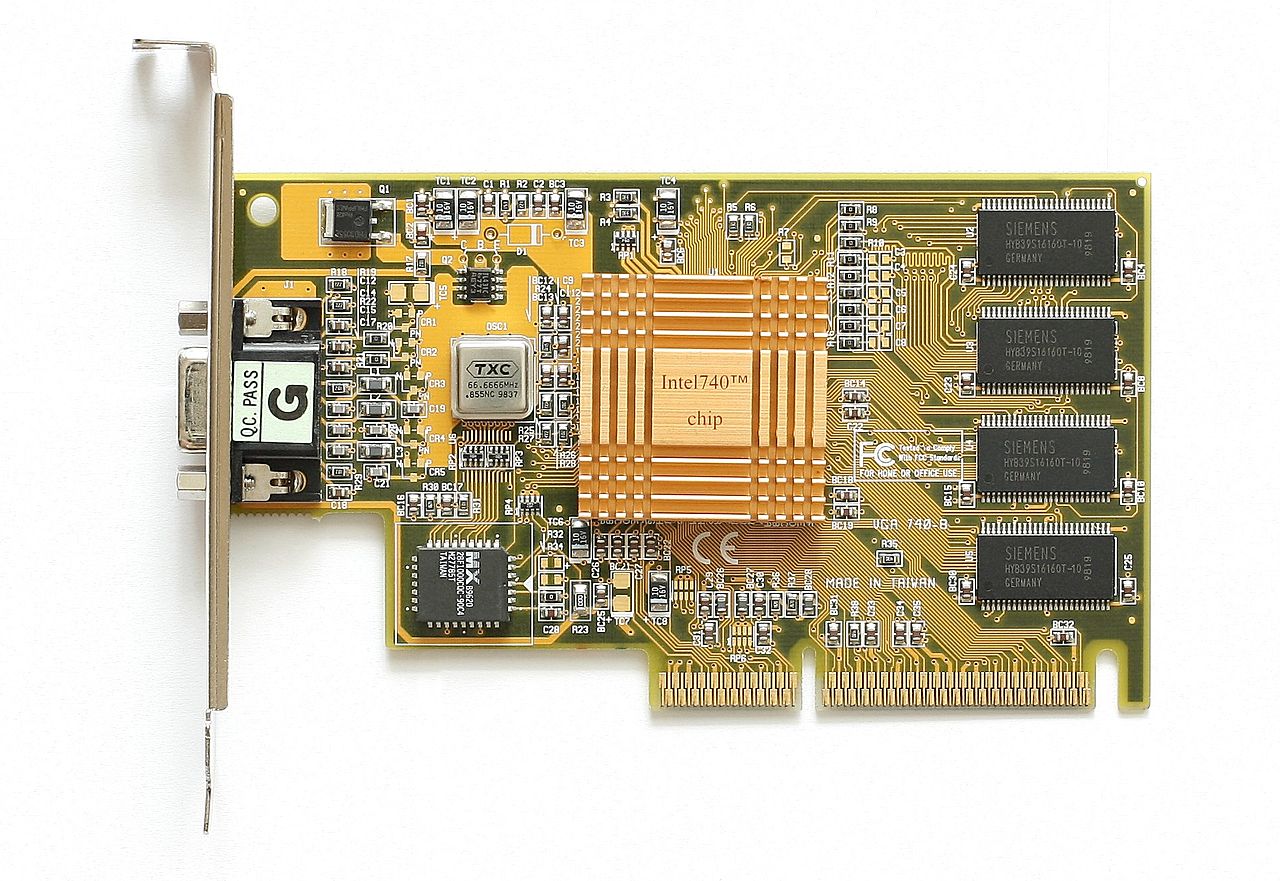

Intel i740: gran fracaso de los grandes profesionales

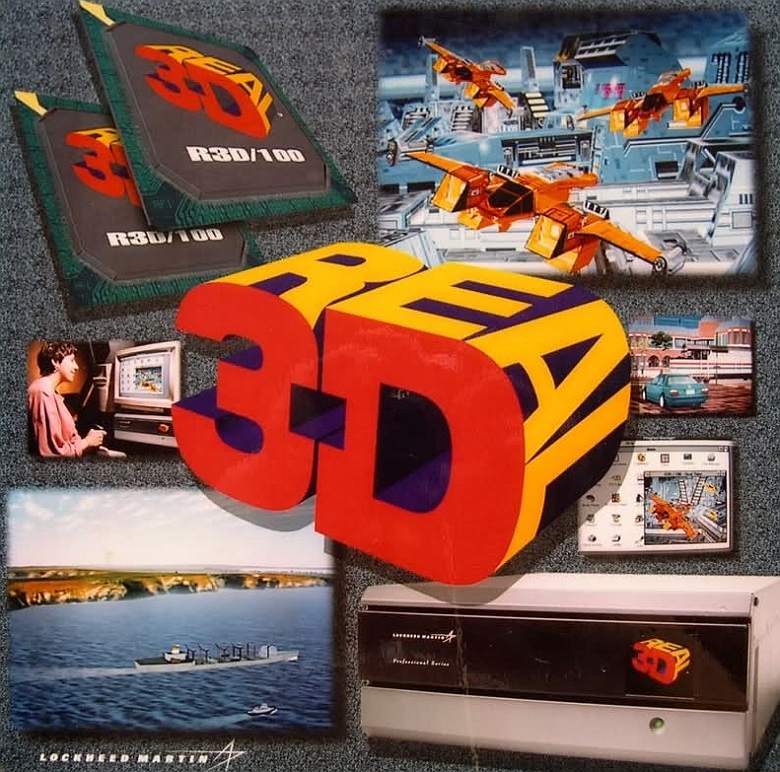

Intel lanzó su primera (y hasta ahora la última) tarjeta gráfica para juegos en 3D llamada Intel i740 en enero de 1998. El proyecto tenía una historia interesante, ya que tenía sus raíces en un programa de simulación de vuelos espaciales que la NASA y General Electric crearon para la famosa serie de misiones lunares Apolo. Posteriormente, los desarrollos fueron vendidos a Martin Marietta, empresa que luego pasó a formar parte del gigante de la defensa Lockheed (y así apareció Lockheed-Martin). Lockheed-Martin sobre la base del proyecto ha creado una línea de dispositivos profesionales Read3D, que consta de dos modelos de adaptadores gráficos: Real3D / 100 y Real3D / Pro-1000. Irónicamente, a pesar del origen militar de los dispositivos, una de las aplicaciones de tecnologías sobresalientes se ha convertido ... en una máquina recreativa Sega que utiliza dos placas Pro-1000.

Un poco más tarde, Lockheed-Martin anunció el inicio del Proyecto Aurora, una colaboración con Intel y Chips and Technologies. Un mes antes del lanzamiento del i740, Intel adquirió el 20% del proyecto Real3D y, en julio de 1997, había adquirido por completo Chips and Technologies.

Una característica clave del proyecto Real3D fue el uso de dos chips separados para procesar texturas y gráficos: Intel los combinó para crear el i740. El adaptador utilizó un enfoque original para el almacenamiento en búfer de datos: el contenido del búfer de tramas y las texturas se cargaron directamente en la RAM de la computadora a través del bus AGP. En las versiones asociadas del i740, el acceso a la RAM se produjo solo si el búfer del adaptador estaba completamente lleno o muy segmentado. El mismo enfoque se usa a menudo hoy en día: cuando la memoria a bordo de la tarjeta de video se agota, el sistema aumenta el búfer usando RAM libre.

Pero en un momento en que los búferes se contaban en megabytes y las texturas aún no estaban infladas a tamaños indecentes, este enfoque podría parecer al menos extraño.

Para reducir las posibles latencias al trabajar con el bus, Intel utilizó una de sus características: el acceso directo al búfer de memoria (Direct Memory Execute o DiME). Este método también se denominó texturizado AGP y permitía utilizar la RAM de la computadora para mapear texturas, procesándolas de forma selectiva. El rendimiento medio junto con una calidad de imagen mediocre permitió que el i740 alcanzara el nivel de las tarjetas del año pasado en su segmento de precios.

Para el modelo con 4 MB de memoria de video pidieron $ 119 y la versión con 8 MB por $ 149. Además, además de la versión básica de Intel, solo dos opciones de socios vieron la luz: Real3D StarFighter y Diamond Stealth II G450.

Contando con el éxito, Intel comenzó a desarrollar el próximo chip i752, pero ni los fabricantes de equipos originales ni los entusiastas mostraron interés en un adaptador económico que se está quedando seriamente por detrás de las soluciones actuales. Y esto no es sorprendente, porque al mismo tiempo que ViRGE de S3 estaba a la venta, cuya compra complacería mucho más al usuario. La producción de adaptadores se eliminó gradualmente y los chips i752 que ingresaron al mercado se reutilizaron para su uso como soluciones gráficas integradas.

En octubre de 1999, Lockheed-Martin eliminó Real3D y la fuerza laboral adinerada se fue a Intel y ATI.

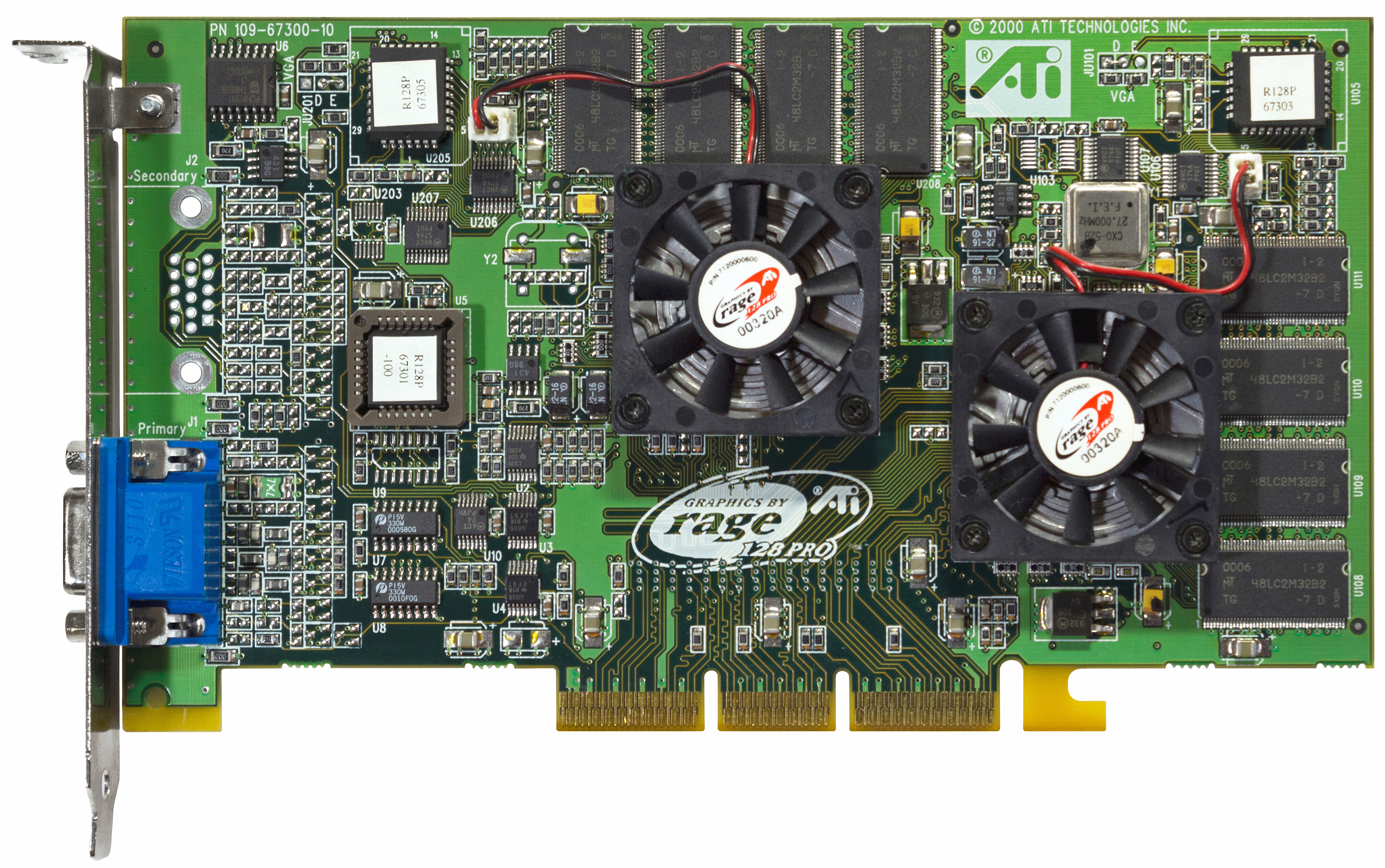

ATI: de vuelta al juego con Rage Pro y Rage 128

ATI se restableció con el Rage Pro Turbo en febrero de 1998, pero esta tarjeta resultó ser solo un cambio de marca del Rage Turbo con ajustes de controlador para obtener resultados sobresalientes en textos sintéticos. Los críticos de algunas publicaciones se sorprendieron gratamente, pero el precio de 449 dólares era muy difícil de justificar. Sin embargo, fue con el Rage Pro Turbo que apareció por primera vez el fenómeno Finewine: los controladores mejoraron gradualmente el rendimiento del adaptador con cada nueva revisión.

ATI hizo un intento mucho más serio de influir en el equilibrio de poder con el lanzamiento de Rage 128 GL y Rage 128 VR en agosto del mismo año. Debido a problemas con los suministros, ATI no pudo garantizar la disponibilidad de modelos en las tiendas casi hasta las vacaciones de invierno, lo que afectó mucho la promoción de nuevos productos. A diferencia de los contratos de OEM, que constantemente aportan importantes beneficios a los canadienses, los entusiastas comunes no pudieron apreciar el nuevo producto debido a la falta de adaptadores en el mercado. Pero había otra razón por la que las ventas de Rage 128 fueron más bajas de lo esperado.

ATI preparó el Rage 128 para un futuro gráfico brillante al equipar el nuevo producto con 32 MB de memoria de video (las variantes con 16 MB se produjeron bajo la marca All-In-Wonder 128), que funcionó en un subsistema rápido y eficiente: en color de 32 bits, el competidor directo de NVidia Riva TNT no tenía no hay posibilidades. Por desgracia, en el momento del lanzamiento del nuevo producto, la mayoría de los juegos y aplicaciones todavía funcionaban en modo de 16 bits, donde el Rage 128 no se destacaba de ninguna manera en el contexto de NVidia y S3 (y en términos de calidad de imagen era incluso inferior a los modelos de Matrox). El público en general no apreció el enfoque de ATI, pero fue entonces cuando los canadienses se adelantaron a su tiempo por primera vez, solo que su enfoque fue apreciado mucho más tarde.

1998 fue un año récord para ATI: con una facturación de $ 1,150 millones, la utilidad neta de la compañía ascendió a unos buenos $ 168,4 millones. La empresa canadiense cerró el año con el 27% del mercado de aceleradores gráficos.

En octubre de 1998, ATI adquirió Chromatic Research por $ 67 millones. La compañía, famosa por sus procesadores multimedia MPACT, era un proveedor de soluciones de TV para PC de Compaq y Gateway, que ofrecía un excelente rendimiento MPEG2, alta calidad de audio y excelente rendimiento 2D. Irónicamente, fue el único inconveniente de MPACT en forma de bajo rendimiento 3D lo que llevó a Chromatic Research al borde de la bancarrota solo 4 años después de su fundación. El tiempo de las soluciones universales se acercaba cada vez más.

3Dfx Voodoo 2 y Voodoo Banshee: fracaso exitoso del líder del mercado

Mientras Intel intentaba ingresar al mercado de adaptadores gráficos, su líder en la persona de 3Dfx presentó Voodoo 2, que se convirtió en un avance tecnológico en varias áreas al mismo tiempo. El nuevo adaptador de gráficos de 3Dfx tenía un diseño único: además del chip central, la placa tenía dos procesadores de textura emparejados, gracias a los cuales la tarjeta no solo era de tres chips, sino que también brindaba la posibilidad de procesamiento de múltiples texturas en OpenGL (cuando se aplicaban dos texturas a un píxel al mismo tiempo, lo que aceleraba la representación general de la escena) que nunca se ha utilizado antes. Al igual que el Voodoo original, la tarjeta funcionaba exclusivamente en modo 3D, pero a diferencia de sus competidores que combinaban el procesamiento 2D y 3D en un solo chip, 3Dfx no hizo concesiones, persiguiendo el objetivo principal de defender su posición como líder del mercado.

Las versiones profesionales del nuevo adaptador no tardaron en llegar: la compañía subsidiaria 3Dfx Quantum3D lanzó tres aceleradores notables basados en la novedad: un Obsidian2 X-24 de dos chips, que podría usarse en conjunto con una placa 2D, SB200 / 200Sbi con 24 MB de memoria EDO a bordo, así como Mercury Heavy Metal, un sándwich exótico en el que 200Sbi emparejados estaban interconectados por una placa de contacto Aalchemy, que en el futuro se convirtió en el prototipo del famoso puente NVidia SLI.

Mercury Heavy Metal

Este último fue diseñado para simulaciones gráficas complejas y estaba disponible por un precio de espacio de $ 9999 . El monstruo MHM requería una placa base de servidor de la serie Intel BX o GX con cuatro ranuras PCI para funcionar correctamente.

Al darse cuenta de la importancia del control sobre el mercado económico, en junio de 1998 3Dfx presentó Voodoo Banshee, el primer acelerador de gráficos compatible con los modos de operación 2D y 3D. Contrariamente a las expectativas y esperanzas, el legendario chip Rampage nunca estuvo listo, y la tarjeta solo tenía una unidad de procesamiento de texturas a bordo, lo que prácticamente destruyó el rendimiento de la novedad en el renderizado multi-poligonal: Voodoo 2 era muchas veces más rápido. Pero incluso si la producción económica con una marca reconocible garantizaba buenas ventas para Banshee, la decepción de los fanáticos no desapareció en ninguna parte; se esperaba mucho más de los creadores de “ese mismo Voodoo”, que de la noche a la mañana cambió el mercado gráfico.

Además, a pesar del liderazgo de Voodoo 2, la brecha con los competidores estaba disminuyendo rápidamente. Después de haber impuesto una seria competencia a ATI y NVidia, 3Dfx se enfrentó a soluciones cada vez más avanzadas, y solo gracias a una gestión eficaz (3Dfx produjo y vendió las tarjetas por sí mismo, sin la participación de socios), la empresa obtuvo importantes beneficios de las ventas. Pero la administración de 3Dfx vio muchas oportunidades en la adquisición de sus propias fábricas para la producción de obleas de silicio, por lo que la compañía compró STB Technologies por $ 131 millones con la expectativa de una reducción radical en los costos de producción y la imposición de competencia a los proveedores Nvidia (TSMC) y ATI (UMC). Este acuerdo se volvió fatal en la historia de 3Dfx: las fábricas mexicanas de STB estaban irremediablemente rezagadas con respecto a los competidores asiáticos en términos de calidad del producto y no podían competir en la carrera por el proceso tecnológico.

Después de que se conoció la adquisición de STB Technologies, la mayoría de los socios de 3Dfx no apoyaron la dudosa decisión y cambiaron a los productos NVidia.

Nvidia TNT - Solicitud de liderazgo técnico

Y la razón de esto fue el Riva TNT presentado por Nvidia el 23 de marzo de 1998. Al agregar una canalización de píxeles paralelos a la arquitectura Riva, los ingenieros duplicaron la renderización y la velocidad de renderización, lo que, junto con 16 MB de memoria SDR, aumentó significativamente el rendimiento. El Voodoo 2 usaba una memoria EDO mucho más lenta, y esto le dio al nuevo producto de Nvidia una ventaja significativa. Por desgracia, la complejidad técnica del chip dio sus frutos, debido a errores de hardware en la producción del chip TSMC de 350 nm no funcionó en el 125 MHz concebido por los ingenieros, la frecuencia a menudo se redujo a 90 MHz, razón por la cual Voodoo 2 pudo retener el título de líder formal en rendimiento.

Incluso con todos sus defectos, el TNT era un producto nuevo impresionante. Gracias al uso del bus AGP de dos canales, la tarjeta proporcionó soporte para resoluciones de juegos de hasta 1600x1200 con color de 32 bits (y un búfer Z de 24 bits para garantizar la profundidad de la imagen). En el contexto de Voodoo 2 de 16 bits, el nuevo producto de nVidia parecía una verdadera revolución en los gráficos. Aunque TNT no era líder en benchmarks, se mantuvo peligrosamente cerca de Voodoo 2 y Voodoo Banshee, ofreciendo más tecnologías nuevas, mejor escalado en la frecuencia del procesador y procesamiento de texturas y 2D de mayor calidad gracias al bus AGP progresivo. El único inconveniente, como en el caso del Rage 128, fueron los retrasos en la entrega: una gran cantidad de adaptadores apareció a la venta solo en el otoño, en septiembre de 1998.

Otra mancha en la reputación de Nvidia en 1998 fue una demanda de SGI, según la cual NVidia violó los derechos de patente de su tecnología interna de mapeo de texturas. Como resultado del litigio, que duró todo un año, se firmó un nuevo acuerdo, según el cual NVidia obtuvo acceso a las tecnologías SGI y SGI tuvo la oportunidad de utilizar los desarrollos de Nvidia. Al mismo tiempo, se disolvió la propia división gráfica de SGI, lo que solo benefició al futuro líder gráfico.

Número nueve - Paso lateral

Mientras tanto, el 16 de junio de 1998, el fabricante de gráficos OEM Number Nine decidió probar suerte en el mercado de tarjetas gráficas lanzando una tarjeta Revolution IV con su propia marca.

Muy por detrás de las soluciones insignia de ATI y Nvidia, Number Nine se ha centrado en el sector empresarial, ofreciendo a las grandes empresas aquello en lo que las tarjetas clásicas para juegos y gráficos 3D eran débiles: compatibilidad con altas resoluciones en color de 32 bits.

Para ganar el interés de las grandes empresas, Number Nine integró un conector OpenLDI patentado de 36 pines en su Revolution IV-FP y vendió la placa junto con un monitor SGI 1600SW de 17,3 pulgadas (compatible con una resolución de 1600x1024). El conjunto costó $ 2795.

La oferta no tuvo mucho éxito, y Number Nine volvió a asociarse con las tarjetas S3 y Nvidia hasta que S3 la compró en diciembre de 1999 y luego la vendió a los antiguos ingenieros de la compañía que formaron Silicon Spectrum en 2002.

S3 Savage3D: una alternativa económica a Voodoo y TNT por $ 100

El campeón de presupuesto S3 Savage hizo su debut en el E3 de 1998 y, a diferencia de los sufridos dominadores del segmento anterior (Voodoo Banshee y Nvidia TNT), llegó a las tiendas un mes después del anuncio. Desafortunadamente, la prisa no podía pasar desapercibida: los controladores eran "crudos" y el soporte de OpenGL se implementó solo en Quake, porque no podía permitirme ignorar uno de los juegos más populares del año, S3.

Las frecuencias del S3 Savage tampoco fueron suaves. Debido a fallas de fabricación y al alto consumo de energía, los modelos de adaptadores de referencia se calentaron mucho y no proporcionaron el umbral de frecuencia previsto de 125 MHz, la frecuencia usualmente flotaba entre 90 y 110 MHz. Al mismo tiempo, los revisores de las principales publicaciones obtuvieron muestras de ingeniería que funcionaron correctamente a 125 MHz, lo que proporcionó números hermosos en todo tipo de puntos de referencia, junto con elogios de la prensa especializada. Más tarde, se resolvieron los primeros problemas en los modelos asociados: Savage3D Supercharged funcionó de manera estable a 120 MHz, y Terminator BEAST (Hercules) y Nitro 3200 (STB) conquistaron la codiciada barra de 125 MHz.A pesar de los controladores crudos y el rendimiento mediocre en el contexto de los líderes de los Tres Grandes, el precio democrático dentro de los $ 100 y la capacidad de reproducir videos de alta calidad permitieron que el S3 obtuviera buenas ventas.

1997 y 1998 fueron otro período de adquisiciones y quiebras: muchas empresas no pudieron soportar la competencia en la carrera por el rendimiento y se vieron obligadas a abandonar la industria. Cirrus Logic, Macronix y Alliance Semiconductor se quedaron atrás, mientras que Dynamic Pictures se vendió a 3DLabs, Tseng Labs y Chromatic Research fueron compradas por ATI, Micron dejó Rendition, AccelGraphics adquirió Evans & Sutherland, y Chips and Technologies pasó a formar parte de Intel.

Trident, S3 y SiS: la batalla final del milenio por gráficos económicos

El mercado de OEM siempre ha sido la última gota para los fabricantes que se han quedado irremediablemente rezagados con respecto a la competencia en gráficos 3D y rendimiento puro. Este fue también el caso de SiS, que liberó el presupuesto SiS 300 para las necesidades del sector empresarial. A pesar de un rendimiento 3D deplorable (limitado por una canalización de un solo píxel) y una brecha en 2D desesperada detrás de todos los competidores en el mercado principal, el SiS 300 conquistó a los OEM con ciertas ventajas: un bus de memoria de 128 bits (64 bits en el caso del SiS 305 más simplificado), soporte para color de 32 bits, DirectX 6.0 (e incluso 7.0 en el caso del 305), soporte para renderizado de texturas múltiples y decodificación MPEG2 por hardware. Había una tarjeta gráfica y una salida de TV.

En diciembre de 2000, el SiS 315 modernizado vio la luz, con un segundo canal de píxeles y un bus de 256 bits, así como soporte completo para DirectX 8.0 y anti-aliasing de pantalla completa. La tarjeta recibió un nuevo motor de procesamiento de iluminación y textura, compensación por retrasos en la reproducción de video desde medios DVD y soporte para el conector DVI. El nivel de rendimiento estaba en la región de la GeForce 2 MX 200, pero esto no molestó a la empresa en absoluto.

SiS 315 también llegó al mercado OEM, pero ya como parte del conjunto de chips SiS 650 para placas base en el zócalo 478 (Pentium IV) en septiembre de 2001, y también como parte del sistema SiS552 SoC en 2003.

Pero SiS estaba lejos de ser el único fabricante que ofrecía soluciones interesantes en el segmento de presupuesto. Trident también luchó por la atención de los compradores con el Blade 3D, cuyo rendimiento general estaba a la par con el fallido Intel i740, pero el precio de $ 75 cubrió con creces muchas de las deficiencias. Posteriormente, entró al mercado el Blade 3D Turbo, en el que las frecuencias aumentaron de 110 a 135 MHz, y el rendimiento general alcanzó el nivel de i752. Desafortunadamente, Trident tardó demasiado en desarrollar sus soluciones para el mercado, donde se presentaban nuevos productos cada dos meses, por lo que ya en abril de 2000 esto supuso el primer golpe para la empresa: VIA, para la cual Trident estaba desarrollando gráficos integrados, adquirió la empresa S3 y dejó de cooperar con la primera. compañero.

Sin embargo, Trident ha aprovechado su modelo de negocio al máximo, combinando envíos a granel y bajos costos de fabricación para sus soluciones económicas. El mercado móvil permaneció relativamente vacío, y Trident desarrolló varios modelos Blade3D Turbo específicamente para él: el T16 y T64 (operando a 143 MHz) y XP (operando a 165 MHz). Pero el mercado OEM que atraía a muchas empresas ya no apoyaba la simplicidad de Trident: el SiS 315, lanzado un poco más tarde, dio paso a toda la línea de productos Trident. Incapaz de desarrollar rápidamente una alternativa viable, Trident decidió vender la división de gráficos a la subsidiaria de SiS, XGI, en 2003.

S3 Savage4 se distingue de otras soluciones en el sector del presupuesto. Anunciado en febrero y salió a la venta en mayo de 1999, el nuevo producto ofrecía 16 y 32 MB de memoria interna, un bus AGP de 64 bits y cuatro canales y su propia tecnología de compresión de texturas, gracias a la cual el adaptador podía procesar bloques con resoluciones de hasta 2048x2048 sin mucha dificultad (aunque esto y se implementó anteriormente en Savage3D). La tarjeta también era capaz de renderizado multitextural, pero incluso los controladores depurados y las impresionantes características técnicas no podían ocultar el hecho de que las ofertas del año pasado de 3Dfx, Nvidia y ATI fueron significativamente más productivas. Y esta situación se repitió un año después, cuando entró en el mercado el Savage 2000. A bajas resoluciones (1024x768 y menos), el nuevo producto podría competir con Nvidia TNT y Matrox G400.pero cuando se eligió una resolución más alta, el equilibrio de poder cambió radicalmente.

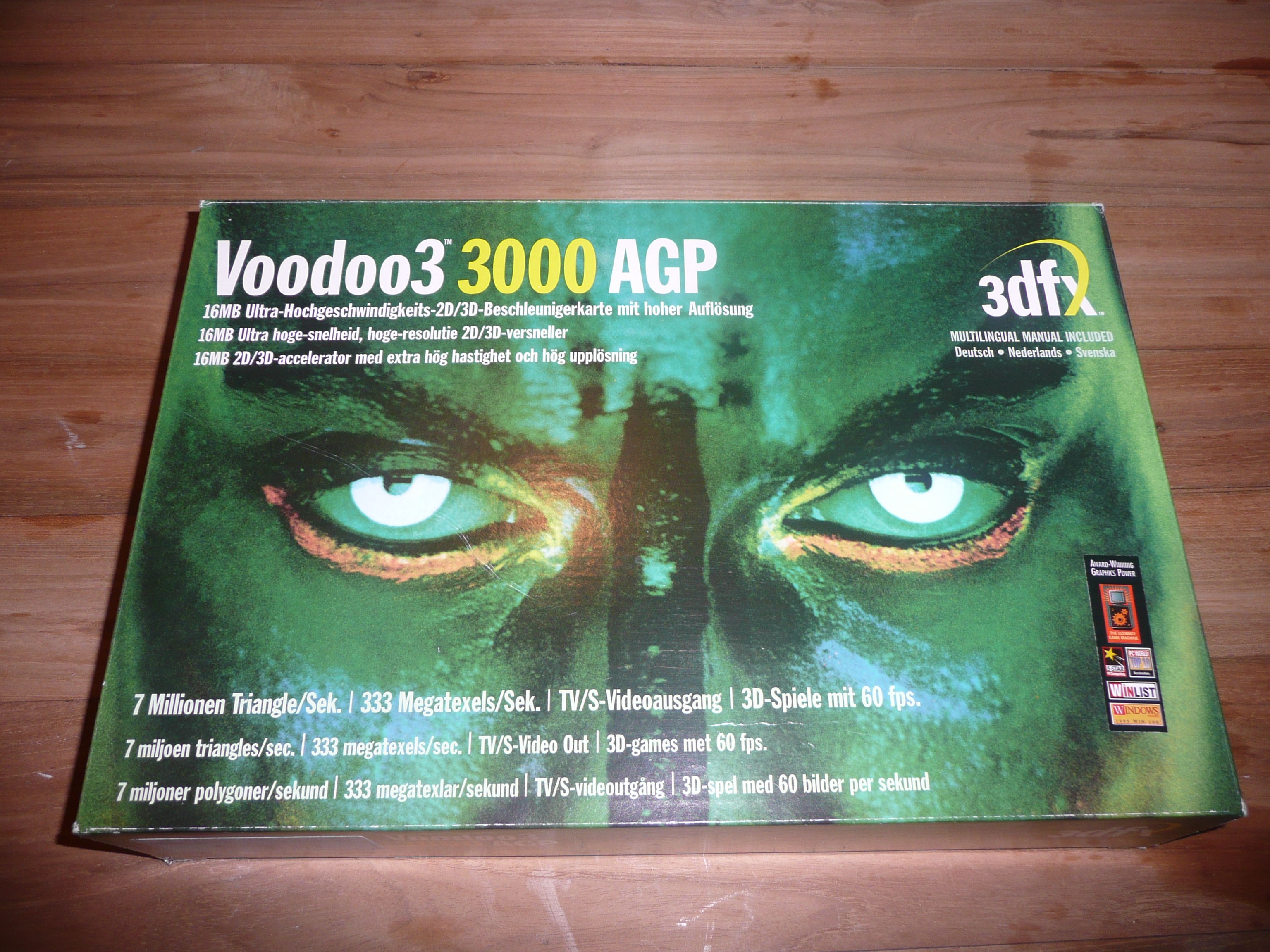

3Dfx Voodoo3 - Paphos, ruido y excusas vacías

3Dfx no podía permitir que su nuevo producto se perdiera en el contexto de competidores progresistas, por lo que el estreno de Voodoo3 en marzo de 1999 estuvo acompañado de una extensa campaña publicitaria: la tarjeta se promocionó vívidamente en la prensa y en la televisión, y el diseño atrevido de la caja atrajo la atención de compradores potenciales que soñaban con una nueva revolución gráfica.

Por desgracia, el conjunto de chips Rampage, que se convirtió en la comidilla de la ciudad, todavía no estaba listo, y la novedad arquitectónica era un pariente del Voodoo2 basado en el chip Avenger. Las tecnologías arcaicas como el soporte para el color exclusivamente de 16 bits y la resolución de textura de solo 256x256 no complacieron a los fanáticos de la marca, al igual que la falta total de soporte para el procesamiento de hardware de iluminación y geometría. Muchos fabricantes ya han introducido una moda para texturas de alta resolución, renderizado multi-poligonal y color de 32 bits, por lo que por primera vez 3dfx estuvo entre los rezagados en todos los aspectos.

Los inversores tuvieron que explicar la pérdida de $ 16 millones por el reciente terremoto en Taiwán, que, sin embargo, tuvo poco impacto en el éxito financiero de ATI y Nvidia. Al darse cuenta de los beneficios obvios de la distribución gratuita de bibliotecas DirectX y OpenGL, la compañía anunció en diciembre de 1998 que su API Glide estaría disponible como código abierto. Es cierto que en ese momento casi no había demasiada gente dispuesta.

Riva TNT2 y G400: competidores por delante

Simultáneamente con el grandilocuente estreno de Voodoo3 de 3Dfx, Nvidia presentó modestamente su RIVA TNT 2 (con las primeras tarjetas de la serie Ultra en su historia, donde los jugadores recibieron frecuencias de núcleo y memoria más altas), y Matrox presentó el igualmente impresionante G400.

Riva TNT2 se fabricó con tecnología de 250 nm en las fábricas de TSMC y pudo proporcionar a Nvidia un nivel de rendimiento sin precedentes. La novedad aplastó a Voodoo3 en casi todas partes; ¡la excepción fueron solo algunos juegos que usaban AMD 3DNow! Combinado con OpenGL. Nvidia también se mantuvo al día con la tecnología: la serie TNT2 presentaba un conector DVI para admitir los últimos monitores de pantalla plana.

Una verdadera sorpresa para todos fue Matrox G400, que resultó ser incluso más productivo que TNT2 y Voodoo3, quedando rezagado solo en juegos y aplicaciones que usan OpenGL. Por su asequible precio de 229 dólares, el nuevo producto de Matrox ofrecía una excelente calidad de imagen, un rendimiento envidiable y la capacidad de conectar dos monitores mediante un conector de doble cabezal. El segundo monitor estaba limitado a una resolución de 1280x1024, pero a muchas personas les gustó la idea.

El G400 también cuenta con mapeo de relieve mapeado en el entorno (EMBM) para mejorar la representación general de la textura. Para aquellos que siempre prefirieron comprar lo mejor, estaba la G400 MAX, que ostentaba el título de la tarjeta más productiva del mercado hasta el lanzamiento de la GeForce 256 con memoria DDR a principios de 2000.

Matrox Parhelia 3DLabs Permedia –

El gran éxito en el mercado de los aceleradores de gráficos para juegos no inspiró a Matrox, que regresó al mercado profesional, solo una vez tentado a repetir el éxito del G400 con Parhelia, pero en 2002 los competidores ya dominaban DirectX 9.0 con fuerza y fuerza, y el soporte para tres monitores se desvaneció simultáneamente en el contexto de un rendimiento de juego deplorable.

Cuando la audiencia ya había logrado digerir los lanzamientos de alto perfil de tres empresas, 3DLabs presentó Permedia 3 Create! La característica principal de la novedad fue el posicionamiento de nicho: 3DLabs esperaba atraer la atención de los profesionales que prefieren pasar su tiempo libre en los juegos. La empresa se centró en el alto rendimiento en 2D, y atrajo a los especialistas adquiridos en 1998 Dynamic Pictures, los autores de la línea profesional de adaptadores de oxígeno.

Desafortunadamente para 3DLabs, el modelado de polígonos complejos era una prioridad en los mapas profesionales y, a menudo, un alto rendimiento en esta dirección se debía a una disminución importante en la velocidad de procesamiento de texturas. Los adaptadores de juegos con prioridad en 3D funcionaron exactamente lo contrario: en lugar de cálculos complejos, la velocidad de renderizado y las texturas de procesamiento con alta calidad de imagen estaban a la vanguardia.

Muy por detrás de Voodoo3 y TNT 2 en juegos, y no muy por detrás de la competencia en aplicaciones y tareas de trabajo, Permedia fue el último intento de 3DLabs de llevar un producto al mercado de adaptadores de juegos. Además, los famosos ingenieros gráficos continuaron expandiendo y apoyando sus líneas especializadas: GLINT R3 y R4 en la arquitectura Oxygen, donde la abundancia de modelos varió desde el económico VX-1 por $ 299 hasta el premium GVX 420 por $ 1499.

El repertorio de la compañía también incluía la línea de adaptadores Wildcat, basada en los desarrollos de Intense3D, comprados a Integraph en julio de 2000. En 2002, mientras 3DLabs completaba activamente el desarrollo de chips gráficos avanzados para los nuevos adaptadores Wildcat, Creative Technology compró la empresa con sus planes para las líneas P9 y P10.

En 2006, la compañía abandonó el mercado de las computadoras de escritorio, enfocándose en soluciones para el mercado de los medios, y luego pasó a formar parte del Creative SoC, y pasó a ser conocida como ZiiLab. La historia de 3DLabs finalmente terminó en 2012 cuando Intel compró la empresa.

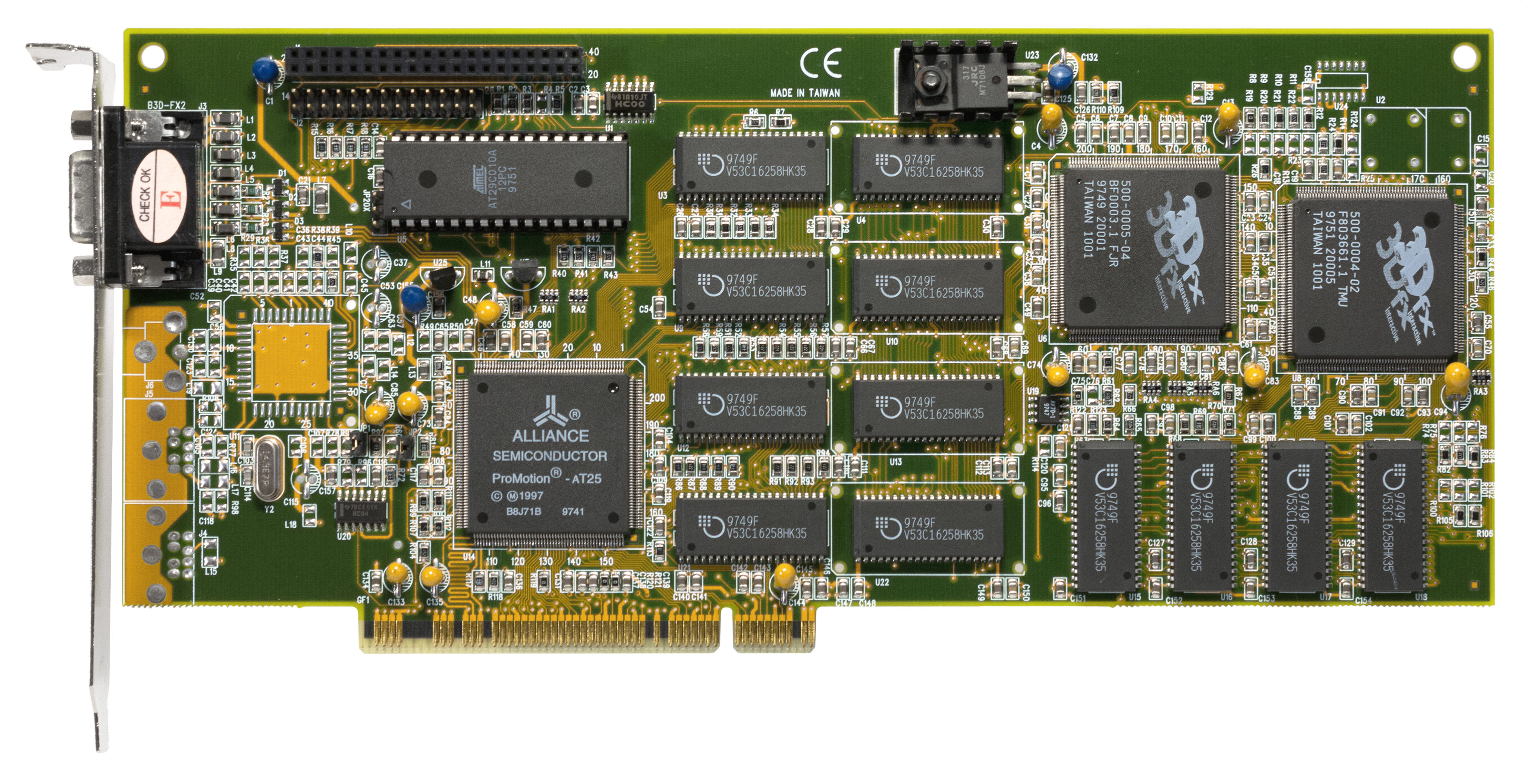

ATI Rage MAXX - Retraso de locura de doble chip

Desde el lanzamiento del exitoso Rage 128, ATI ha experimentado una serie de dificultades para seguir desarrollando la línea. A finales de 1998, los ingenieros implementaron con éxito el soporte para el bus AGP 4x en una versión actualizada del adaptador Rage 128 Pro, agregando una salida de TV al número de conectores. En general, el chip gráfico se mostró aproximadamente al nivel de TNT 2 en términos de rendimiento de juego, pero después del lanzamiento de TNT 2 Ultra, el campeonato pasó nuevamente a Nvidia, que los canadienses no querían aguantar: comenzó el trabajo en el Proyecto Aurora.

Cuando quedó claro que se había perdido la carrera por el rendimiento, los ingenieros recurrieron a un truco que se convertirá en una de las características de muchas generaciones de tarjetas rojas en el futuro: lanzaron la Rage Fury MAXX, una tarjeta gráfica de doble GPU, en cuya placa estaban trabajando dos Rage 128 Pros.

Furia de rabia MAXX

Las impresionantes especificaciones y la posibilidad de operación en paralelo de dos chips hicieron de la tarjeta con un nombre odioso una solución bastante productiva, y llevaron a ATI adelante, no fue posible mantener el liderazgo durante mucho tiempo. Incluso la S3 Savage 2000 luchó por el título de la mejor, y la GeForce 256 con memoria DDR presentada más tarde no dejó ninguna posibilidad al buque insignia de ATI, a pesar de los números amenazantes y las tecnologías progresivas. A Nvidia le gustaba ser la primera, y la joven Jen-Hsun Huang no tenía prisa por ceder el paso al líder del mercado.

GeForce 256 es la primera verdadera "tarjeta de video". El nacimiento del término GPU

Han pasado menos de dos meses desde que ATI disfrutó de una pírrica victoria en los puntos de referencia con el anuncio de Rage Fury MAXX, cuando Nvidia presentó la respuesta que aseguró el estatus de líder del mercado - GeForce 256. La novedad fue la primera en la historia en salir con diferentes tipos de memoria de video - 1 de octubre de 1999 Una versión con chips SDR vio la luz y el 1 de febrero de 2000 comenzaron las ventas de una versión actualizada con memoria DDR.

GeForce 256 DDR

Se fabricó un chip gráfico de 23 millones de transistores en las fábricas de TSMC utilizando una tecnología de proceso de 220 nm, pero, lo que es más importante, fue la GeForce 256 la que se convirtió en el primer adaptador gráfico en ser llamado "tarjeta de video". ¿Ha notado cuán cuidadosamente evitamos este término a lo largo de la historia? Ese fue el punto de las sustituciones incómodas. El término GPU (Unidad de procesamiento de gráficos) proviene de la integración de texturas e iluminación previamente separadas como parte del chip.

Las amplias capacidades de la arquitectura permitieron que el chip gráfico de la tarjeta gráfica realizara cálculos de punto flotante pesados, transformando conjuntos complejos de objetos 3D y escenas compuestas en una hermosa presentación en 2D para el jugador impresionado. Anteriormente, todos estos cálculos complejos los realizaba el procesador central de la computadora, lo que constituía una seria limitación de los detalles en los juegos.