Dobles de películas

Probablemente haya visto actores dobles en la pantalla más de una vez y, lo más probable, ni siquiera notó la sustitución. Si antes los maquilladores eran responsables de la similitud, ahora los directores atraen cada vez más a equipos de desarrollo de la industria del desarrollo de juegos.

El Gladiador que utilicé como ejemplo fue una de las primeras películas en presentar un gemelo digital. Aquellas de sus escenas que no tuvieron tiempo de ser filmadas con Oliver Reed fueron recolectadas a partir de material parcialmente filmado, agregando fotogramas hechos con gráficos 3D. Para 1999, logramos un resultado absolutamente fantástico, e incluso los especialistas en CG a menudo no notan la sustitución.

Otro ejemplo famoso de la recreación de un héroe cinematográfico tras la muerte de un actor es la película "Superman Returns" (2006) de Brian Singer. Convertir a Marlon Brando en padre de un superhombre fue una cuestión de principios para el director, porque allá por 1978 Brando desempeñaba el mismo papel en Superman.

Se creó un modelo 3D de la cara del actor a partir de fotografías, y su animación (expresiones faciales y movimientos oculares) se creó sobre la base de las imágenes del actor que no se incluyeron en la versión final de edición. En general, un proceso que requiere mucho tiempo.

Hace diez años, muchas operaciones complejas para crear un modelo fotorrealista se realizaban manualmente. La industria cinematográfica moderna ya dispone de una enorme pila tecnológica para los mismos fines, y no es necesario "reinventar la rueda".

Quizás el ejemplo más revelador de avances en tecnología es el proceso de creación de cuero en 3D. La piel humana transmite luz y un rayo que la atraviesa se refleja y distribuye internamente. En los gráficos por computadora, esto se denomina dispersión subsuperficial, la distribución de la luz debajo de la superficie. Los motores de renderizado modernos, que implementan la funcionalidad de materiales de dispersión subsuperficial, pueden calcular este efecto físicamente correctamente. Y hace 10 años, tenías que programarlo o crear una "falsificación" en el posprocesamiento.

Ahora el proceso está automatizado y solo necesita cambiar manualmente el color y la textura de la piel. Además, la gestión del color se puede llevar a cabo mediante un mecanismo biológicamente correcto: cambiando el contenido de melanina en el material de la piel. Los gemelos digitales modernos son tan realistas que difícilmente puedes entender que en un marco en particular ves al humano digital y no a tu actor favorito.

¿Quieres hacer ejercicio? Mira la serie SuperBobrovs con la estrella del corazón del perro Vladimir Tolokonnikov. Desafortunadamente, el actor, conocido por todos por su papel de Polígrafo Poligrafovich Sharikov, no pudo completar el rodaje debido a un paro cardíaco. Así que todas las escenas perdidas fueron interpretadas por su avatar.

El progreso serio en la creación de gemelos digitales también está asociado con el desarrollo de la potencia informática. Si antes, para calcular una secuencia con un carácter digital, se necesitaban granjas enteras de procesadores y RAM, ahora todo se considera en una computadora de juegos doméstica, de manera lenta pero segura. Entonces creo que Antony Proximo podría ser renderizado en aproximadamente un mes por tres de nosotros. Y si también tenemos en cuenta la creación de un modelo tridimensional (la parte más costosa y que consume más tiempo del trabajo), la duración total del proyecto sería de 2 a 2,5 meses, y el presupuesto podría limitarse a $ 100 mil.

Fábrica de contenido empresarial

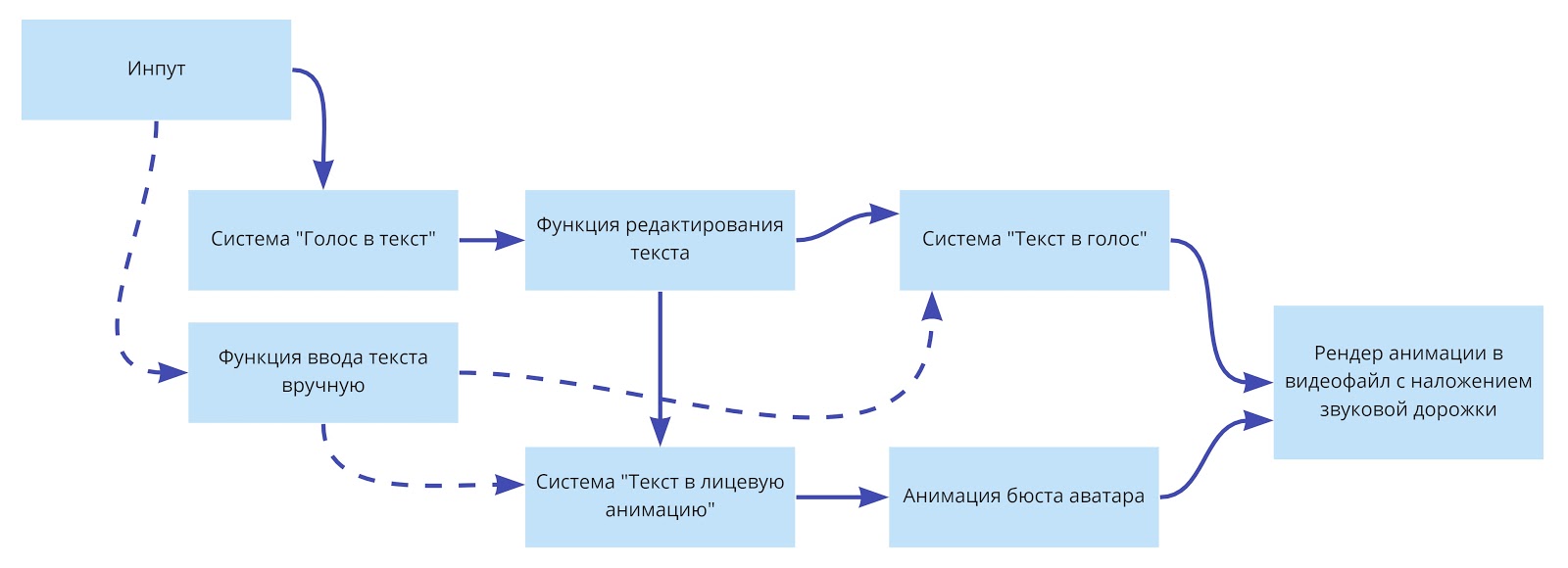

Los avances en tecnologías para la creación de modelos fotorrealistas de personas van acompañados de un salto en el desarrollo de redes neuronales con las que se pueden controlar modelos 3D. Juntos, esto forma la base para una aplicación más amplia del ser humano digital. Entonces, al combinar un modelo 3D con redes neuronales o un chat bot, puedes organizar una fábrica completa para la producción de contenido de video: le "alimentas" con el texto y tu avatar lo lee con expresiones faciales y emociones. El desarrollo de tal escenario ya está en el mercado , sin embargo, no utilizan modelos 3D, sino fotografías de personas reales.

Al mirar a los presentadores de noticias en los canales federales, muchos piensan que así es como funcionan. De hecho, no, los presentadores no solo leen el texto con expresiones faciales y emociones, sino que también lo escriben por sí mismos. Y en el futuro, por supuesto, las redes neuronales podrán "escribir" texto para TV y blogs de video, y los avatares podrán expresarlos. Y al organizar informes, también será posible ahorrar dinero: envíe solo al operador al sitio y superponga un avatar de pie con el texto escrito por el editor en el material de video ya filmado.

En LANIT-Integration pensamos que dos direcciones de uso de tecnologías humanas digitales son las más prometedoras.

El primero es reemplazar la cara de una persona con un video.... Probablemente, todos ya hayan visto los clones de Elon Musk que se conectaron a las conferencias de Zoom. Este escenario se llama Deep Fake y, como su nombre lo indica, se utiliza para todo tipo de falsificaciones. Tecnológicamente, la misma dirección también se llama Face Swap, pero este escenario ya no es para las relaciones públicas negras, sino para fines comerciales que no causan controversia ética. Por ejemplo, puede depurar la producción de contenido educativo.

Un banco con una red de sucursales federales tiene muchos videos de capacitación de diversa calidad. Algunos de ellos son solo grabaciones de conferencias de Zoom. La baja calidad del video y la situación en el cuadro, que no se corresponde con el estándar corporativo, no permiten recopilarlos en un solo curso de formación. Y con la ayuda de avatares digitales y redes neuronales, puede arreglar todo: cambiar tanto el fondo como la apariencia del orador.

Un escenario similar para la creación de productos de video es de interés para la televisión y los blogueros. Recientemente, el productor de un canal temático se puso en contacto con nosotros y nos pidió estimar el costo de producir números regulares con la participación de un avatar digital como presentador. Por supuesto, Digital Human no eliminará todas las tareas -todavía no existe tecnología que permita a un avatar reproducir emociones al procesar texto por una red neuronal- para esto aún se necesita una persona viva, cuyas expresiones faciales y cuyos movimientos usará el avatar. Además, necesita un especialista que se hará cargo de la redacción de guiones, textos para actuación de voz. Es cierto que se vuelve completamente insignificante cómo se ven las personas involucradas en la producción de contenido de medios, qué género son, cuál es su timbre de voz y dónde se encuentran. Para disparar, necesitará un traje para captura de movimiento, un casco con una cámara de video dirigida a la cara (para "capturar" expresiones faciales),y el propio avatar, que en tiempo real transmitirá en pantalla todos los movimientos del trabajador fuera de la pantalla. Según nuestros cálculos, esta tecnología reducirá 10 veces el costo de producción de video.

La segunda dirección de la aplicación Digital Human es combinar un avatar digital con un chatbot y un sistema de síntesis de voz , y puede tener mucha demanda para la comunicación con los clientes.

Muchos centros de llamadas ahora usan bots de chat. Pero no todos los clientes se sienten cómodos comunicándose con un robot. Quizás la comunicación sería más agradable si el cliente viera a su interlocutor digital.

Al conectar un chat bot, un micrófono y un sistema de reconocimiento y síntesis de voz a un avatar digital, puede crear azafatas virtuales, consultores de ventas, consultores en instituciones gubernamentales ( Soul Machines tiene un caso similar : la asistente virtual Ellase comunica con los visitantes de la sede de la policía de Nueva Zelanda), sommeliers; en general, cualquier empleado cuya tarea principal sea simplemente responder a las preguntas de los clientes. En teoría, esto ahorrará dinero en nómina y empleados, para hacer lo que la red neuronal aún no puede hacer.

Experimentos con apariencia

Entonces, la base para todos los escenarios anteriores es un avatar digital. Ya he dicho que su creación es un proceso muy laborioso. De hecho, estamos hablando de una escultura humana virtual realizada por un escultor 3D. Trabaja a través de todos los detalles de la apariencia, y luego usando herramientas de simulación "crece" el cabello.

No surgirán preguntas sobre la apariencia si crea una copia de una celebridad o modelo. ¿Qué pasa si necesitas crear una persona virtual desde cero? ¿Qué rasgos le darás?

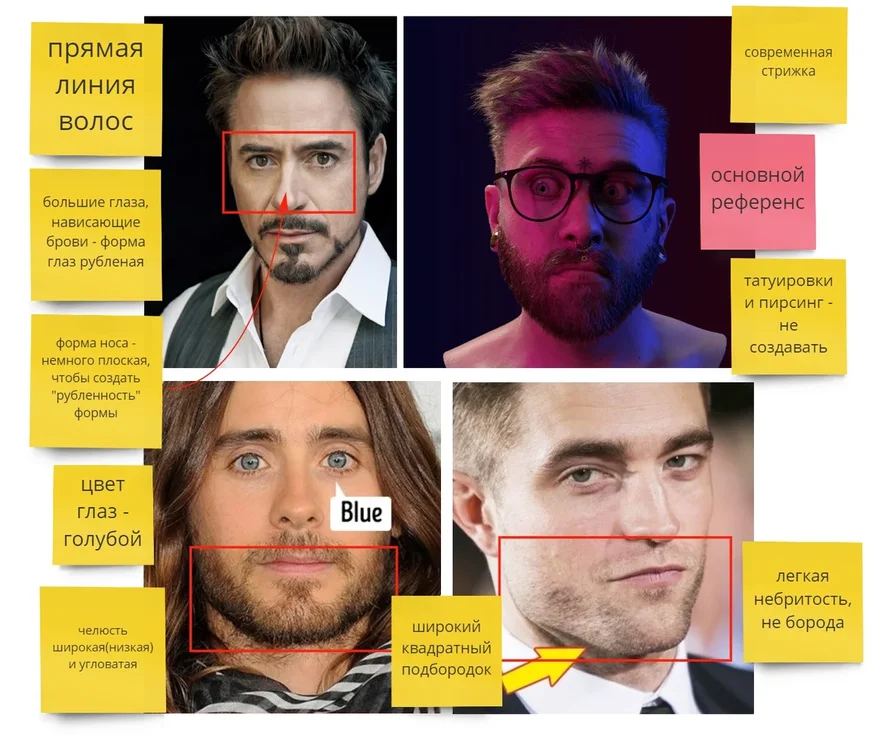

Como experimento, decidimos crear nuestro propio avatar digital: el embajador de LANIT. Por supuesto, podría preguntarle a todos sus colegas cómo debería verse. Pero, en primer lugar, una encuesta a varios miles de personas ya es demasiado y, en segundo lugar, basándonos en estos datos, tendríamos que crear un segundo Ken para Barbie, una imagen generalizada agradable, completamente desprovista de individualidad. No, no necesitamos un embajador así en absoluto. Tomamos un camino diferente.

Cada uno de nosotros se ha formado una serie de estereotipos a lo largo de los años. Por ejemplo, una barba gris espesa se asocia con una buena disposición (como Santa Claus), cejas anchas y rectas, con franqueza y carácter dominante, etc.

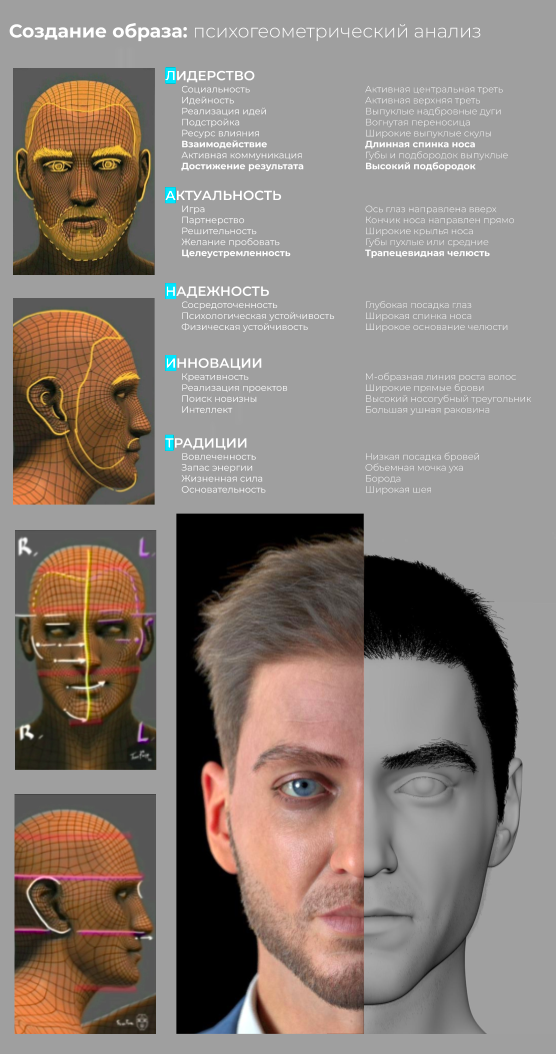

Hemos formado una experiencia en psicogeometría facial y entrenado la red neuronal para identificar, con base en patrones de percepción, la relación entre la apariencia de una persona y la impresión que da. Ahora analiza las características de su apariencia y da un conjunto de palabras que describen cómo una persona puede parecer a los demás, por ejemplo, amable, vulnerable, insegura, tranquila, etc. Tomamos estos desarrollos y comenzamos el proceso en orden inverso: le dimos a la red neuronal una descripción de nuestro futuro héroe (cómo la audiencia objetivo debería percibirlo) y obtuvimos un cierto conjunto de rasgos faciales.

Haré una reserva importante de inmediato: de ninguna manera pretendemos ser científicamente confiables en nuestro experimento. Además, hay muchas investigaciones que confirman que es peligroso buscar relaciones entre los rasgos faciales y, por ejemplo, el carácter o (Dios no lo quiera) la inteligencia. Entonces no estamos explorando el campo científico, sino las posibilidades de la tecnología.

Entonces, “alimentamos” las redes neuronales con cualidades humanas que corresponden a las características del espíritu corporativo: liderazgo, innovación, confiabilidad, dedicación, etc.

E incluso una selección tan selectiva de las cualidades necesarias llevó al hecho de que obtuvimos un personaje completamente neutral que no causa ninguna emoción. Por tanto, los resultados que nos dio la red neuronal debían corregirse manualmente.

La cara y, en general, toda la infografía consta de tres componentes:

- 3D-, ;

- , , ;

- ( , ).

1.

Cabeza

Para crear Maxim (como nombramos a nuestro avatar), tomamos como base la forma simplificada de una cabeza humana y formamos los detalles (esculpir) en Zbrush. Primero, se creó un modelo de alta poli, en el que se trabajaron los detalles más pequeños, incluidos los poros de la piel (se desarrollaron texturas para ello).

Estamos usando texturas 4K. Las texturas 8K dan un mejor resultado en primeros planos, pero la necesidad de ellas es rara, por lo que nos negamos a utilizar texturas 8K por el bien del rendimiento. Una vez que el modelo de alta poli está listo, creamos una copia de baja poli y le transferimos pequeños detalles usando mapas normales (mapas de "relieve" de superficie).

Pelo

Hay muchas herramientas para crear cabello. Elegimos GroomBear para Houdini para mantener la pila de software plana; la mayor parte del trabajo técnico se realiza en Houdini.

Ropa.

Marvelous Designer se utilizó para modelar la ropa, y en Blender se completaron pliegues y pequeños y característicos detalles.

2. Texturizado

Realizamos el texturizado en Substance Painter; en nuestra opinión, sus herramientas proporcionan el proceso de texturizado más simple y rápido. Un punto importante es la pista : para corregir la imagen del avatar, basta con cambiar solo la textura de la piel, sin tocar la base geométrica en absoluto. Sin embargo, esto no es un secreto para los amantes del maquillaje. Con la ayuda de los cosméticos, las mujeres chinas logran a diario un efecto comparable al de la cirugía plástica. Y para los avatares, un cambio de apariencia tan simple significa grandes ahorros en la producción de contenido de video: tres clics y la imagen de tu personaje ha cambiado drásticamente, tanto que ya es una persona completamente diferente.

3. Animación

Nuestro personaje está sintonizado para trabajar con sistemas de captura de movimiento: el traje de maqueta corporal Xsense y el sistema de maqueta facial Dynamixyz. No usamos sistemas ópticos de captura de movimiento, ya que son muy voluminosos, no móviles, lo que significa que el proceso de producción de contenido tendría muchas más restricciones.

Xsense controla los movimientos del tronco, la cabeza y las extremidades. El sistema de animación es híbrido: grandes arreglos de geometría son controlados por huesos, que a su vez, son controlados por los datos del sistema de maquetas, y los pliegues de la ropa en la zona de las articulaciones y otros lugares característicos son controlados por mezclas auxiliares (estados del modelo con pliegues característicos en la zona de las articulaciones), que aseguran su correcto funcionamiento. geometría donde la animación de huesos no permite el resultado correcto.

La necesidad de crear mezclas de formas es el principal problema de la creación del vestuario de un personaje: es laborioso. Para cada nueva prenda, el artista necesita crear varias docenas de formas de mezcla. Estamos buscando activamente formas de automatizar esta rutina, y si tiene ideas o soluciones preparadas, estaré encantado de discutirlas con usted en los comentarios.

Dynamixyz gestiona la animación facial, y configurar la animación facial es la parte más difícil y que consume más tiempo del proceso. El caso es que bajo la piel del rostro se esconden 57 músculos (el 25% del número total de músculos del cuerpo humano), y el movimiento de cada uno de ellos afecta la expresión facial.

El reconocimiento de rostros y emociones es una habilidad extremadamente importante necesaria para la existencia en la sociedad, por lo que las personas capturan instantáneamente expresiones faciales inverosímiles. Entonces, para el avatar, necesitas hacer una animación facial que sea 100% realista.

Cada rostro puede tener una variedad infinita de expresiones, pero como ha demostrado la práctica, 150 combinaciones de formas son suficientes para crear una animación realista. Fuimos un poco más allá y creamos 300 formas de combinación (y continuamos creando nuevas si encontramos situaciones en las que 300 no es suficiente).

Dynamixyz funciona según el siguiente principio: se coloca un casco en la cabeza del actor, en el que se fijan cámaras especializadas con velocidades de transferencia de datos ultra altas. El video de estas cámaras se transmite a la estación de trabajo, donde la red neuronal determina los puntos de anclaje en la cara del actor y en cada cuadro los empareja con los puntos de anclaje de la máscara facial virtual, obligándolo a moverse. Un sistema de mezclas de formas está vinculado a los movimientos de la mascarilla, que "cambian" de acuerdo con la naturaleza del movimiento de la mascarilla. Cada forma de mezcla se crea para toda la cara en su conjunto, pero se puede cambiar durante la animación localmente, por ejemplo, en el área de la boca o el ojo derecho, por separado del resto de la cara. Estos interruptores son suaves y completamente invisibles a la vista.

Existen sistemas alternativos de animación facial que requieren menos mano de obra, como el patentado recientemente por Sberbank. Pero la reducción de los costos laborales tiene el precio de la calidad y la flexibilidad, razón por la cual abandonamos el uso de tales tecnologías.

4. Render

Nuestro Maxim vive en Unreal Engine y Houdini.

En Unreal Engine (UE), renderizamos animaciones que no requieren un posprocesamiento complejo, porque el UE no nos permite obtener los canales y máscaras completos necesarios para el posprocesamiento en la salida, y además tiene una serie de limitaciones (por ejemplo, no es posible hacer la mascarilla capilar correcta, por lo tanto que el UE no sabe cómo hacer traslúcidas las máscaras). Experimentamos con el trazado de rayos en tiempo real (RTX) durante algún tiempo, pero, al no haber recibido un aumento significativo en la calidad de imagen, abandonamos su uso.

Usamos Arnold para renderizar en Houdini. Este es un renderizado de CPU y funciona bastante lento en comparación con los motores de GPU y RealTime, pero la elección recayó en ella, porque las pruebas comparativas mostraron que los materiales de dispersión de la superficie secundaria (y el material de la piel es solo eso) y el material del cabello en Arnold funcionan en el orden es mejor que en Redshift y Octane, y V-ray, desafortunadamente, produce artefactos al azar en los materiales de dispersión de superficie.

5. Interactivo

La dirección más prometedora (pero también la más difícil), desde nuestro punto de vista, del desarrollo de los avatares digitales es su combinación con productos de software: asistentes de voz, bots de chat, sistemas de voz2 texto, etc. Estas integraciones abren la puerta a la creación de productos escalables. Actualmente estamos trabajando activamente en esta dirección, construyendo hipótesis y prototipos. Si tiene alguna idea para usar avatares digitales de esta manera, me complacerá discutirla.

¿Lindo o repugnante? El movimiento mejorará este efecto.

Quizás Maxim te recuerde a alguien que conoces. O tal vez negoció con una persona similar ayer. ¿Era lindo o molesto con su forma de comunicarse? En cualquier caso, la imagen de Maxim evoca emociones.

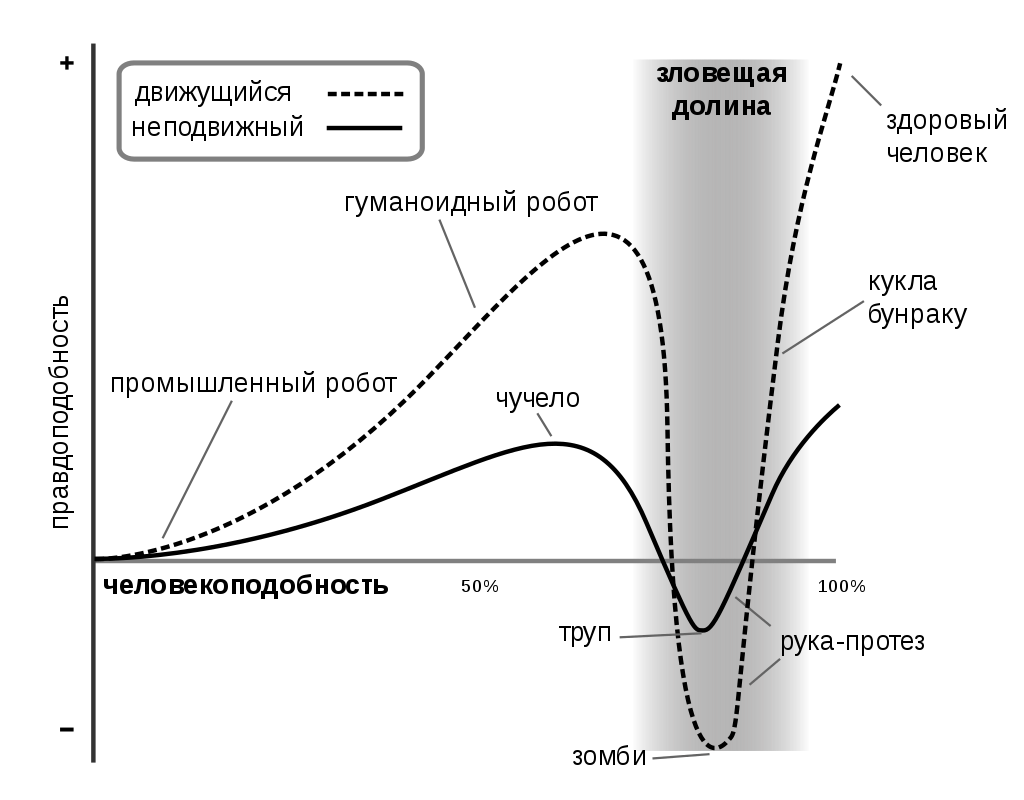

En el proceso de creación, probamos en nuestra propia experiencia el efecto del "Valle del Mal" descrito por el japonés Masahiro Mori, quien investigó la percepción de los robots humanoides por parte de los humanos. Esto se detalla en la Wiki, pero en resumen: cuanto más se parece un robot a un humano, más simpatía sentimos por él. Este efecto crece hasta cierto punto. Cuando un robot es casi indistinguible de una persona, nosotros, mirándolo, comenzamos a sentir incomodidad e incluso miedo, todo porque al robot se le dan los detalles más pequeños, que la mayoría de las veces ni siquiera podemos identificar y nombrar. Este cambio abrupto en nuestras reacciones (corresponde a la falla en el gráfico) se llama el "Valle del Mal". Al mismo tiempo, la animación mejora los efectos negativos y positivos; sin embargo, como se puede ver en el gráfico, la semejanza total con una persona solo se puede lograr con la ayuda de la animación.

Entonces, nuestro Maxim cruzó el "Valle Ominoso", pero un matiz afecta negativamente su percepción: sin animación, no tiene expresión facial en absoluto, todos los músculos faciales están relajados, lo que no sucede en una persona viva. Por lo tanto, se ve muy distante, no mira al interlocutor, sino como a través de él, lo cual es muy desagradable.

Maxim nos parece un digno representante de la familia de avatares. A medida que Digital Human se vuelve cada vez más popular, esperamos que nuestros clientes y socios pronto decidan adquirir un avatar con fines de marketing. Entonces Maxim tendrá hermanos y hermanas en razón, artificial, por supuesto.

Mientras tanto, Maxim está solo explorando las oportunidades que el mercado B2B abre para los avatares digitales: en octubre de 2020, participará en la conferencia.“Smart Solutions - Smart Country: Tecnologías innovadoras para una nueva realidad” y la exposición de arte digital Disartive promoverán los productos y servicios de LANIT en las redes sociales y posiblemente darán varias entrevistas.

El mercado emergente de Digital Human

Hay empresas en Rusia que están trabajando en una dirección similar a la nuestra. Pero no todos son públicos: muchos interactúan con los estudios de gamedev y crean personajes para los juegos (y este mundo vive según sus propias reglas, y muy a menudo los estudios usan el modelo de Hollywood sin revelar a sus contratistas).

La empresa más famosa es, quizás, Malivar , en la que Sberbank invirtió 10 millones de rublos. Es propietaria del personaje virtual Aliona Pole, artista, modelo y autora de colecciones de "ropa digital".

En una fracción de segundo, una modelo digital cambia una blusa roja por una azul, se prueba nuevos looks sin detener el movimiento. Y el espectador, criado en Instagram Stories y TikTok, está feliz de ver videos cortos con una cantidad fantástica de transformaciones que no están disponibles para un modelo vivo.

Aliona se está alejando gradualmente de la imagen de solo una modelo, adquiriendo todos los rasgos humanos nuevos en su Instagram: promueve una actitud ecológica hacia el mundo, filosofa sobre el tema de los límites de la personalidad, mezcla la realidad ordinaria y virtual y se `` ahoga '' por la individualidad y la positividad corporal.

Hay un interesante proyecto de avatar digital en el mercado global: Samsung - Neon... Por supuesto, los desarrolladores aún están lejos de crear una nueva forma de vida, pero enseñaron a sus modelos 3D a moverse bien. Gracias a una interfaz que puede convertir la voz en texto, el modelo analiza la información entrante, la transforma en soluciones y da comandos internos para mover las manos y otras partes del cuerpo. En CES 2019, la compañía contó con los avatares de una enfermera, un presentador de televisión, un explorador de parques nacionales, un entrenador físico y varios otros. Escribí

sobre el proyecto de Nueva Zelanda para crear asistentes de Soulmachines arriba. Probablemente, hay otros proyectos que merecen atención, pero tienen pocas noticias importantes, aunque ahora se están invirtiendo fondos importantes en el desarrollo de avatares digitales.

¿Qué opinas de los avatares? Me encantaría tener mi clon digital para asistir a las reuniones de Zoom y comunicarme con el jefe y, por supuesto, un conjunto de ropa digital, siempre una camisa planchada, chaqueta, corbata, todo.