Una herramienta de reconocimiento de gestos musicales basada en inteligencia artificial desarrollada en el MIT-IBM Watson AI Lab utiliza movimientos corporales para distinguir entre los sonidos de instrumentos musicales individuales.

Imagen cortesía de los investigadores.

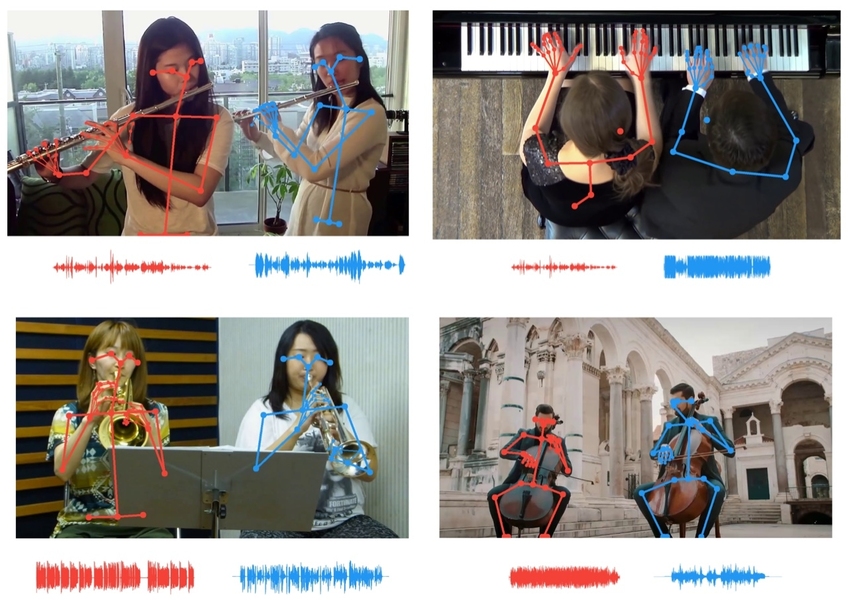

Los investigadores utilizan datos de puntos clave esqueléticos para correlacionar los movimientos de los músicos con el tempo de sus partes, lo que permite a los oyentes aislar instrumentos que suenan igual.

Imagen cortesía de los investigadores.

Disfrutamos de la música no solo con nuestros oídos, sino también con nuestros ojos, viendo con gratitud cómo los dedos del pianista vuelan sobre las teclas y el arco del violinista se balancea en la cresta de las cuerdas. Cuando el oído es incapaz de separar dos instrumentos musicales, nuestros ojos nos ayudan haciendo coincidir los movimientos de cada músico con el ritmo de cada parte.

Nueva herramienta de inteligencia artificial desarrollada por MIT-IBM Watson AI Labutiliza ojos virtuales y oídos de computadora para separar sonidos que son tan similares que es difícil para una persona diferenciarlos. El instrumento se ha mejorado con respecto a iteraciones anteriores al alinear los movimientos de los músicos individuales utilizando puntos clave de su esqueleto con el tempo de las partes individuales, lo que permite a los oyentes aislar el sonido de una flauta o violín individual entre varios de los mismos instrumentos.

Los posibles usos del trabajo van desde mezclar sonido y aumentar el volumen de un instrumento en una grabación hasta reducir la confusión que hace que las personas se interrumpan durante una videoconferencia. El trabajo se presentará en la conferencia Computer Vision Pattern Recognition este mes.

"Los puntos clave en el cuerpo proporcionan información estructural poderosa", dijo el autor principal Chuang Gang , investigador del laboratorio de IBM. "Los estamos usando aquí para mejorar la capacidad de la IA para escuchar y separar el sonido".

En este y otros proyectos similares, los investigadores utilizaron pistas de audio y video sincronizadas para recrear la forma en que las personas aprenden. Un sistema de inteligencia artificial que aprende con múltiples modalidades sensoriales puede aprender más rápido, con menos datos y sin tener que agregar manualmente atajos molestos a cada vista del mundo real. “Aprendemos de todos nuestros sentidos”, dice Antonio Torralba, profesor del MIT y coautor del estudio. "El procesamiento multisensorial es el precursor de la inteligencia incorporada y los sistemas de inteligencia artificial que pueden realizar tareas más complejas".

Esta herramienta, que utiliza el lenguaje corporal para separar los sonidos, se basa en trabajos anteriores en los que se utilizaron señales de movimiento en secuencias de imágenes. Su primera encarnación, PixelPlayer, permitió hacer clic en un instrumento en un video en vivo para hacerlo más alto o más bajo. La actualización de PixelPlayer te permite diferenciar entre dos violines en un dúo haciendo coincidir los movimientos de cada músico con el tempo de su parte. Esta última versión agrega datos de puntos clave (que los analistas deportivos usan para rastrear el rendimiento de los atletas, para extraer datos de movimiento más granulares) para distinguir sonidos casi idénticos.

El trabajo destaca la importancia de las señales visuales en la enseñanza de las computadoras para que puedan oír mejor y el uso de señales audibles para darles una visión más nítida. Así como el estudio actual utiliza información visual sobre los movimientos de un músico para separar partes de instrumentos musicales que suenan similares, trabajos anteriores utilizaron sonidos para separar objetos y animales similares de la misma especie.

Torralba y sus colegas han demostrado que los modelos de aprendizaje profundo entrenados en datos de audio y video emparejados pueden aprender a reconocer sonidos naturales , como el canto de los pájaros o las olas que golpean la orilla. También pueden determinar las coordenadas geográficas de un vehículo en movimiento mediante el sonido de su motor y las ruedas que se acercan o se alejan del micrófono.

La investigación más reciente sugiere que las herramientas de seguimiento de audio podrían ser una adición útil a los autos autónomos, ayudando a sus cámaras en condiciones de poca visibilidad. “Los rastreadores de sonido pueden ser especialmente útiles por la noche o con mal tiempo, ya que ayudan a marcar vehículos que de otro modo podrían haberse perdido”, dice Hang Zhao, Ph.D. '19, quien participó en una investigación sobre rastreo de sonido y movimiento.

Otros autores del estudio CVPR sobre gestos musicales son Dan Huang y Joshua Tenenbaum del MIT.

Eso es todo. Para obtener más información sobre el curso, lo invitamos a inscribirse para la jornada de puertas abiertas en el siguiente enlace:

Lee mas:

Cómo le enseñé a mi computadora a jugar Doble usando OpenCV y Deep Learning