Hoy en día, las tecnologías de captura de movimiento (captura de movimiento) se utilizan con mayor frecuencia en películas y videojuegos. Pero existen otras opciones para su aplicación: hoy, la captura de movimiento ayuda a competir por el título de mejor operador de máquinas, permite hacer diagnósticos por andar, preservar las danzas de los pueblos pequeños para las generaciones futuras y en el futuro te permitirá librar una verdadera guerra desde un acogedor búnker.

Caballos, modelos proletarios y explosiones nucleares: ¿Qué intentaban fotografiar los creadores de la captura de movimiento?

En 1878, Leland Stanford, el gobernador de California, fundador de la Universidad de Stanford y entusiasta de la equitación, hizo una apuesta con sus amigos. Sostuvo que un caballo que corre al galope en un momento determinado levanta las cuatro patas del suelo. Los amigos no estuvieron de acuerdo y fue imposible probar o confirmar visualmente la suposición. Stanford luego trajo al reconocido fotógrafo e investigador de movimientos animales Edward Muybridge para resolver la disputa. En la finca de Leland en Palo Alto, se construyó un "fotódromo" especial: un corral que consta de una pared blanca y cámaras dirigidas desde la pared opuesta. Se tendieron cuerdas a lo largo del camino del corral, atadas a las puertas de la cámara. Cuando el caballo comenzó a galopar, el jinete lo guió hasta el fotódromo, las patas del animal tocaron las cuerdas, las puertas funcionaron y aparecieron una serie de imágenes.

Así nació la cronofotografía, la primera tecnología de captura de movimiento que ayudó a resolver una disputa de 25.000 dólares.

Stanford demostró que tenía razón: en un galope, un caballo realmente levanta las cuatro patas del suelo, pero en este momento están escondidas debajo del cuerpo, y no estiradas hacia adelante y hacia atrás, como suelen representar artistas de diferentes épocas. Este pequeño descubrimiento causó furor entre críticos de arte y artistas a principios del siglo XIX-XX. Por cierto, solo se usaron caballos negros para disparar; sus movimientos se registran más claramente contra el fondo blanco del fotódromo. Fuente: Eadweard Muybridge / Wikimedia Commons

Pero la tecnología de captura de movimiento fue interesante no solo por la oportunidad de ganar una apuesta, y posteriormente apareció más de un aparato basado en el principio de la cronofotografía. Por ejemplo, el fotógrafo Arnold Lond inventó el cronofotógrafo de 12 lentes en 1891 para capturar las expresiones faciales de los pacientes del neurólogo Jean Charcot. Desde entonces hasta ahora, la tarea principal y más difícil ha sido reproducir las acciones capturadas.

Los primeros en interesarse por esta oportunidad fueron los multiplicadores. En la primera década del siglo XX comenzó la era de las caricaturas, que eran títeres o dibujadas a mano. Los artistas buscaron lograr la máxima verosimilitud de los movimientos de los personajes dibujados. Esto fue hecho por el inventor estadounidense Max Fleischer, quien, junto con su hermano Dave, inventó la rotoscopia ("foto-desplazamiento") en 1914. Al principio, se filmaron actores reales. Luego, esta grabación se amplió fotograma a fotograma, se proyectó y se reprodujo en un lumen de vidrio. El artista trazó cada cuadro en papel de calco. El resultado fue una nueva película con un personaje realmente conmovedor.

, , , . Tantalizing Fly (« ») . . «», « 7 », « », «-», «», « » . : Mohamed El Amine CHRAIBI / YouTube

Reproducción realista de movimientos por medio de su captura de video interesando en esos años a los científicos de la Rusia soviética, interesados en la organización científica del trabajo. Si estudia a fondo los movimientos de los mejores representantes del proletariado, entonces puede enseñar a otros trabajadores: esta era la lógica del liderazgo y los científicos soviéticos. Este tema fue tratado por el Instituto Central del Trabajo (CIT), creado en Moscú, y supervisado por Nikolai Bernstein, fundador de la dirección científica de biomecánica, que estudia el movimiento humano. En su laboratorio, Bernstein realizó estudios ciclogramétricos: el sujeto estaba vestido con un traje especial, compuesto por decenas de pequeñas lámparas, que desempeñaban el papel de marcadores. Luego, usando filmación rápida (100-200 cuadros por segundo), se obtuvo un ciclograma. El error al medir las posiciones de una persona en movimiento o corriendo fue de solo 0,5 mm.

A lo largo de los años, Bernstein ha estudiado los movimientos de atletas, trabajadores y músicos, lo que ha ayudado a mejorar el rendimiento en las competiciones y desarrollar métodos de enseñanza en diferentes campos. A pesar de la desgracia durante el período de la lucha contra los "cosmopolitas", Bernstein logró dar recomendaciones sobre la adaptación de los astronautas al estado de ingravidez. Fuente: Thomas Oger / YouTube

Es de destacar que Bernstein anticipó el surgimiento de la captura de movimiento óptica y acústica, para la cual todavía se utilizan sensores conectados al cuerpo humano.

Esta idea fue desarrollada por el estadounidense Lee Harrison III, quien experimentó con microcircuitos analógicos y tubos de rayos catódicos. En 1959, diseñó un traje con potenciómetros integrados (resistencias ajustables) y fue capaz de grabar y animar los movimientos de un actor en tiempo real en un tubo de rayos catódicos. Aunque era una configuración primitiva, el actor animado parecía un pilar de luz en la pantalla, fue la primera captura de movimiento en tiempo real.

Paralelamente, el método fotoóptico se abrió camino cuando la captura de movimiento se logró fotografiando un objeto a alta velocidad o desde diferentes ángulos de visión. Harold Edgerton, el inventor de la cámara Rapatronic, creada en la década de 1940, contribuyó en gran medida a esto. Es capaz de grabar una imagen fija con un tiempo de exposición de tan solo 10 nanosegundos. Gracias a este dispositivo, el científico pudo capturar eventos muy rápidos, desde una salpicadura de agua de una gota que cae hasta una explosión nuclear.

El momento de la explosión de una carga nuclear una fracción de segundo después de la detonación, capturado por una cámara rapatrónica. Fuente: Gobierno Federal de los Estados Unidos / Wikimedia Commons

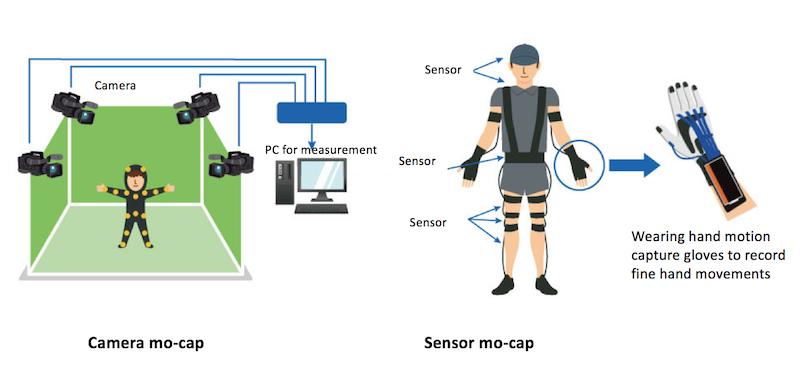

A finales del siglo XX, se formaron dos tecnologías principales de captura de movimiento, que se denominan convencionalmente marcador y sin marcador. En el primer caso, la captura de movimiento se produce mediante marcadores o sensores colocados en el cuerpo humano. Pueden ser diferentes: infrarrojos, magnéticos, giroscópicos. La luz infrarroja puede reflejar (pasiva) o emitir luz (activa), las magnéticas distorsionan el flujo magnético y el receptor de ondas determina su posición en el espacio, el sensor giroscópico también transmite información sobre los cambios en la posición del cuerpo en el espacio.

Los sistemas sin marcadores se basan en la captura óptica. Hay muchas cámaras montadas en la habitación, que disparan desde diferentes ángulos. Las imágenes resultantes luego se combinan en un modelo 3D. Otro tipo es un exoesqueleto, que se adjunta al cuerpo y crea un modelo de animación, capturando movimientos.

Si el modelo del personaje capturado debe colocarse posteriormente en un entorno virtual, entonces se filma en una sala verde (clave cromática). El verde contrasta mucho con los colores del cuerpo humano, por lo que la computadora es mejor para recortar los píxeles verdes de los marcos. Fuente: Toshiba

Las capturas de movimiento se utilizan principalmente en películas y videojuegos. Sin embargo, cada año esta tecnología se utiliza cada vez más fuera de la industria del entretenimiento: en la fabricación, la medicina, la preservación del patrimonio cultural, los deportes y los asuntos militares.

Repita después de mí: ¿cómo enseña Toshiba el uso de archivos con captura de movimiento?

Puedes mirar infinitamente el fuego, el agua y cómo trabaja alguien. Y a veces puede beneficiarse de ello. En Toshiba lo descubrimos hace mucho tiempo, por lo que Hiroaki Nakamura es un especialista en captura de movimiento en nuestro Centro de Ingeniería de Fabricación Corporativa. Recientemente, ha estado siguiendo con entusiasmo cómo trabajan los participantes del Campeonato Nacional de Profesionales, un concurso especial para artesanos en diferentes campos, desde la panadería hasta la soldadura.

En 2018, Haruki Okabe, un joven trabajador de una de las empresas de Toshiba, decidió participar en este concurso, concretamente en el montaje de un pequeño dispositivo. A la hora de montarlo, los concursantes utilizan un buen archivo antiguo para el procesamiento final de algunas piezas. Se cree que los técnicos de primera clase en este negocio pueden lograr una precisión de mecanizado de 0,001 mm o menos; de lo contrario, el dispositivo no funcionará. Aquí es donde nuestro concursante resultó débil y se perdió la victoria en la competencia.

Toshiba envió a un instructor de 66 años, Tatsuo Matsui, que trabajó como un archivo en las empresas de la compañía durante más de 50 años, para ser mentor del joven especialista. Sin embargo, no todos los portadores de habilidades únicas nacen siendo un buen maestro capaz de transmitirlas. Explicó que el problema estaba en la posición del concursante en la máquina, pero el asunto no avanzó más. Luego los vestimos a ambos con trajes de captura de movimiento. Están "cosidos" según el principio del marcador, es decir, se utilizan sensores para registrar los movimientos. En este caso, los acelerómetros son aproximadamente los mismos que en los teléfonos inteligentes. Es mucho más económico que varias cámaras.

Cuando comparamos sus datos, notamos una diferencia significativa en cómo se balancean sobre sus pies.

El eje vertical es la resistencia del soporte [N] y el horizontal es el tiempo [S]. Dado que el centro de gravedad del trabajador joven está más concentrado en la pierna delantera en comparación con el trabajador experimentado, existe una gran brecha entre sus curvas azul y verde. (Okabe, un joven trabajador, es zurdo y Matsui, un maestro, es diestro, por lo que las líneas están invertidas en los diagramas). Fuente: Toshiba

Resultó que el centro de gravedad del joven trabajador se desplazó fuertemente hacia adelante, no de la misma manera que el del especialista experimentado. Debido a esto, el concursante se cansa rápidamente al trabajar con un archivo, y debido a esto, se produce un matrimonio. Al darse cuenta de su error, Okabe pudo mejorar la calidad de su archivo. Y se llevó el bronce en el Campeonato Nacional Profesional de Japón. Quizás, nuestros descendientes aprenderán de los registros del trabajo de Matsuya. Y también podemos reservarles otro tipo de arte que desaparece: la danza.

: ?

Probablemente todo el mundo ha oído hablar de la Lista del Patrimonio Mundial de la UNESCO, que incluye más de 1.000 sitios naturales y artificiales que la humanidad busca preservar y transmitir a las generaciones futuras. A principios de la década de 2000, muchos pensaron en cómo preservar lo que no fue construido por las manos ni creado por la naturaleza: cantos, ceremonias, representaciones teatrales, artesanías. Así surgió el concepto de patrimonio cultural inmaterial (PCI), que también se acumula y conserva desde 2003. Y la tecnología de captura de movimiento ayuda a preservar uno de los principales objetos de ICH: el baile.

Varios proyectos en todo el mundo están digitalizando los bailes de los pueblos del mundo (Wholedance, i-Treasures, AniAge y otros). Muy a menudo, al grabar bailes, se utilizan sensores activos y pasivos, que se colocan en el cuerpo del bailarín.

Los sistemas de captura de movimiento con sensores activos utilizan LED que emiten su propia luz. Por ejemplo, el sistema de captura de movimiento Phasespace Impulse X2 consta de ocho cámaras capaces de detectar movimiento mediante LED modulados. La bailarina se pone un traje con 38 sensores y LED activos y comienza a bailar.

El proyecto WholoDance experimentó con la integración de Microsoft HoloLens como herramienta de visualización. La transmisión de datos desde Autodesk MotionBuilder de forma inalámbrica a un auricular permite a los bailarines y coreógrafos ver hologramas en tiempo real. Fuente: Jasper Brekelmans / YouTube

En los sistemas de captura pasiva, los sensores no emiten una señal, solo la reflejan utilizando materiales especiales con los que está fabricado el traje. Esta tecnología proporciona al bailarín una mayor libertad de acción, le permite realizar movimientos bruscos, realizar elementos acrobáticos y, al mismo tiempo, no reduce la precisión y velocidad de fijación. Ahora los científicos esperan integrar tecnologías de marcadores de captura de movimiento y disparos en 3D, ya que la mímica y el vestuario del bailarín están involucrados en la danza.

Se utilizan tecnologías de captura de movimiento similares para una forma de actividad física mucho más simple que la danza: para el análisis de la marcha.

Aprenda de la marcha: ¿cómo ayuda a los médicos el estudio de la marcha?

La marcha puede decir mucho sobre la salud de una persona. Timothy Niiler, de la Universidad Estatal de Pensilvania, lo sabe: recopila la colección de pasos humanos más grande del mundo utilizando tecnología de captura de movimiento. Invita a personas de 18 a 65 años a caminar bajo 12 cámaras de alta velocidad a su laboratorio. Niiler coloca unos 40 sensores reflectantes en el cuerpo de los participantes del estudio. Por lo tanto, se crea una base de datos de la marcha, que posteriormente utilizan los médicos. En primer lugar, el conocimiento de la marcha normal proporciona una base para identificar casi cualquier problema ortopédico que se presente en los adultos. Por ejemplo, si es necesario medir la efectividad de un reemplazo de cadera o rodilla, los médicos "registran" la marcha del paciente y la comparan con los parámetros de la marcha promedio de una base de datos.

? 1/3 . 1/3 . : 2/3 . 2/3 . : Motion Analysis

Los sistemas de análisis de movimiento, por ejemplo, GaitTrack, ya se utilizan directamente en los centros médicos. Con esta tecnología, los médicos calculan y generalizan los parámetros biomecánicos básicos al caminar o correr, diagnostican enfermedades articulares en una etapa temprana y detectan el riesgo de posibles lesiones. Los entrenadores y atletas utilizan la captura de movimiento de manera similar.

Más rápido, más alto, mejor: ¿Cómo ayudó la captura de movimiento a los jugadores de baloncesto?

La captura de movimiento se usa ampliamente en los deportes. El análisis de las acciones de los jugadores le permite identificar sus errores o probar una variedad de equipos. Keith Pamment es el entrenador en jefe del equipo de baloncesto, que está formado por usuarios de sillas de ruedas. También es ingeniero y durante mucho tiempo se ha preguntado cómo la captura de movimiento puede mejorar el rendimiento de los equipos de baloncesto. En particular, el sistema de captura de movimiento Perception Neuron ayudó a encontrar las sillas de ruedas más efectivas para jugadores de baloncesto con discapacidades. Los atletas disfrazados corrieron, maniobraron, driblaron y uno a uno mientras alternaban entre seis tipos diferentes de sillas mientras el entrenador estudiaba el movimiento de sus animaciones en tiempo real usando 16 cámaras.

Los avatares animados de los atletas se integraron con modelos 3D de sillas de ruedas. Fuente: Rockets Science CIC / YouTube

En un día de estudio del entrenamiento de jugadores, Keith elaboró los criterios técnicos para las sillas deportivas para su equipo basándose en la habilidad, fortalezas, debilidades, movimiento y técnica de juego del atleta. Ahora el entrenador prepara un curso completo para sus compañeros que trabajan con los mismos deportistas.

Por lo tanto, por ahora, las tecnologías de captura de movimiento se utilizan en esferas de "nicho" de la actividad humana debido a su relativa "juventud" y, como resultado, sus limitaciones técnicas. Pero con el desarrollo de la robótica, el aprendizaje automático, así como la realidad virtual y aumentada, su campo de aplicación se expandirá.

Lo que sigue: avatares robóticos, teletransportación y realidad virtual

Los robots se están volviendo cada vez más ágiles, más rápidos e inteligentes, lo que significa que la gente los enviará cada vez más a donde no quiere ir. Sin embargo, hoy en día, entre las interfaces para el telecontrol de coches se utilizan principalmente joysticks o exoesqueletos. Dichos medios no siempre son efectivos; su principal desventaja es que de una forma u otra interfieren o complican el movimiento de la persona misma, que controla remotamente el robot. Las tecnologías de captura de movimiento óptico pueden resolver este problema.

En 2018, un grupo de científicos de Gran Bretaña e Italia logró someter a un robot llamado Centauro a las acciones de una frágil niña mediante la captura de movimiento. Para hacer esto, utilizaron el económico sistema de reconocimiento de movimiento ASUS Xtion PRO, que contiene sensores infrarrojos y una función de reconocimiento de imágenes en color (RGB). Ella fue la responsable de la captura de movimiento. La información recibida fue procesada por OpenPose, un algoritmo basado en aprendizaje automático capaz de detectar en tiempo real (8-10 Hz) los movimientos del cuerpo humano utilizando imágenes 2D de una cámara RGB. Las coordenadas tridimensionales de las articulaciones y extremidades humanas obtenidas del sistema, después de la filtración, se transmiten para controlar el robot Centauro.

3D- , . : Dimitrios Kanoulas / YouTube

Por supuesto, si bien el Centauro no puede armarse con una ametralladora y transferirse a la dirección de un marino experimentado, en el futuro, la creación de tales sistemas es posible. En 2012, la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA) del Departamento de Defensa de EE. UU. Anunció un proyecto bajo el inesperado nombre "Avatar", que incluía "el desarrollo de interfaces y algoritmos que permiten a un soldado cooperar de manera efectiva con una máquina semiautónoma en dos piernas ( bi-pedal) como sustituto del soldado ". Obviamente, este sistema permitirá dotar al robot de las habilidades de un soldado experimentado y bien entrenado y, al mismo tiempo, mantenerlo vivo en el entorno operativo más difícil gracias al control remoto. Luego no se informó el progreso de los estudios.

En 2018, la Fundación XPrize anunció una competencia para crear el avatar del robot ANA Avatar XPrize, y luego se seleccionaron 77 equipos para presentar su desarrollo de robots avatar a fines de 2020. Según los términos de la competencia, los desarrolladores deben combinar soluciones en el campo de la captura de movimiento, tecnologías sensibles, AR y VR. El objetivo final, que costará $ 5 millones, es un sistema donde el operador pueda ver, escuchar, moverse y realizar diversas tareas en un entorno remoto.

El avatar debe tener tres modos de funcionamiento:

- modo totalmente controlado: el robot realiza solo comandos humanos;

- Avanzado: resuelve algunas tareas de forma independiente, por ejemplo, análisis ambiental o mapeo;

- semiautónomo: toma de decisiones independiente.

De hecho, estamos hablando de la "teletransportación" de una persona con la creación del efecto de estar presente en el punto de control del robot. En el futuro, estas tecnologías permitirán el control remoto de robots antropomórficos en un entorno desfavorable para los humanos: en el cráter de un volcán, en el espacio exterior, en zonas de desastres naturales o en guerra. En 2020 veremos los primeros desarrollos, y en 2021 descubriremos quién será el mejor y recibiremos $ 5 millones para futuras investigaciones.