Cuando se trabaja con big data, los errores no se pueden evitar. Necesita llegar al fondo de los datos, priorizar, optimizar, visualizar los datos y obtener las ideas correctas. Según las encuestas , el 85% de las empresas se esfuerzan por la gestión de datos, pero solo el 37% informa tener éxito en esta área. En la práctica, estudiar las experiencias negativas es difícil, porque a nadie le gusta hablar de fracasos. Los analistas estarán encantados de hablar sobre los éxitos, pero en cuanto se trate de errores, prepárese para escuchar sobre "acumulación de ruido", "correlación falsa" y "endogeneidad aleatoria", y sin ningún detalle. ¿Los problemas con Big Data son realmente solo teóricos?

Hoy exploraremos la experiencia de errores reales que tienen un impacto tangible en usuarios y analistas.

Errores de muestreo

En el artículo “ Big data: ¿un gran error? »Recordé una historia interesante con una startup Street Bump. La compañía invitó a los residentes de Boston a monitorear el estado de la superficie de la carretera mediante una aplicación móvil. El software registró la posición del teléfono inteligente y las desviaciones anormales de la norma: hoyos, golpes, baches, etc. Los datos recibidos fueron enviados en tiempo real al destinatario deseado de los servicios municipales.

Sin embargo, en algún momento, la alcaldía notó que hay muchas más quejas de las regiones ricas que de las pobres. El análisis de la situación mostró que los residentes adinerados tenían teléfonos con una conexión permanente a Internet, conducían con más frecuencia y eran usuarios activos de varias aplicaciones, incluida Street Bump.

Como resultado, el objeto principal del estudio era un evento en la aplicación, pero se suponía que la unidad de interés estadísticamente significativa era una persona que usaba un dispositivo móvil. Dada la demografía de los usuarios de teléfonos inteligentes (en su mayoría estadounidenses blancos con ingresos medios y altos en ese momento), quedó claro cuán poco confiables eran los datos.

El problema del sesgo involuntario lleva décadas divagando de un estudio a otro: siempre habrá personas que usen las redes sociales, aplicaciones o hashtags de forma más activa que otras. Los datos en sí mismos no son suficientes, la calidad es de suma importancia. De la misma manera que los cuestionarios influyen en los resultados de las encuestas, las plataformas electrónicas utilizadas para recopilar datos distorsionan los resultados de la investigación al influir en el comportamiento de las personas cuando trabajan con estas plataformas.

Según los autores del estudio "Revisión de los métodos de procesamiento de selectividad en las fuentes de Big Data", hay muchas fuentes de Big Data que no están diseñadas para un análisis estadístico preciso: encuestas de Internet, visitas a páginas en Twitter y Wikipedia, Google Trends, análisis de la frecuencia de hashtags, etc.

Uno de los errores más flagrantes de este tipo es predecir la victoria de Hillary Clinton en las elecciones presidenciales estadounidenses de 2016. Según una encuesta de Reuters / Ipsos publicada horas antes del inicio de la votación, Clinton tenía un 90% de probabilidades de ganar. Los investigadores sugieren que metodológicamente, la encuesta en sí podría haberse realizado sin problemas, pero la base, que consta de 15 mil personas en 50 estados, se comportó de manera irracional; lo más probable es que muchos simplemente no admitieron que querían votar por Trump.

Errores de correlación

La correlación incomprensible y la causalidad confusa a menudo desconciertan al científico de datos principiante. Como resultado, aparecen modelos que son impecables desde el punto de vista de las matemáticas y son completamente inviables en la realidad.

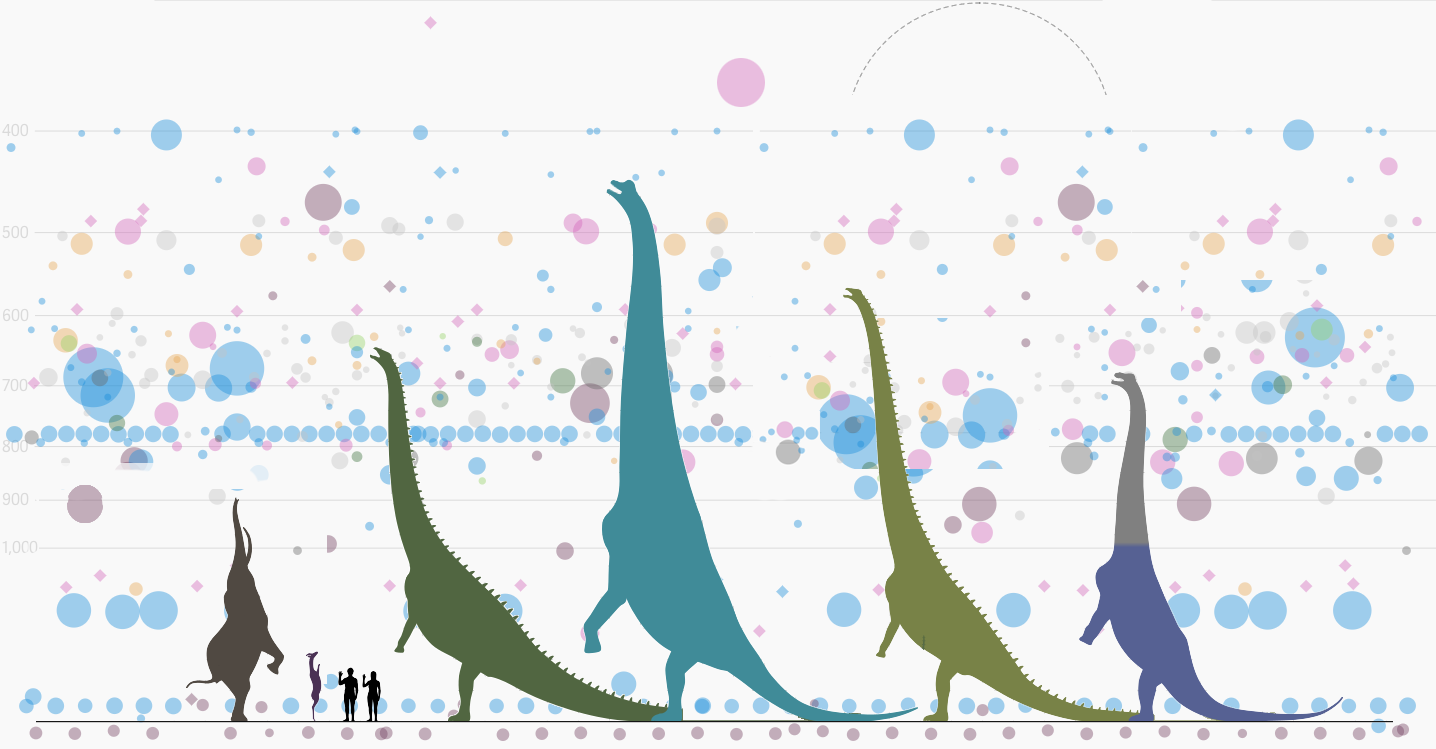

La tabla de arriba muestra el número total de avistamientos de ovnis desde 1963. El número de casos reportados de la base de datos del Centro Nacional de Informes de OVNIs se ha mantenido aproximadamente igual durante muchos años, pero hubo un fuerte salto en 1993.

Por lo tanto, podemos llegar a una conclusión completamente lógica de que hace 27 años, los extraterrestres tomaron en serio el estudio de los terrícolas. La verdadera razón fue que el primer episodio de The X-Files fue lanzado en septiembre de 1993 (en su apogeo fue visto por más de 25 millones de personas en los Estados Unidos).

Ahora eche un vistazo a los datos que muestran la frecuencia de avistamientos de ovnis según la hora del día y el día de la semana: la frecuencia más alta de avistamientos es de color amarillo anaranjado. Obviamente, los extraterrestres aterrizan en la Tierra con más frecuencia los fines de semana porque van a trabajar el resto del tiempo. Entonces, ¿investigar a las personas es un pasatiempo para ellos?

Estas divertidas correlaciones tienen implicaciones de gran alcance. Por ejemplo, un estudio sobre el acceso a la impresión en comunidades de bajos ingresos encontró que los escolares con acceso a más libros recibieron mejores calificaciones. Guiadas por los datos del trabajo científico, las autoridades de Filadelfia (EE. UU.) Comenzaron a reorganizar el sistema educativo.

El proyecto de cinco años implicó la conversión de 32 bibliotecas para brindar igualdad de oportunidades a todos los niños y familias de Filadelfia. A primera vista, el plan se veía genial, pero desafortunadamente, el estudio no tomó en cuenta si los niños realmente leían los libros; solo consideró la cuestión de si los libros están disponibles o no.

Como resultado, no se lograron resultados significativos. Los niños que no habían leído libros antes del estudio no se enamoraron repentinamente de la lectura. La ciudad perdió millones de dólares, las calificaciones de los escolares de las zonas desfavorecidas no mejoraron y los niños criados en el amor por los libros continuaron aprendiendo como lo hicieron.

Pérdida de datos

( c )

A veces, la muestra puede ser correcta, pero los autores simplemente pierden los datos que necesitan analizar. Esto sucedió en un trabajo ampliamente distribuido en todo el mundo bajo el nombre de "Freakonomics". El libro, cuya circulación total superó los 4 millones de copias, exploró el fenómeno del surgimiento de relaciones de causa y efecto no obvias. Por ejemplo, entre las ideas de alto perfil del libro, está la idea de que la razón de la disminución de la delincuencia adolescente en los Estados Unidos no fue el crecimiento de la economía y la cultura, sino la legalización del aborto.

Los autores de "Freakonomics", el profesor de economía de la Universidad de Chicago Stephen Levitt y el periodista Stephen Dubner, admitieron unos años despuésque no todas las cifras recopiladas se incluyeron en la encuesta final sobre el aborto, ya que los datos simplemente desaparecieron. Levitt explicó el error de cálculo metodológico por el hecho de que en ese momento "estaban muy cansados", y se refirió a la insignificancia estadística de estos datos para la conclusión general del estudio.

Aún es discutible si el aborto reduce realmente la delincuencia futura o no. Sin embargo, los autores han notado muchos otros errores, y algunos de ellos son sorprendentemente similares a la situación con la popularidad de la ufología en la década de 1990.

Errores de análisis

( c ) La

biotecnología se ha convertido en un nuevo rock and roll para los empresarios tecnológicos. También se le llama el "nuevo mercado de TI" e incluso el "nuevo mundo de las criptomonedas", en referencia a la explosiva popularidad entre los inversores de las empresas involucradas en el procesamiento de información biomédica.

Si los datos de biomarcadores y cultivos celulares son "aceite nuevo" o no, es una cuestión secundaria. Las consecuencias de inyectar dinero rápido en la industria son de interés. Después de todo, la biotecnología puede representar una amenaza no solo para las billeteras de capital riesgo, sino que también puede afectar directamente la salud humana.

Por ejemplo, como señalaEl genetista Stephen Lipkin, el genoma tiene la capacidad de realizar análisis de alta calidad, pero la información de control de calidad a menudo está fuera del alcance de médicos y pacientes. A veces, antes de solicitar una prueba, es posible que no sepa de antemano qué tan profunda es su cobertura de secuenciación. Cuando un gen no se lee suficientes veces para una cobertura adecuada, el software encuentra la mutación donde no la hay. A menudo, no sabemos qué algoritmo se utiliza para clasificar los alelos de genes en beneficiosos y dañinos.

Hay una granel número de artículos científicos en el campo de la genética que contienen errores. Un equipo de investigadores australianos analizó alrededor de 3.6 mil artículos genéticos publicados en varias revistas científicas líderes. Como resultado, se encontró que aproximadamente uno de cada cinco trabajos incluía genes de error en sus listas.

La fuente de estos errores es sorprendente: en lugar de utilizar lenguajes especiales para el procesamiento estadístico de datos, los científicos resumieron todos los datos en una tabla de Excel. Excel convirtió automáticamente los nombres de los genes en fechas de calendario o números aleatorios. Y es simplemente imposible volver a verificar manualmente miles y miles de líneas.

En la literatura científica, los genes a menudo se indican mediante símbolos: por ejemplo, el gen Septin-2 se abrevia a SEPT2 y el dedo anular asociado a membrana (C3HC4) 1, a MARCH1. Excel, basándose en la configuración predeterminada, reemplazó estas líneas con fechas. Los investigadores notaron que no fueron pioneros en el problema, se señaló hace más de una década.

En otro caso, Excel asestó un duro golpe a la economía. Los famosos economistas de la Universidad de Harvard Carmen Reinhart y Kenneth Rogoff analizaron 3.700 casos diferentes de aumento de la deuda pública y su impacto en el crecimiento económico en 42 países durante 200 años en su trabajo de investigación.

El trabajo "Crecimiento en el tiempo de la deuda" indicó de manera inequívoca que cuando el nivel de deuda pública está por debajo del 90% del PIB, prácticamente no afecta el crecimiento económico. Si la deuda nacional supera el 90% del PIB, la tasa de crecimiento media cae un 1%.

El estudio ha tenido un gran impacto en cómo el mundo se ha enfrentado a la última crisis económica. El trabajo ha sido ampliamente citado para justificar recortes presupuestarios en Estados Unidos y Europa.

Sin embargo, unos años más tarde, Thomas Herndorn, Michael Ash y Robert Pollin de la Universidad de Massachusetts, después de analizar el trabajo de Rogoff y Reinhart punto por punto , revelaron inexactitudes comunes al trabajar con Excel. Las estadísticas, de hecho, no muestran ninguna relación entre el crecimiento del PIB y la deuda pública.

Conclusión: correcciones de errores como fuente de errores

( c )

Dada la gran cantidad de información para analizar, surgen algunos conceptos erróneos simplemente porque esta es la naturaleza de las cosas. Si los errores son raros y casi aleatorios, las conclusiones del análisis final pueden no verse afectadas. En algunos casos, es inútil tratar con ellos, ya que la lucha con los errores en la recopilación de datos puede conducir a la aparición de nuevos errores.

El famoso estadístico Edward Deming formuló la descripción de esta paradoja de la siguiente manera: establecer un proceso estable para compensar las pequeñas desviaciones disponibles con el fin de lograr los mejores resultados puede conducir a peores resultados que si no hubiera ninguna intervención en el proceso.

Para ilustrar los problemas con la corrección excesiva de datos, usamos la simulación de correcciones en el proceso de dejar caer bolas accidentalmente a través de un embudo. El proceso se puede ajustar utilizando varias reglas, cuyo objetivo principal es brindar la oportunidad de acercarse lo más posible al centro del embudo. Sin embargo, cuanto más sigas las reglas, más frustrantes serán los resultados.

La forma más sencilla de experimentar con un embudo es en línea, para lo cual se creó un simulador . Escriba en los comentarios los resultados que ha logrado.

Podemos enseñarle cómo analizar correctamente big data en MADE Academy , un proyecto educativo gratuito de Mail.ru Group. Aceptamos solicitudes de formación hasta el 1 de agosto inclusive.