El tema de la actualización de la ley de Moore mediante la búsqueda de dependencias más complejas de la evolución de los sistemas informáticos que se plantea para la discusión es hoy bien entendido por los investigadores en el campo de las tecnologías plasmónicas y nanofotónicas.

Importante: la mayoría de los enlaces del artículo conducen a materiales en inglés. No hay tantos investigadores nacionales de fotónica en Rusia, y los que existen prefieren ser publicados en inglés.

Para un estudio adicional del tema en su tiempo libre con una taza de té, está invitado a escuchar el informe de Dmitry Fedyanin. - uno de los principales investigadores rusos sobre la aplicación de tecnologías nanofotónicas en sistemas informáticos.

Dmitry Fedyanin es investigador senior en MIPT.

Y luego analizaremos un interesante artículo en el que un grupo de autores propone un concepto sumamente original de la métrica del crecimiento de la productividad, una alternativa a la clásica ley de Moore. La idea ha madurado gracias al análisis de las limitaciones físicas naturales en las tecnologías existentes para el funcionamiento de los núcleos de procesador, así como las perspectivas confirmadas experimentalmente de nuevos sistemas basados en nanofotónica.

Las continuas demandas del sistema industrial moderno para mejorar la eficiencia computacional y el ancho de banda de comunicación han llevado a las tecnologías de semiconductores a sus límites en su estado actual. Esto ha llevado a la aparición de nuevas tecnologías que pueden superar las soluciones tradicionales. Estamos hablando de preprocesadores o aceleradores fotónicos, circuitos híbridos electrón-fotón y redes neuronales. Sin embargo, los esfuerzos realizados para describir y predecir la evolución del rendimiento de los sistemas informáticos no permiten predecir con precisión y, por lo tanto, explicar la tasa de desarrollo realmente observada; es decir, todos los indicadores propuestos terminan desviándose de su trayectoria de desarrollo varios años después de su propuesta original. Esta discrepancia requiere una métrica equilibrada,que incluiría un conjunto holístico de fuerzas impulsoras detrás de la evolución de los sistemas informáticos.

El concepto original de una nueva métrica llamada Capacidad de latencia-cantidad-resistencia (CLEAR) fue propuesto por un equipo internacional de investigadores (Shuai Sun, Vikram K.Narayana, Mario Miscuglio, Lionel C. Kimerling, Tarek El-Ghazawi, Volker J. Sorger). Según los autores del artículo (ver aquí) esta métrica cubre la dinámica de los cambios en las tasas de sincronización, la eficiencia energética, la escala del tamaño físico de las computadoras y los costos económicos. Según los autores, CLEAR es la única métrica actual que describe correctamente el desarrollo histórico de los sistemas informáticos. Incluso con diferentes opciones y combinaciones tecnológicas mutuas, CLEAR es consistente con la tasa de crecimiento constante observada, incluidas las tecnologías informáticas dominantes propuestas para su implementación en el futuro (pronóstico). CLEAR se presenta a los lectores como una guía para predecir cuantitativamente el aumento de la productividad de los sistemas informáticos en este momento y en el futuro.

A pesar de que, en general, la evolución del rendimiento informático aumenta constantemente, la velocidad de rendimiento observada de los dispositivos basados en la industria de semiconductores existente se ralentiza notablemente, especialmente en la tecnología de 14 nm (ver aquí y aquí ). Esto se debe tanto a las limitaciones físicas naturales como a los crecientes costos económicos del proceso continuo de producción de chips industriales.

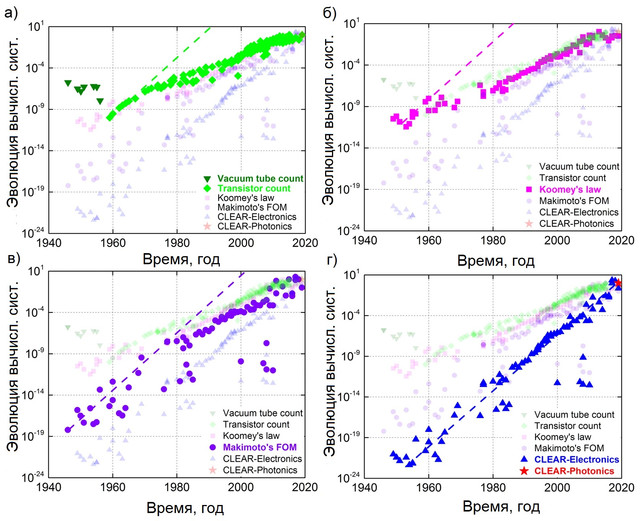

Por estas razones, la Ley de Moore como hoja de ruta para la industria de los semiconductores se ha revisado varias veces para eliminar estos obstáculos (ver aquí). De manera similar, la dinámica de desarrollo (dependencia del tiempo) de otras relaciones de cantidades físicas, como el indicador de la eficiencia del uso de la potencia de cálculo ( ley de Kumi ) o el indicador de potencia de cálculo derivado de la relación de consumo de energía, tamaño y costo ( ley de Makimoto ), como resultado, se desvía de todos modos. en comparación con la tasa observada de desarrollo tecnológico (Fig. 1), la función de tiempo elegida en el indicador (por ejemplo, multinúcleo, costo de fabricación) en la práctica no puede proporcionar un crecimiento exponencial.

Por ejemplo, el rendimiento de un procesador con N núcleos todavía está limitado por la relación 1 / ((1-p) + p / N) , donde p es el nivel de paralelización (ver.aquí ). Por lo tanto, se vuelve cada vez más difícil seguir la evolución del rendimiento de los sistemas informáticos si utilizamos solo la ley de Moore (u otras métricas de predicción existentes), en la que solo se utilizan uno o varios factores impulsores para describir el rendimiento de un sistema informático (ver aquí ). Además, los beneficios de las diferentes implementaciones de hardware (p. Ej., Eléctrico, óptico) cambian de diferentes formas a lo largo del tiempo, lo que dificulta aún más la predicción evolutiva.

Por ejemplo, la fotónica integrada y posiblemente la plasmónica pueden expandir ciertos canales de comunicación en una placa o incluso en un chip. Como resultado, los problemas de disipación de potencia térmica se mitigarán significativamente, así como un mayor ancho de banda de datos con la capacidad de superar la barrera de eficiencia digital electrónica a través de enfoques conceptuales como multiplexación por división de longitud de onda ( WDM ), momento angular óptico o formatos de modulación más altos como modulación de amplitud de polarización. modulación (por ejemplo, QAM ), donde la polarización de fase y amplitud se utilizan simultáneamente (ver aquí y aquí ).

Con respecto a las compensaciones con otras tecnologías, un transistor electrónico con un nodo de proceso de 14 nm ocupa un área 3 órdenes de magnitud menos que un modulador en anillo de un microdisco fotónico, sin embargo, la fotónica proporciona interconexión a nivel de canal sin cables capacitivos de carga / descarga, aunque es sinérgica con respecto a lo anterior. características únicas que admiten velocidades de transferencia de datos de hasta Tbps (consulte aquí ). Figura 1. La naturaleza del desarrollo de los sistemas informáticos, desde 1946 hasta la actualidad, se puede representar en forma de cuatro indicadores diferentes: (a) Ley de Moore, basada en el crecimiento del número de componentes en un chip, medido en unidades del número numérico de transistores; (segundo)

Ley de Kumi: refleja la eficiencia energética por unidad de cálculo, bit / (s * Joule); (c) Índice de Makimoto, que incluye "inteligencia", potencia, tamaño y costo del sistema, medido en unidades de MIPS / (W * mm3 * $); y (d) el puntaje CLEAR definido en la ecuación (4), que toma en cuenta la latencia del sistema además del puntaje de Makimoto y los costos económicos asociados con la introducción de la nueva tecnología: MIPS / (s * W * mm3 * $). Los datos de Photonic CLEAR se basan en la predicción de Intel de la fotónica de silicio. Las líneas discontinuas representan un ajuste lineal (logarítmico) basado en la tasa de crecimiento inicial, con una productividad anual duplicada.

Según los autores, el indicador de 5 factores CLEAR (cuyo nombre representa la abreviatura Capability-to-Latency-Energy-Amount-Resistance) es, con mucho, el más confiable para describir la evolución del rendimiento informático a lo largo del período histórico conocido, comenzando desde el comienzo mismo de la aparición de las tecnologías informáticas. en la década de 1940. y hasta la actualidad. Este indicador cubre los factores físicos y económicos asociados con el ritmo de desarrollo de varias opciones de computación. Por lo tanto, CLEAR se puede utilizar como un indicador cuantitativo independiente de la tecnología, ya que incluye dependencias físicas y económicas fundamentales.

Sobre la base de observaciones y análisis, los autores extraen dos conclusiones clave:

- , ;

- ( ) , (.. CLEAR) ( ) .

El avance de la física fundamental, la gestión de la tecnología de semiconductores y los costos económicos requieren cambios y adaptaciones constantes para hacer avanzar progresivamente la tecnología de los sistemas informáticos. Desde la fundación de la industria de los semiconductores, la Ley de Moore ha cambiado los factores subyacentes varias veces: desde el recuento de transistores, la industria se está desarrollando (primer movimiento) hasta el escalado de huellas y transistores debido a las restricciones de tamaño de la matriz y al aumento de la complejidad general del sistema (ver aquí ).

El segundo salto ocurrió cuando la frecuencia del reloj encontró sus límites debido a las restricciones de disipación de densidad de potencia descritas por la ley de escala de Dennard (ver aquí). A medida que la escala de los transistores se acerca a los límites físicos fundamentales, el número de transistores continúa aumentando en este momento debido al paralelismo implementado en arquitecturas heterogéneas multinúcleo y masivamente paralelas. Esto aumenta el cuello de botella en la interconexión, lo que resulta en la necesidad de desactivar ciertas áreas del chip ( "silicio oscuro" ). Por lo tanto, la tasa de crecimiento ha cambiado de una duplicación inicial cada 12 meses a aproximadamente 24 meses ahora.

Recientemente, ha surgido una nueva fuerza impulsora de un campo completamente diferente que influye en la evolución de los sistemas informáticos y es la fotónica integrada y la nanofotónica híbrida, donde el enrutamiento de la señal de luz se realiza mediante componentes fotónicos integrados pasivos, mientras que los componentes activos electroópticos se amplifican con nuevas soluciones:

- materiales reconfigurables;

- fuertes interacciones de la luz con la materia, como la plasmónica o la fotónica ENZ (epsilion-near-zero), que en conjunto proporcionan un enlace de datos y un ancho de banda que supera a la electrónica convencional en dos niveles: el chip y el núcleo (ver aquí ).

Para estas nuevas tecnologías, simplemente contar la cantidad de componentes en un chip o escalar la huella y el costo como una métrica separada no es posible porque no refleja con mayor precisión el cambio de rendimiento real. También es de gran importancia la tendencia hacia la aparición de otras tecnologías, como las que se utilizan en las comunicaciones ópticas, en las que se empaquetan múltiples señales con diferentes longitudes de onda en el mismo canal físico y así se mejora la utilización del hardware. Este es un factor importante en la evaluación del rendimiento del sistema. En consecuencia, se requiere una métrica holística que tenga en cuenta múltiples fuerzas impulsoras para proporcionar una comparación precisa de la contribución de diferentes soluciones tecnológicas a la evolución de los sistemas informáticos.

Un único indicador de la evolución de los sistemas informáticos

Para obtener una métrica independiente de la tecnología, los autores recopilaron datos sobre el rendimiento de computadoras de escritorio, portátiles, dispositivos móviles, servidores, estaciones de trabajo y supercomputadoras desde la década de 1940 y los compararon con métricas tradicionales (Figura 1).

En particular, la ley de Moore toma el número de transistores como el único factor suficiente (ecuación 1), mientras que la ley de Kumi ya se basa en dos factores: la energía y el número de cálculos, sumando así la base del indicador, medida en bits / (s * J) (ecuación 2). Millones de instrucciones por segundo (MIPS) por unidad de tamaño-costo-potencia se conocen como la métrica de Makimoto, ya definida como una métrica de 4 factores (Ecuación 3).

Ley de Moore = Número de transistores [cant.] (1)

Ley de Kumi= Cálculos / Energía [bits / (s * J)] (2)

Puntaje de Makimoto = Inteligencia / (Tamaño * Costo * Potencia) [MIPS / (mm3 * $ * W)] (3)

Los valores de estos tres indicadores muestran un patrón de crecimiento similar : Una tendencia alcista rastrea bien sus datos originales, pero solo durante un período de tiempo limitado, y finalmente se desvía de ellos. Esto sugiere que los factores tomados como base no han logrado captar completamente la fuerza impulsora real que domina la evolución de los sistemas informáticos.

Análisis de las líneas de tendencia en la Fig. 1 muestra que el número de transistores originalmente (1950-1960) refleja bien la ley de Moore del doble crecimiento anual (línea discontinua verde claro, Fig. 1). Sin embargo, la escala de eficiencia energética (es decir, la ley de Kumi) se convirtió en el factor dominante durante el siguiente período (décadas de 1960 a 1970), ya que la simple adición de más transistores estaba limitada por el tamaño y la complejidad del chip. Por esta razón, la Ley de Moore comenzó a desviarse de la tendencia 2X / año, mientras que la Ley de Makimoto aún mantenía su tasa de crecimiento original. Desde finales de la década de 1970, factores como el tamaño y la escala de potencia han alcanzado gradualmente su límite debido a problemas con procesos de fabricación notablemente más complejos, fugas de energía y disipación de calor.Junto con el advenimiento del paralelismo (es decir, procesadores de múltiples núcleos) y la escala económica en el mercado, la métrica de Makimoto eventualmente también se desvía (desde 1978). Las líneas de puntos que se muestran en la Fig. 1 representan las proyecciones iniciales de crecimiento de la productividad para cada ley. Estas líneas de tendencia muestran cómo cada factor adicional introducido por las leyes correspondientes afecta su propia métrica de pronóstico original, que se muestra como una desviación del pronóstico original. Al considerar esta tendencia como un límite superior teórico de la velocidad del desarrollo de la tecnología, ahora es posible comprender si la tendencia "reivindicada" es realmente "real" o no. Es decir, es la ley actual el motivo de la desaceleración del desarrollo tecnológico, o comienzan a dominar nuevos factores de productividad.también rechazado (desde 1978). Las líneas de puntos que se muestran en la Fig. 1 representan las proyecciones iniciales de crecimiento de la productividad para cada ley. Estas líneas de tendencia muestran cómo cada factor adicional introducido por las leyes correspondientes afecta su propia métrica de pronóstico original, que se muestra como una desviación del pronóstico original. Al considerar esta tendencia como un límite superior teórico de la velocidad del desarrollo de la tecnología, ahora es posible comprender si la tendencia "reivindicada" es realmente "real" o no. Es decir, si la ley actual es la razón de la desaceleración del desarrollo tecnológico o si comienzan a dominar nuevos factores de productividad.también rechazado (desde 1978). Las líneas punteadas que se muestran en la Fig. 1 representan las proyecciones iniciales de crecimiento de la productividad para cada ley. Estas líneas de tendencia muestran cómo cada factor adicional introducido por las leyes correspondientes afecta su propia métrica de pronóstico original, que se muestra como una desviación del pronóstico original. Al considerar esta tendencia como un límite superior teórico de la velocidad del desarrollo de la tecnología, ahora es posible comprender si la tendencia "reivindicada" es realmente "real" o no. Es decir, si la ley actual es la razón de la desaceleración del desarrollo tecnológico o si comienzan a dominar nuevos factores de productividad.cómo cada factor adicional introducido por las leyes relevantes afecta su propia métrica de pronóstico original, que se muestra como una desviación del pronóstico original. Al considerar esta tendencia como un límite superior teórico de la velocidad del desarrollo de la tecnología, ahora es posible comprender si la tendencia "reivindicada" es realmente "real" o no. Es decir, si la ley actual es la razón de la desaceleración del desarrollo tecnológico o si comienzan a dominar nuevos factores de productividad.cómo cada factor adicional introducido por las leyes relevantes afecta su propia métrica de pronóstico original, que se muestra como una desviación del pronóstico original. Al considerar esta tendencia como un límite superior teórico de la velocidad del desarrollo de la tecnología, ahora es posible comprender si la tendencia "reivindicada" es realmente "real" o no. Es decir, es la ley actual el motivo de la desaceleración del desarrollo tecnológico, o comienzan a dominar nuevos factores de productividad.si la ley actual está provocando la desaceleración del desarrollo tecnológico o si comienzan a dominar nuevos factores de productividad.si la ley actual es la razón de la desaceleración del desarrollo tecnológico o si nuevos factores de productividad están comenzando a dominar.

Por lo tanto, hasta la fecha, no existe un indicador claro conocido que pueda:

- explicar los cambios de desempeño recientes;

- proporcionar orientación sobre la predicción del rendimiento futuro.

La métrica CLEAR introducida por los autores incluye factores de desempeño de una variedad de opciones tecnológicas que incluyen restricciones físicas y económicas. La principal afirmación de los autores es que los factores que componen CLEAR no se eligen al azar, sino que son fundamentales para las tendencias tecnológicas y económicas:

CLEAR = Capacidad / (Retraso * Energía * Cantidad * Resistencia) [[MIPS / (s * W * mm3 * $)]] (4)

o en el original:

CLEAR = (Capacidad) / (Latencia * Energía * Cantidad * Resistencia) [[MIPS / (s * W * mm3 * $)]]

Los autores, habiendo formulado una fórmula para el indicador CLEAR, determinan una tasa de crecimiento constante a lo largo de la evolución de los sistemas informáticos, que cubre el crecimiento del rendimiento en 4 órdenes de magnitud durante siete décadas. Además, la tasa de desarrollo real observada se ha duplicado constantemente cada 12 meses. Esta puntuación de 5 factores se basa en el concepto de rendimiento y coste. CLEAR se puede aplicar a nivel de dispositivo, esquema y sistema.

Por ejemplo, a nivel del sistema, CLEAR está estructurado de la siguiente manera: La

capacidad C es el rendimiento del sistema medido por el producto de millones de instrucciones por segundo (MIPS) y la longitud de la instrucción;

retardo mínimo Lse refiere a la frecuencia del reloj y está limitado por la ventana de tiempo entre dos ciclos de reloj adyacentes;

La energía E representa el nivel de consumo de energía para que un sistema de este tipo funcione a fin de obtener una determinada potencia, expresada en unidades de vatios;

La cantidad A representa el volumen espacial (es decir, el tamaño físico) del sistema y es una función de la dimensión del proceso;

Resistance R cuantifica la resistencia económica a la adopción de nuevas tecnologías por parte del mercado. Básicamente, los autores toman un modelo económico basado en la curva de experiencia del Boston Consulting Group (BCG), que explica la relación entre la producción total y el costo unitario (ver aquí ).

Los autores derivan una relación lineal entre la escala logarítmica de la unidad de precio y tiempo, y luego confirman esta relación comparando los datos históricos (ver aquí y aquí ) con CLEAR.

Los autores señalan que la métrica MIPS como medida de rendimiento está siendo reemplazada por métricas como las operaciones de punto flotante (FLOPS) debido a su susceptibilidad al conjunto de instrucciones subyacentes. CLEAR se ha aplicado a varias arquitecturas de procesador a lo largo de la historia para las que no hay otras métricas de rendimiento disponibles en conjuntos de pruebas de referencia conocidos (como SPEC o LINPAC). Sin embargo, para hacer de MIPS una métrica de rendimiento representativa, los autores ponderaron (es decir, multiplicaron) cada instrucción por su longitud, dando así la métrica general relativa en bits / s.

Tendencias de desarrollo de sistemas informáticos

Después de comparar los cuatro indicadores que se muestran en la Fig. 1, encontramos que cuando una métrica incluye factores más relevantes, su punto inicial de desviación de la tendencia original ocurre más tarde. A diferencia de CLEAR, que muestra la coincidencia exacta de los datos en todo. Por lo tanto, encontramos empíricamente que el rendimiento computacional crece constantemente a una tasa fija, aproximadamente se duplica anualmente y es independiente de la tecnología. Cuando probamos nuevas máquinas de computación, como las basadas en fotónica integrada, como predice IBM (ver aquí ), encontramos que tales tecnologías podrían continuar la tendencia evolutiva de desarrollo con un crecimiento anual doble (estrellas rojas en la Fig.1).

Además, encontrará que la desviación relativa de la línea de tendencia 2X / año se puede utilizar para clasificar una métrica de sistema informático. Por ejemplo, los costos generales adicionales (es decir, tamaño físico, simultaneidad, enfriamiento, economías de escala bajas y costos de fabricación) en supercomputadoras muestran sus peores valores CLEAR en comparación con todos los demás tipos de computadoras, como computadoras portátiles y dispositivos móviles, a pesar de su mayor productividad (círculos de puntos, Fig. 1 c, d). El alto paralelismo de las tecnologías multinúcleo utilizadas en las supercomputadoras ha sido desafiado por el retorno de la computación a la energía descrita en la Ley de Amdahl (ver aquí). Aunque las supercomputadoras brindan un rendimiento petaflop, toda la infraestructura se asemeja a una infraestructura informática de hace cinco o treinta años, lo que pone en duda el futuro por su escalabilidad.

Análisis CLARO

Para obtener una comprensión más detallada del impacto relativo de cada uno de los 5 factores CLEAR, los autores descompusieron el indicador en factores individuales, opuestos uno al otro, para revelar las fuerzas impulsoras reales a lo largo del tiempo.

Combinaciones de factores utilizados en la Fig. 2, representan C frente a LEAR, CLE frente a AR y CLEA frente a R (Fig. 2, C = capacidad, L = retraso, E = energía, A = cantidad, R = resistencia). Además, la tasa de exclusión C 'se muestra en comparación con todos los demás factores, ya que el único factor de escala en los primeros años de la industria de los semiconductores es el número de componentes de un chip. Es importante tener en cuenta que las posiciones relativas de cada punto de datos son más importantes que los valores exactos en los ejes X e Y, por lo que ambos ejes se normalizan a uno, lo que permite comparar cada caso.

Dado que las áreas sombreadas en azul y rojo representan áreas de crecimiento lineal y saturación, respectivamente, los cambios sucesivos del punto de pivote hacia la derecha con un número creciente de factores considerados para el eje X (es decir, tiempo relativo) se detectan fácilmente. Para entender esto, los factores en el eje X pueden verse como la fuerza impulsora del indicador, mientras que los valores en el eje Y indican las condiciones reales de seguimiento de las fuerzas impulsoras en cuestión. En consecuencia, el dominio lineal significa que los factores en el eje X aún dominan el desarrollo de la tecnología, mientras que la fuerza impulsora de la tecnología comienza a cambiar a otros factores a medida que ingresa al dominio de saturación. Este resultado coincide con la observación realizada de que la evolución de un sistema informático siempre crece a esta tasa constante, y se produce una discrepancia con el indicador solo sicuando aparecen otras fuerzas impulsoras.

Figura 2. Análisis CLARO de la fuerza impulsora.

El indicador CLEAR se divide en cuatro grupos, cada uno de los cuales consta de dos partes: un coeficiente que demuestra factores en el desarrollo de la tecnología (eje X) y un factor de divulgación, que muestra la capacidad de rastrear un factor seleccionado o una combinación de factores (eje Y). Los resultados muestran que se observa una desviación posterior del desarrollo normalizado cuando se tienen en cuenta más factores para describir el rendimiento de los sistemas informáticos. (a) Velocidad esquiva C 'versus retardo-energía-cantidad-costo (LEAR); (b) Capacidad C versus Demora-Energía-Cantidad-Costo (LEAR); (c) Capacidad de retardo de energía (CLE) versus cantidad-costo (AR); (re)Capacidad de retardo-cantidad-energía (CLEA) versus costo R. Los ejes X e Y están normalizados a uno para una mejor comparación. Las áreas de crecimiento lineal y saturación están cubiertas con sombras azules y rojas, respectivamente.

Aplicación clara

Es importante que la capacidad de rastrear sin problemas la evolución de varias tecnologías le permita a CLEAR predecir las sustituciones tecnológicas futuras y determinar el estándar para la tecnología futura, incluida su hibridación, por ejemplo, entre la electrónica y la fotónica (ver aquí , aquí , aquí y aquí ).

Cambio de tecnologia

La interconexión fotónica en chip ha mostrado recientemente una alta capacidad de transferencia de datos (superior a las interconexiones eléctricas convencionales) cuando se hibrida con dispositivos plasmónicos activos (ver aquí ). Si bien el enrutamiento de datos ópticos se percibe como una posible solución para eliminar los cuellos de botella de comunicación entre los núcleos de cómputo y se usa comúnmente en los centros de datos y supercomputadoras, la fotónica integrada aún no se ha implementado en el sector de consumo convencional. Esto parece sorprendente al principio, ya que estudios previos han sugerido características superiores de hibridación fotón-plasmón. Entonces, la pregunta es, ¿por qué la fotónica integrada no se usa en productos del mercado masivo?

Para responder a esta pregunta, comparemos CLEAR para enlaces electrónicos con enlaces híbridos fotón-plasmón según el tiempo de evolución y la distancia de propagación de la señal (Fig. 3). Aquí, la manipulación de la luz se lleva a cabo utilizando bloques de construcción "activos" plasmónicos (fuente, modulador, detector, interruptor) (ver aquí y aquí), mientras que la propagación de la luz se procesa mediante fotónica de bajas pérdidas basada en plataformas de silicio o nitruro de silicio. La electrónica se compara con esta variante del híbrido plasmón-fotón, porque la separación de la funcionalidad activa y pasiva en un híbrido plasmón-fotónico da como resultado un mayor rendimiento (es decir, menor latencia, mayor rendimiento, menor función de energía por bit). Las curvas de superficie resultantes muestran que la electrónica CLEAR y la plasmón-fotónica tienen una línea de equilibrio (intersección de superficies, Fig. 3), que se escala tanto en el tiempo como en la distancia de propagación de la señal. Curiosamente, incluso hoy en día, la electrónica sigue estando por delante de la fotónica con un tamaño de chip de 1 cm a lo largo de la transferencia de información.Por lo tanto, la electrónica todavía se usa comercialmente en cristales, a diferencia de la fotónica. Las inversiones y desarrollos en electrónica durante el último medio siglo han creado, por tanto, sostenibilidad tecnológica (barreras de entrada) para otras tecnologías. Esta escala ha resultado en que el transistor cueste solo una milmillonésima parte del costo de un dispositivo fotónico, o incluso menos.aquí ). Figura 3. Comparación de indicadores CLEAR de interconexión eléctrica (azul) e híbrida fotón-plasmónica (roja) en un chip, dependiendo de la longitud de la conexión y el tiempo de desarrollo de la tecnología. El tamaño de la viruta = 1 cm, la longitud del enlace y el año de escritura (2019) están marcados en rojo. Se han implementado los siguientes modelos; a) un modelo de ancho de banda basado en el número de transistores y dispositivos ópticos en un chip, que puede considerarse como el modelo original de la ley de Moore; b) un modelo de eficiencia energética basado en la ley de Kumi, que está limitado por el límite de Landauer kB * T * ln (2) ≈ 2.75 sJ / bit, (kB es la constante de Boltzmann; T es la temperatura); a)

un modelo de sostenibilidad económica basado en modelos de desarrollo tecnológico hasta 2019, según el cual el costo de un canal electrónico es menos de mil millones o una millonésima parte del costo de un canal híbrido; d) un modelo de concurrencia (posterior a 2006) que describe la arquitectura multinúcleo y las limitaciones del "silicio oscuro" en la interconexión eléctrica. El punto amarillo se encuentra en la intersección de las dos tecnologías durante 2019, cuando la tecnología Hybrid Plasmon-Photonics acaba de alcanzar el tamaño de un chip y comienza a mostrar el mejor rendimiento CLEAR en un chip.

A medida que la tecnología y los procesos de fabricación mejoran, la distancia de equilibrio de productividad a un precio (es decir, CLEAR) para transmitir pequeñas cantidades de información se reduce debido a la curva de costos más plana de la electrónica en comparación con la fotónica, esta última siguiendo una ley de potencia a lo largo del tiempo. Además, el costo comienza a aumentar con el escalado de la densidad de la interconexión eléctrica, asociado con costos adicionales debido a problemas físicos fundamentales en los nodos de transistores de menos de 10 nm (ver aquí ). Por el contrario, una interconexión híbrida fotón-plasmónica es actualmente costosa debido a la incipiente escala que es el objetivo del Instituto Americano de Fabricación de Fotónica Integrada ( AIM Photonics). La escala es ahora posible como resultado de los recientes avances en nanofotónica; El concepto de mejorar la interacción de la luz con la materia permite crear longitudes de onda compactas en dispositivos optoelectrónicos con las ventajas de una alta eficiencia energética y una alta velocidad de funcionamiento debido a la baja capacitancia eléctrica (ver aquí ). Como resultado, se espera que la distancia de equilibrio entre la electrónica y las tecnologías híbridas de fotón-plasmón cambie distancias aún más cortas a medida que avanzamos en la línea de tiempo. Por ejemplo, el chip fotónico de silicio basado en CMOS que IBM demostró en 2015 está cerca de alcanzar el punto de equilibrio (ver aquí). La fotónica integrada puede reemplazar a la electrónica solo si la velocidad de su desempeño CLEAR puede alcanzar la tendencia evolutiva general de los sistemas informáticos.

conclusiones

Como vimos en el razonamiento anterior, CLEAR puede considerarse como un indicador técnico y económico universal, no solo por su amplia aplicabilidad jerárquica (dispositivos, interconexión, niveles de sistema), sino también por su capacidad de adaptación a una aplicación tecnológica específica. Por ejemplo, para la hibridación de redes dentro de un cristal. CLEAR no solo puede usarse como una métrica de desempeño para predecir la evolución de una plataforma tecnológica, sino que también es posible comparar la capacidad general de la plataforma tecnológica en diferentes condiciones de uso agregando pesos a cada factor en la ecuación (4) .

En esta métrica CLEAR propuesta originalmente, los cinco factores afectan linealmente el valor CLEAR, sin embargo, para una aplicación particular que depende críticamente de un factor particular (o combinación de factores), cada factor en CLEAR puede ponderarse de manera diferente. Para asegurar la comparabilidad, incluso entre tales métricas "ajustadas", puede ser necesario asegurarse de que la suma de todos los coeficientes sea igual a 5, similar a normalizar a la unidad, como la integral de la función de onda en mecánica cuántica. Por ejemplo, un sistema de dispositivo portátil puede tener restricciones severas de energía (E) y volumen (A), lo que da como resultado una métrica CLARO C 0.8 L 0.8 E 1.2 A 1.2 Rpara tal tecnología. De hecho, sería interesante comparar tendencias de diferentes métricas ajustadas con la capacidad de predecir tecnologías en el futuro.

Además, podemos percibir que los canales o redes de comunicación futuros serán reconfigurables dinámicamente, permitiendo que el chip cambie su punto de funcionamiento ideal en función de la aplicación actual, carga, modo de potencia, etc. Tales sistemas dinámicos impulsados por datos ( DDDAS) tienen demanda debido a su capacidad combinada de procesamiento cognitivo. Se espera que la adaptación de los sistemas informáticos a múltiples limitaciones genere sinergias con los sistemas emergentes de teoría de la información, como la computación neuromórfica y de reservorios, donde la adaptación y el ajuste de "pesos" permiten el aprendizaje automático, la aritmética de cálculo residual o incluso la fotónica de silicio integrada de la computación óptica. (ver aquí , aquí , aquí y aquí ).

También vale la pena señalar que, como ha sucedido con todas las métricas de predicción de rendimiento anteriores para plataformas tecnológicas, CLEAR puede eventualmente comenzar a desviarse de su tendencia original cuando se utilicen más características físicas únicas en la nueva tecnología. En la actualidad, CLEAR cubre adecuadamente todos los factores de rendimiento dominantes en las tecnologías modernas, lo que permite predecir con precisión la evolución de los sistemas informáticos en el momento de escribir este artículo.

Por lo tanto, CLEAR puede ser no solo una herramienta para mapear y pronosticar prospectos, sino que también puede allanar el camino para plataformas de control de computadora inteligentes y cognitivas basadas en hardware, donde las compensaciones entre rendimiento y costo se revisan y optimizan en tiempo real.

Como resultado, CLEAR puede verse como una nueva ley de Moore, que refleja integralmente las tendencias en el desarrollo de tecnologías en varios niveles de aplicación jerárquica.