El Apple iPad 11 Pro equipado con lidar tiene un reconocimiento de objetos 3D más profundo y detallado. Para ello, también se utilizan cámaras ToF con diferentes tecnologías para medir el rango de la posición del punto.

Apple ha sido pionera en una carrera para usar lidars en una variedad de productos. Apple ha incorporado lidar en su iPad Pro 11 y ahora parece que todos quieren usar lidar.

La maniobra y reacción de Apple ha impactado a toda la industria electrónica. Los proveedores de chips y sensores están reconsiderando sus planes. Algunos ya han cambiado sus modelos comerciales.

Pero, ¿qué es lidar? Apple eligió este término para describir un nuevo sensor que mide la profundidad, en otras palabras, un sensor que reconoce objetos en tres dimensiones.

El lidar en tabletas y teléfonos inteligentes es esencialmente “solo un tipo de tecnología para reconocer objetos tridimensionales”, explicó Pierre Cambu, analista jefe de la división de fotónica y pantallas de la compañía en Yole Développement.

Muchos ingenieros en diversos campos, ya sean automóviles autónomos, teléfonos inteligentes o tabletas, han explorado formas de utilizar la información de "profundidad" de los datos junto con los píxeles y colores obtenidos de sensores que reconocen objetos bidimensionales. Por ejemplo, los lidars se utilizan en la industria automotriz para determinar distancias a objetos ubicados alrededor de vehículos altamente automatizados.

El iPad 11 Pro recientemente presentado por Apple usa lidar para mejorar su experiencia de realidad aumentada. Este lidar está diseñado para el kit de desarrollo ARkit 3.5 de Apple.

La tecnología especial utilizada para determinar y medir la profundidad hace que este lidar sea esencial. Es esta tecnología la que ha provocado que este sensor sea monitoreado por otros fabricantes de dispositivos móviles, incluidos Huawei y Vivo.

Diferentes métodos de reconocimiento de objetos tridimensionales.

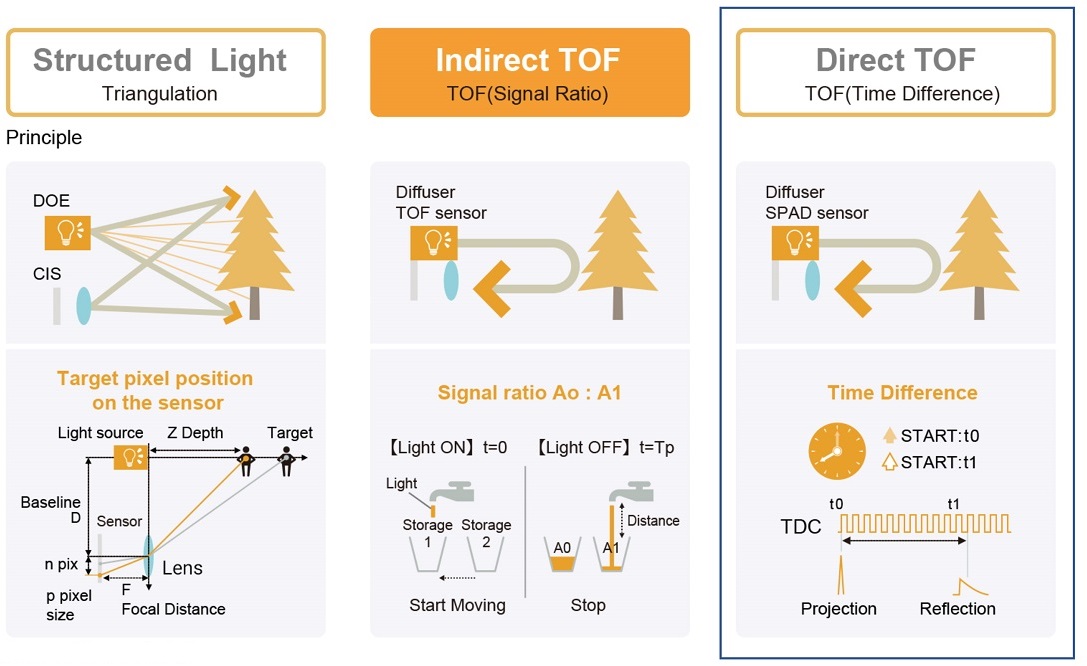

Los ingenieros utilizan una variedad de técnicas para reconocer objetos 3D . Estos incluyen visión estéreo, estructuración de la luz y mediciones de tiempo de vuelo (ToF). Para complicar aún más las cosas, la tecnología ToF ahora está disponible en dos versiones: iToF y dToF. iToF mide el cambio de fase y dToF el tiempo de vuelo directo.

Apple iPhone X cuenta con reconocimiento facial de luz estructurada. Su estimación de profundidad funciona con un emisor de infrarrojos que envía 30.000 puntos en un orden fijo. Los puntos son invisibles para los humanos, pero no para la cámara de infrarrojos, que lee las deformaciones en la plantilla que se reflejan en las superficies a diferentes profundidades.

Con el lanzamiento del iPad 11 Pro, el reconocimiento de objetos 3D se ha vuelto más profundo y detallado gracias al uso de la tecnología dToF. El iPad Pro de Apple es el único producto de consumo que utiliza la tecnología dToF hasta la fecha. Muchos fabricantes de teléfonos inteligentes ya usan iToF para obtener mejores fotos (la cámara ToF puede desenfocar el fondo de las fotos), pero no dToF.

El método de estructuración de la iluminación proporciona una alta precisión para determinar la profundidad, pero su desventaja es el complejo posprocesamiento requerido para calcular la profundidad al hacer coincidir con la muestra.

La ventaja del método dToF, por el contrario, es su capacidad para facilitar el posprocesamiento. Sin embargo, se cree que la dificultad de utilizar esta tecnología radica en el hecho de que se requieren fotodetectores con alta sensibilidad (por ejemplo, fotodiodos de avalancha de fotón único) y de gran tamaño para medir el tiempo de vuelo con una pequeña cantidad de fotones en una dimensión.

Hoy en día, iToF es el método de reconocimiento de objetos 3D más común. Proporciona una detección de profundidad de alta precisión, un posprocesamiento sencillo y una alta resolución espacial mediante el uso de detectores fotográficos de pequeño tamaño que se utilizan comúnmente en sensores de imágenes 2D.

Sin embargo, Apple ha tomado un camino menos trillado para reconocer objetos 3D. La empresa decidió utilizar luz estructurada para identificar rostros. Para la realidad aumentada, Apple usa dToF.

Entonces, aquí están las preguntas que todos en el mundo del reconocimiento de objetos 3D se hacen: ¿Qué es dToF? ¿De qué está hecha esta tecnología? ¿Y quién desarrolló sus componentes?

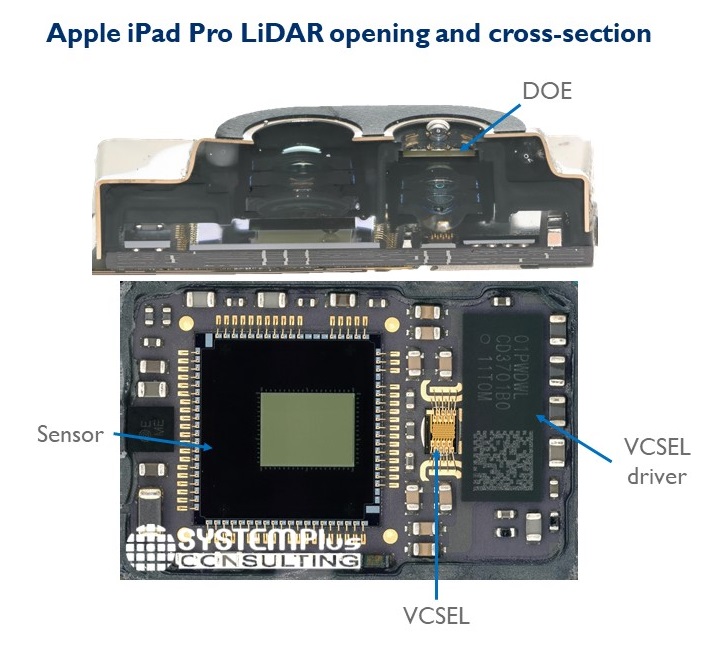

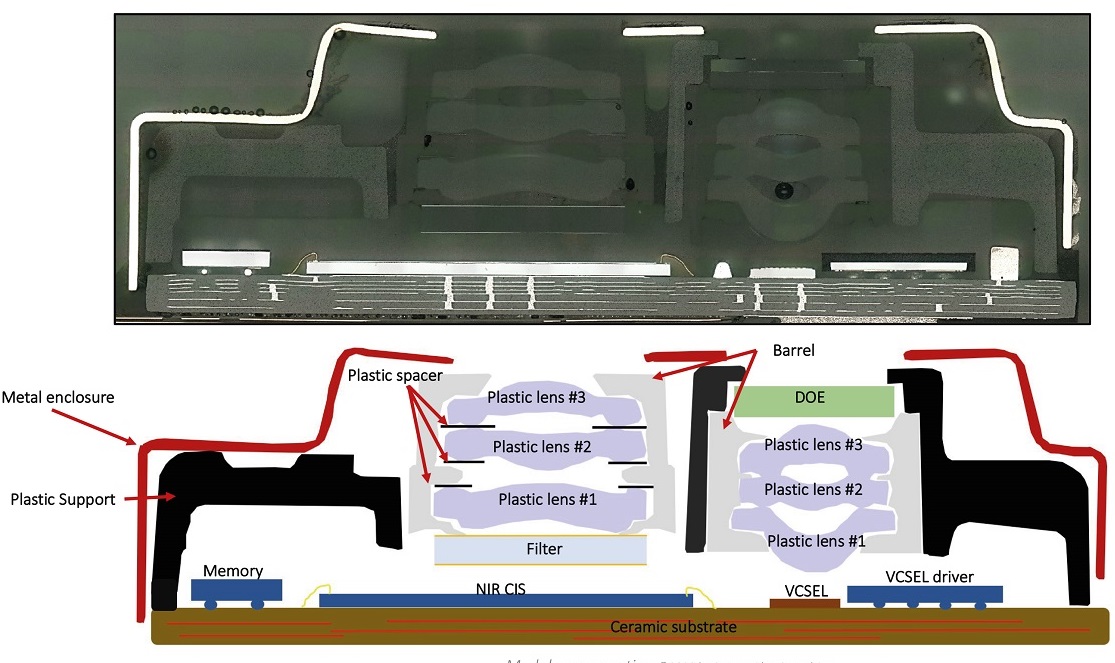

El análisis de System Plus Consulting, una división de Yole Développement, presentó los detalles del módulo de reconocimiento de objetos 3D en el Apple iPad 11 Pro.

En una entrevista con EE Times, Sylvain Hallero, analista senior de tecnología y valor en System Plus, explicó que el lidar del iPad 11 Pro consiste en un láser de emisión vertical (VCSEL) de Lumentum y un receptor desarrollado por Sony, un sensor CMOS de campo cercano. rango de infrarrojos (NIR), que mide el tiempo de vuelo.

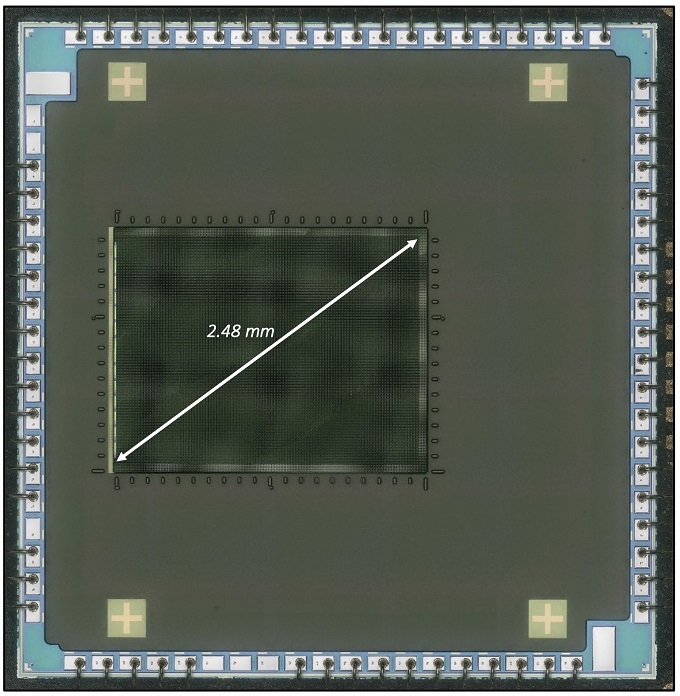

Sensor CMOS de infrarrojo cercano que utiliza fotodiodos de avalancha de fotón único de Sony

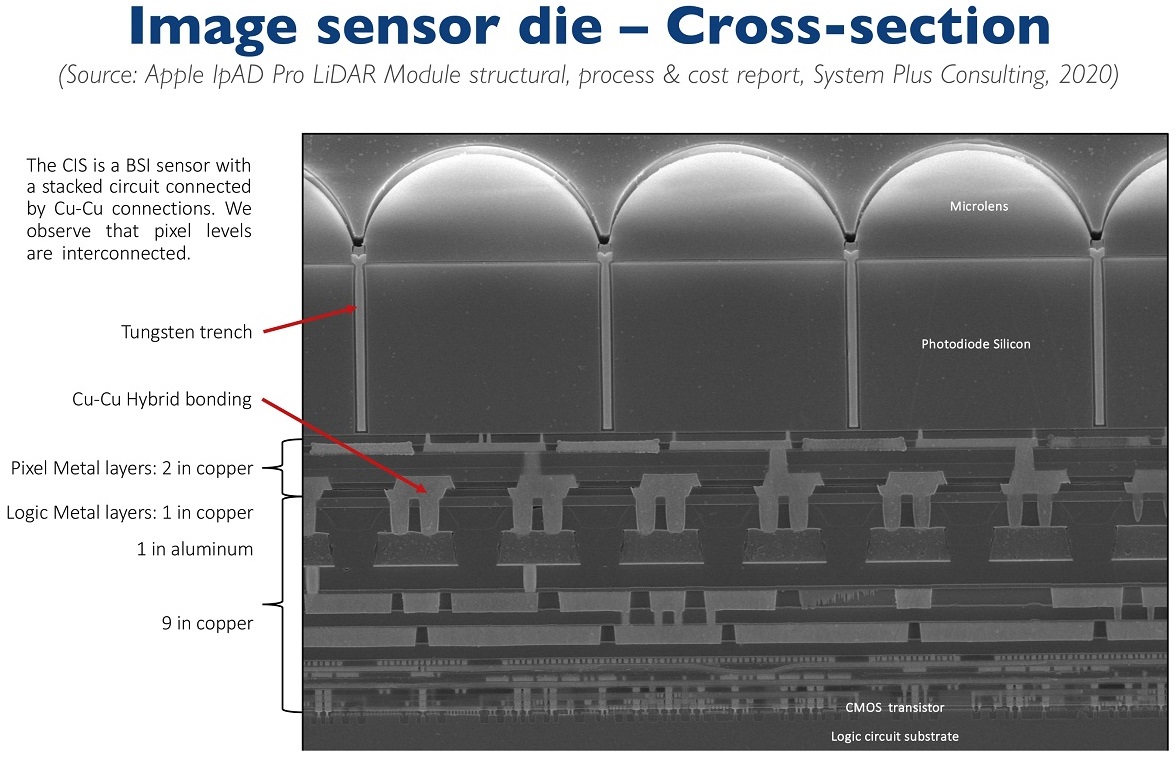

Cortar un sensor CMOS de Sony, como parte de un estudio de su dispositivo, fue una revelación para los expertos que siguieron el desarrollo de la fotónica. Incluso para Kambu, que trabaja para Yole. En una publicación reciente de blog , escribió que lo que "parecía un dispositivo antiguo con iToF y píxeles de 10 micrones" resultó ser el primer sensor CMOS de consumo con una conexión intrapíxel, y sí, estamos hablando de una serie de diodos de avalancha de fotón único ".

La conexión intrapíxel es una propiedad importante. Sony es el primero en integrar un sensor CMOS utilizando apilamiento 3D para sensores ToF. La conexión intrapíxel permitió colocar el sensor de imagen CMOS junto con el sustrato lógico. Gracias a la matriz lógica integrada, el sensor puede realizar cálculos simples de la distancia entre el iPad y los objetos, explicó Hallero.

Sony se ha abierto camino en el segmento dToF con el desarrollo de una nueva generación de sensores CMOS con matrices de diodos de avalancha de fotón único de 10 micrones y 30 kilopíxeles.

Sin embargo, esto no es solo una hazaña tecnológica de Sony. También se trata del hecho de que Sony ha cambiado el concepto de su negocio.

Tradicionalmente, el gigante japonés ha trabajado más en el procesamiento de imágenes. no sobre escaneo. Sin embargo, Kambu afirma que "Sony cambió el nombre de su negocio de semiconductores hace un año a Imaging and Scanning". A continuación, Sony ha dado dos pasos. El primero fue la entrega de sensores iToF a Huawei y Samsung en 2019, lo que le valió a Sony alrededor de $ 300 millones. El segundo paso es ganar el concurso para el desarrollo de sensores dToF para el iPad de Apple ".

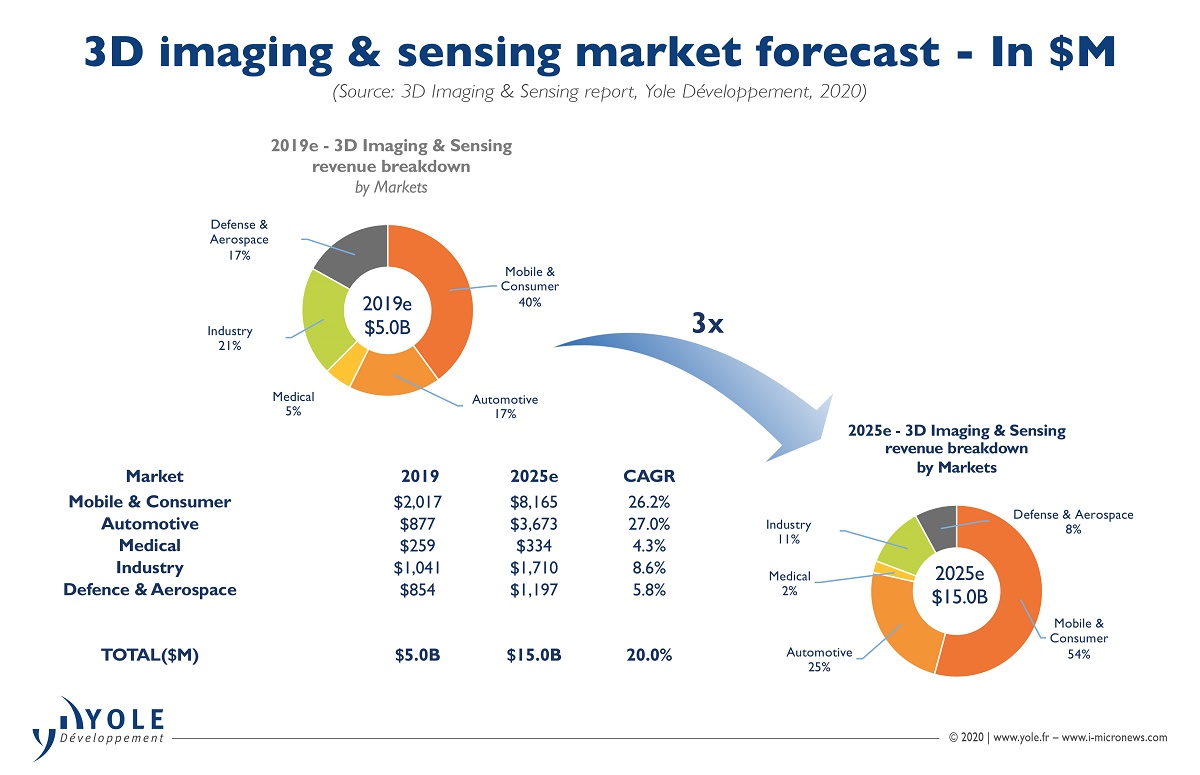

Kambu sospecha que los sensores dToF eventualmente podrían ingresar al iPhone. En su análisis, señala que “es probable que los ingresos por sensores de Sony superen los mil millones de dólares en 2020 en un mercado que acaba de superar la marca de los diez mil millones de dólares. Esta exitosa transición del procesamiento de imágenes al escaneo ha jugado un papel importante en la fortaleza continua de Sony en el mercado de sensores CMOS. Todo esto será la base para la prosperidad de la nueva división ".

Láseres de emisión vertical Lumentum

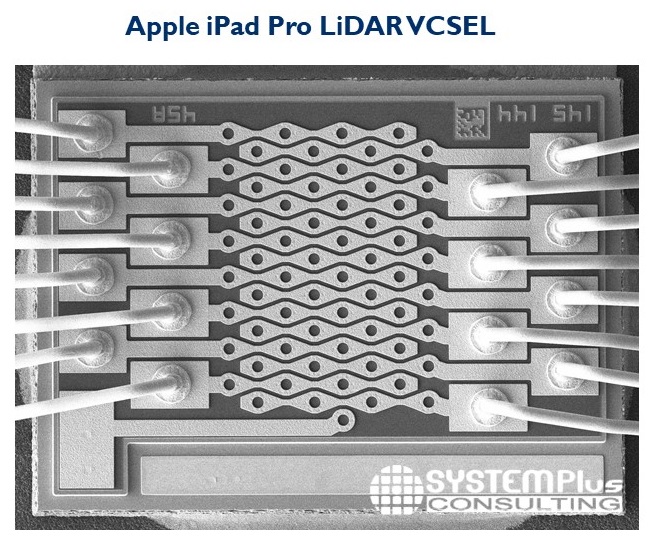

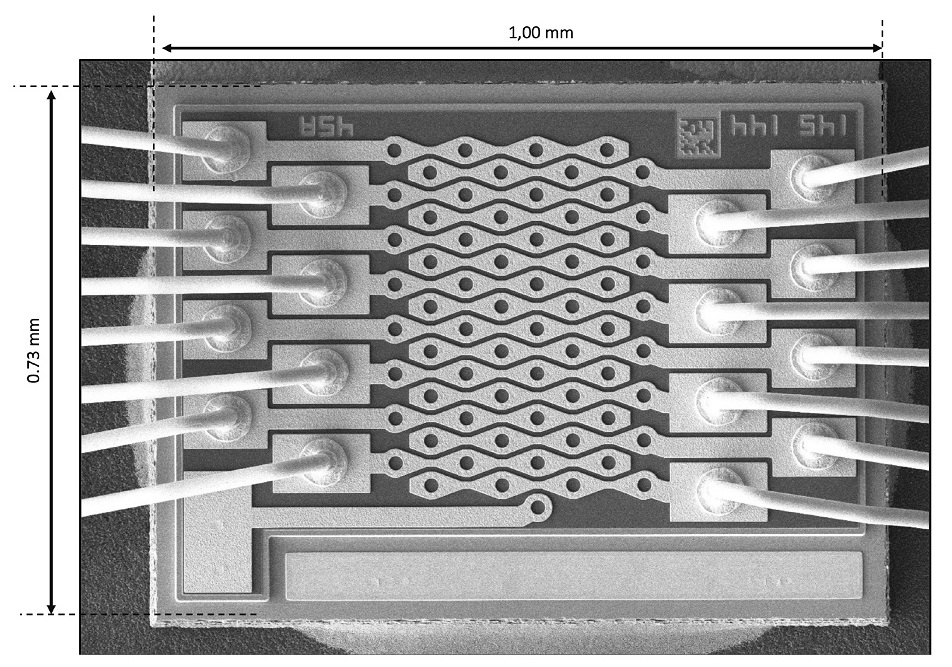

Además del sensor CMOS de Sony, el lidar está equipado con láseres de emisión vertical de Lumentum. En el diseño de estos láseres hay varios electrodos conectados al emisor.

Taha Ayari, analista de tecnología y valor en System Plus, se ha centrado en un nuevo paso de procesamiento (llamado contacto mesa) que Lumentum ha agregado a su láser vertical. Un láser Lumentum emite luz desde la superficie del sustrato. El ajuste fino de la emisión requiere la administración de energía y la aplicación de varios controles a las matrices emisoras. Ayari cree que Lumentum agregó esta tecnología para mejorar las pruebas de componentes en sustratos.

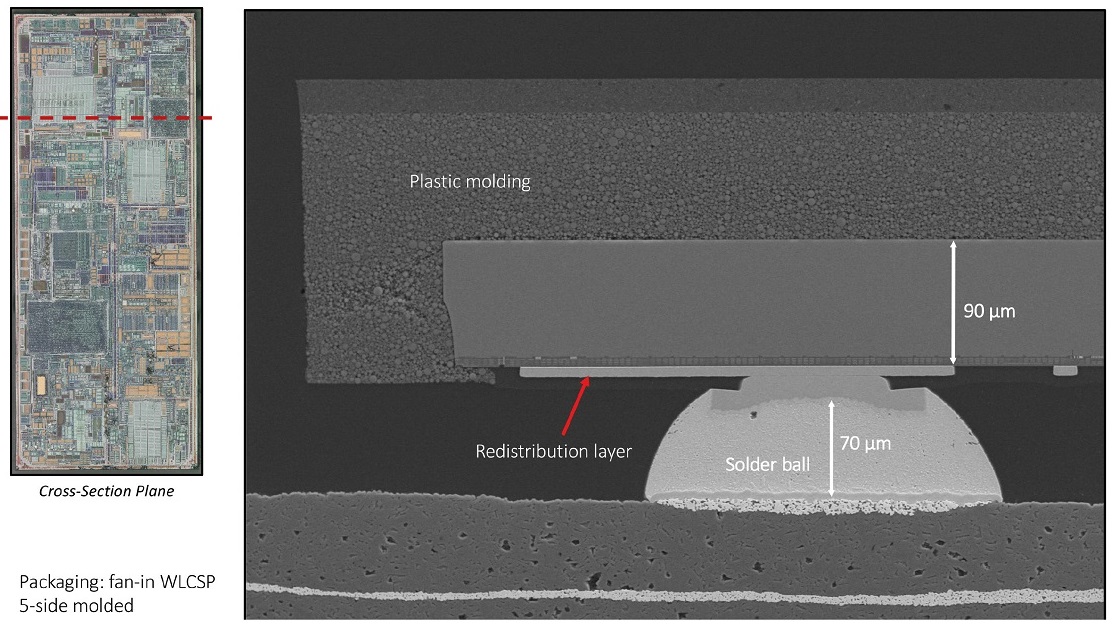

Para generación de pulsos y control de potencia y forma de hazel emisor utiliza un controlador IC de Texas Instruments. El circuito utiliza un paquete basado en obleas (WLCSP) moldeado en cinco lados.

Finalmente, System Plus afirma que el láser de Lumentum utiliza un nuevo elemento óptico difractivo (DOE) de Himax para crear el patrón de puntos.

En las páginas siguientes, compartimos algunas diapositivas creadas por System Plus que ilustran lo que se encontró durante el desmontaje, y también agregamos algunas diapositivas que describen las perspectivas del mercado lidar.

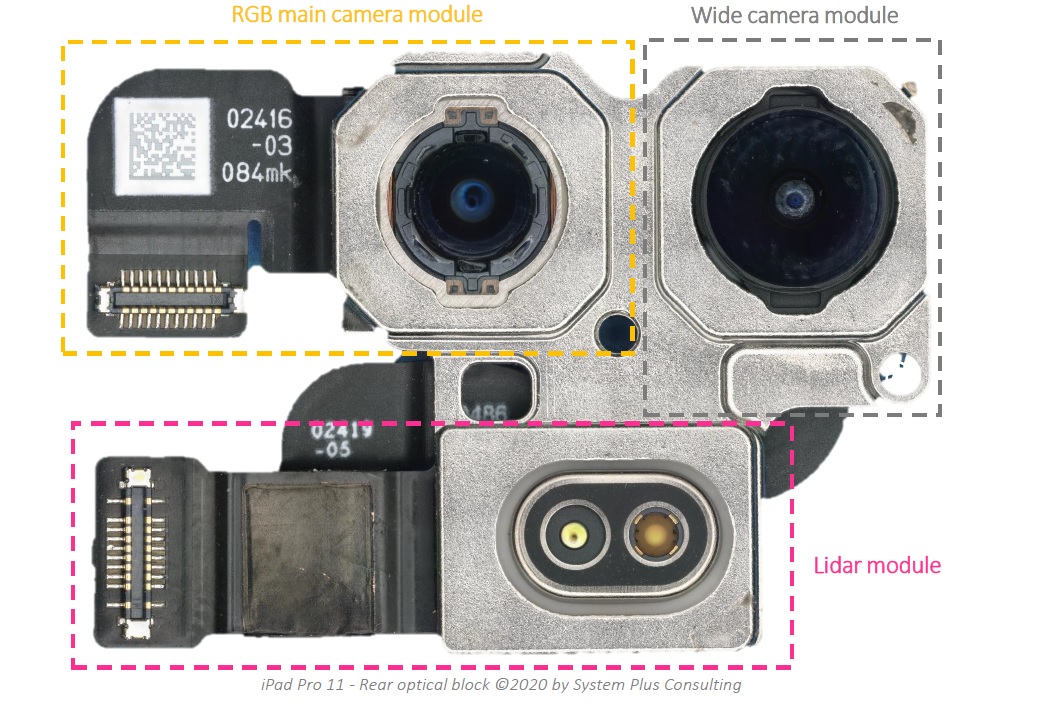

Características del Apple iPad Pro: módulo de cámara principal RGB, módulo de cámara ancha y módulo LiDAR trasero

Así es como se ve la sección transversal del módulo LiDAR.

Descripción general del sensor de imagen

Cómo se ve el dado VCSEL

VCSEL controlador IC empaquetado en abanico en WLCSP 5 Side- VCSEL Conductor La suerte

Difractiva la óptica del elemento

suscribirse a canales:

@TeslaHackers - hackers Comunidad Tesla-rusas, laminados y de formación de la desviación en el Tesla

@AutomotiveRu - noticias de la industria del automóvil, el hierro y la psicología de la conducción

Sobre ITELMA

Lea más artículos útiles:

- Cursos en línea gratuitos en automoción, aeroespacial, robótica e ingeniería (50+)

- [Pronóstico] Transporte del futuro ( a corto plazo , medio plazo , a largo plazo horizontes)

- Los mejores materiales sobre piratería de coches de DEF CON 2018-2019

- [Pronóstico] Motornet: red de intercambio de datos para transporte robótico

- 16 , 8

- open source

- McKinsey: automotive

- …